Trong bối cảnh công nghệ trí tuệ nhân tạo (AI) và điện toán hiệu năng cao (HPC) đang bùng nổ toàn cầu, máy chủ GPU NVIDIA H100 Tensor Core đã trở thành giải pháp then chốt giúp doanh nghiệp tăng tốc các khối lượng công việc từ quy mô doanh nghiệp đến exascale. Được xây dựng trên kiến trúc Hopper đột phá, H100 mang đến hiệu suất vượt trội gấp 4-30 lần so với thế hệ A100 trước đây trong các tác vụ huấn luyện và suy luận AI.

Theo NVIDIA, GPU H100 cung cấp hiệu suất huấn luyện AI nhanh hơn tới 4 lần cho mô hình GPT-3 175B parameters và tăng tốc suy luận lên tới 30 lần cho các mô hình chatbot quy mô lớn với 530 tỷ tham số so với GPU A100.

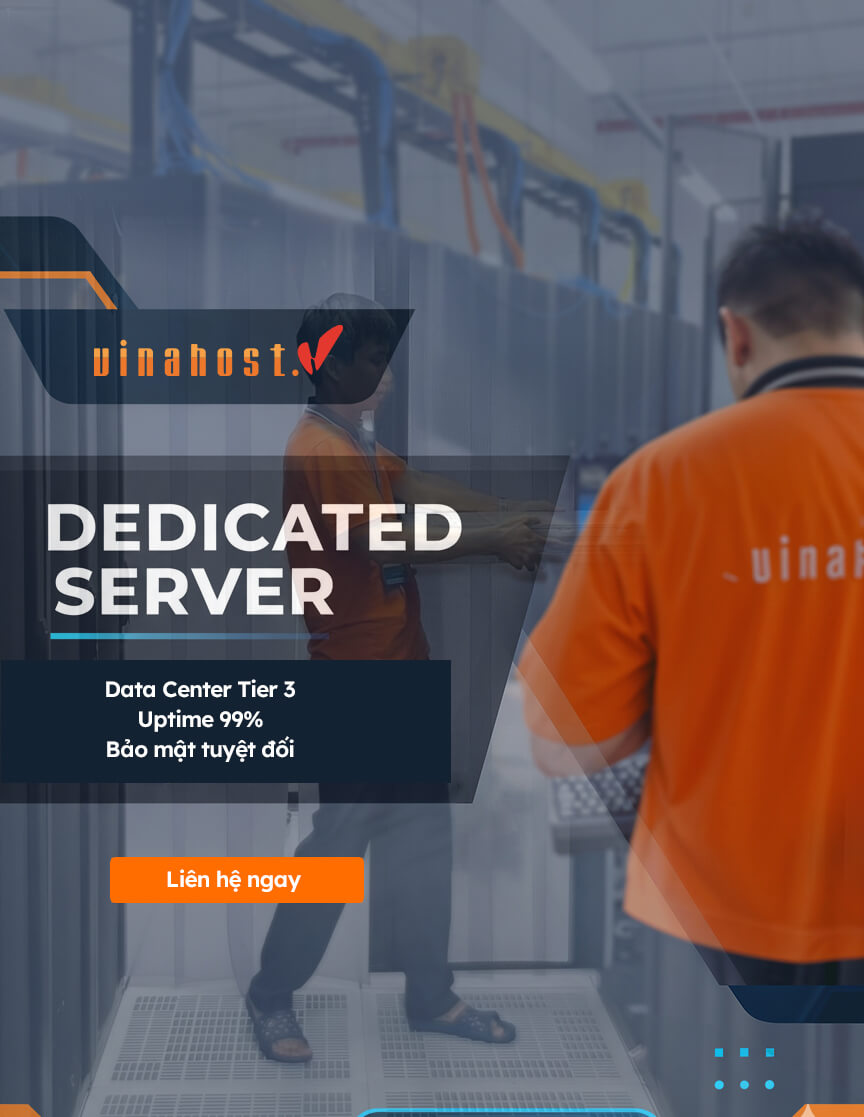

Sau hơn 17 năm hỗ trợ khách hàng triển khai giải pháp máy chủ AI và HPC, VinaHost nhận thấy rằng việc lựa chọn cấu hình máy chủ GPU phù hợp là yếu tố quyết định đến hiệu quả đầu tư và khả năng mở rộng hệ thống trong tương lai. Bài viết này sẽ cung cấp hướng dẫn toàn diện về máy chủ tương thích, thông số kỹ thuật, tính năng và các dòng server phổ biến nhất hiện nay.

1. Giới Thiệu GPU NVIDIA H100 Tensor Core

H100 Là Gì và Tại Sao Nó Quan Trọng?

NVIDIA H100 Tensor Core GPU là bộ xử lý đồ họa thế hệ mới nhất được thiết kế dành riêng cho trung tâm dữ liệu (data center), ra mắt năm 2022 dựa trên kiến trúc Hopper tiên tiến. Đây không đơn thuần là một GPU đồ họa thông thường, mà là một nền tảng điện toán gia tốc toàn diện được tối ưu hóa cho:

- Trí tuệ nhân tạo (AI): Huấn luyện và triển khai các mô hình ngôn ngữ lớn (LLM) với hàng trăm tỷ tham số

- Học sâu (Deep Learning): Xử lý mạng nơ-ron phức tạp với hiệu suất vượt trội

- Điện toán hiệu năng cao (HPC): Mô phỏng khoa học, phân tích dữ liệu quy mô lớn

- Phân tích dữ liệu (Data Analytics): Xử lý và phân tích khối lượng dữ liệu khổng lồ trong thời gian thực

Bước Nhảy Vọt Về Hiệu Suất

Theo đánh giá của đội ngũ chuyên gia VinaHost trong quá trình triển khai thực tế cho khách hàng, H100 mang lại những cải tiến đột phá so với thế hệ trước:

So sánh hiệu suất H100 vs A100:

| Tiêu chí | NVIDIA A100 | NVIDIA H100 | Cải thiện |

|---|---|---|---|

| Huấn luyện GPT-3 (175B) | Chuẩn | 4x nhanh hơn | +300% |

| Suy luận Chatbot (530B) | Chuẩn | 30x nhanh hơn | +2900% |

| HPC FP64 | 9.7 TFLOPS | 60 TFLOPS | +519% |

| Băng thông bộ nhớ | 2 TB/s (HBM2e) | 3 TB/s (HBM3) | +50% |

| Kết nối NVLink | 600 GB/s | 900 GB/s | +50% |

| Hỗ trợ PCIe | Gen 4 | Gen 5 | 128 GB/s |

Kiến trúc Hopper tích hợp Transformer Engine thế hệ thứ 4 với độ chính xác FP8, cho phép xử lý các mô hình Transformer với hiệu suất cao hơn đáng kể mà vẫn duy trì độ chính xác cần thiết cho AI.

Các Phiên Bản H100 Trên Thị Trường

Hiện nay, NVIDIA cung cấp H100 với 3 dạng form factor chính:

H100 SXM5 (700W TDP)

- Kết nối trực tiếp qua NVLink và NVSwitch

- Hiệu suất tối đa, phù hợp cho hệ thống 8 GPU

- Yêu cầu bo mạch chủ chuyên dụng

H100 PCIe (350W TDP)

- Cắm vào khe PCIe Gen5 tiêu chuẩn

- Linh hoạt hơn trong triển khai

- Phù hợp cho server 2-4 GPU

H100 NVL (PCIe với NVLink)

- Kết hợp ưu điểm của PCIe và NVLink

- 188GB bộ nhớ HBM3 (cao nhất)

- Tối ưu cho LLM tới 70B parameters

Trong quá trình tư vấn cho khách hàng, chúng tôi thường đề xuất phiên bản H100 SXM5 cho các dự án AI quy mô lớn cần hiệu suất tối đa, trong khi H100 PCIe phù hợp hơn cho các doanh nghiệp vừa và nhỏ có nhu cầu linh hoạt về cấu hình.

2. Cấu Hình Máy Chủ Tương Thích Với GPU NVIDIA H100

Yêu Cầu Phần Cứng Tối Thiểu

Để khai thác tối đa sức mạnh của GPU H100, máy chủ cần đáp ứng các yêu cầu kỹ thuật nghiêm ngặt:

Bộ Vi Xử Lý (CPU)

- Intel: Xeon Scalable thế hệ 4 hoặc 5 (Sapphire Rapids, Emerald Rapids)

- AMD: EPYC 9004 Series (Genoa) trở lên

- Khuyến nghị: Tối thiểu 2 CPU socket để đảm bảo băng thông PCIe đầy đủ

Bộ Nhớ RAM

- Loại: DDR5 (4800 MT/s trở lên)

- Dung lượng tối thiểu:

- 512GB cho cấu hình 2-4 GPU

- 1TB cho cấu hình 6-8 GPU

- Số khe cắm: 24-32 khe để đảm bảo khả năng mở rộng

Nguồn Điện (PSU)

- H100 SXM5: 700W/GPU + overhead hệ thống

- Hệ thống 8 GPU: Yêu cầu 6000-7000W (thường dùng nguồn dự phòng 2+2)

- H100 PCIe: 350W/GPU + overhead

- Hệ thống 4 GPU: Yêu cầu 2000-2500W

Một hệ thống máy chủ 8 GPU H100 SXM5 có thể tiêu thụ công suất tối đa lên tới 10.2 kilowatts, bao gồm cả hệ thống làm mát và các thành phần phụ trợ.

Hệ Thống Làm Mát

- Làm mát bằng không khí: Yêu cầu luồng khí mạnh, nhiều quạt công suất lớn

- Làm mát bằng chất lỏng (Liquid Cooling):

- Khuyến nghị cho cấu hình 6-8 GPU SXM5

- Giảm tiếng ồn và nhiệt độ hoạt động

- Hiệu quả năng lượng cao hơn 20-30%

Kết Nối và Băng Thông

PCIe Gen 5.0

H100 là GPU đầu tiên hỗ trợ PCIe Gen 5, mang lại:

- Băng thông: 128 GB/s (hai chiều)

- Gấp đôi so với PCIe Gen 4

- Loại bỏ nút thắt cổ chai trong truyền dữ liệu

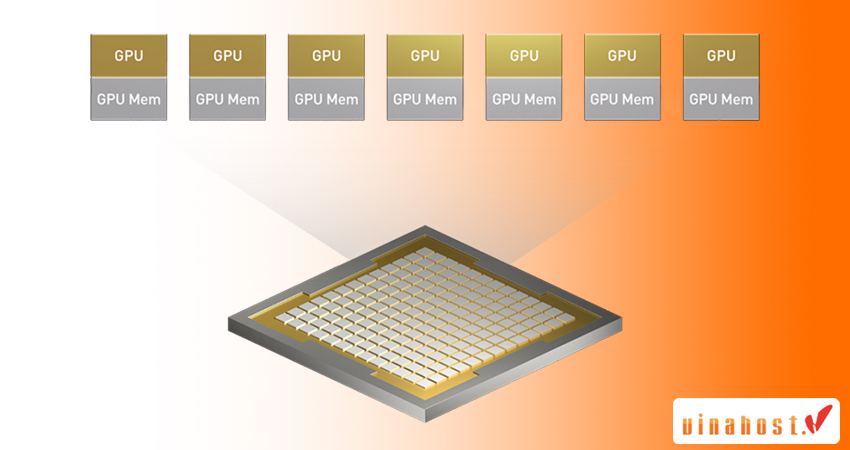

NVIDIA NVLink & NVSwitch

Đối với cấu hình đa GPU, NVLink là yếu tố then chốt:

- NVLink thế hệ 4: 900 GB/s giữa các GPU

- NVSwitch: Kết nối trực tiếp tới 256 GPU trong cụm lớn

- Giảm độ trễ, tăng hiệu suất huấn luyện mô hình phân tán

Mạng Tốc Độ Cao

- Ethernet: Tối thiểu 25GbE, khuyến nghị 100GbE hoặc 400GbE

- InfiniBand: NDR (400 Gb/s) cho môi trường HPC

- Tích hợp với NVIDIA Magnum IO để tối ưu throughput

Lưu Trữ Hiệu Năng Cao

Dựa trên kinh nghiệm triển khai của VinaHost, hệ thống lưu trữ cần:

- Boot Drive: NVMe PCIe Gen4 x4 (tối thiểu 480GB)

- Data Storage:

- NVMe U.2/U.3 cho dataset training (khuyến nghị 8-24 drive)

- Tốc độ đọc/ghi: >3000 MB/s để tránh GPU idle

- Dung lượng:

- 10-50TB cho dự án AI vừa

- 100TB+ cho training dataset quy mô lớn

3. Thông Số Kỹ Thuật Chi Tiết Của Dòng Card H100

Bảng Thông Số Kỹ Thuật Đầy Đủ

| Thông số | H100 SXM5 | H100 PCIe | H100 NVL |

|---|---|---|---|

| Kiến trúc | Hopper | Hopper | Hopper |

| Quy trình sản xuất | TSMC 4N | TSMC 4N | TSMC 4N |

| Số lượng transistor | 80 tỷ | 80 tỷ | 80 tỷ |

| CUDA Cores | 16,896 | 14,592 | 14,592 |

| Tensor Cores (Gen 4) | 528 | 456 | 456 |

| Bộ nhớ GPU | 80GB HBM3 | 80GB HBM3 | 188GB HBM3 |

| Băng thông bộ nhớ | 3 TB/s | 2 TB/s | 7.8 TB/s |

| TDP | 700W | 350W | 400W x 2 |

| Hiệu suất FP64 | 60 TFLOPS | 51 TFLOPS | 51 TFLOPS |

| Hiệu suất FP32 | 120 TFLOPS | 103 TFLOPS | 103 TFLOPS |

| Hiệu suất FP16 | 240 TFLOPS | 206 TFLOPS | 206 TFLOPS |

| Hiệu suất FP8 | 480 TFLOPS | 412 TFLOPS | 412 TFLOPS |

| NVLink | 900 GB/s | Không | 900 GB/s |

| PCIe | Gen 5 x16 | Gen 5 x16 | Gen 5 x16 |

| MIG (Multi-Instance GPU) | 7 instances | 7 instances | Không |

Công nghệ được tính hợp

Mô hình Transformer Engine (TE)

Đây là công nghệ được phát triển với mục tiêu cốt lõi là tăng tốc quá trình học máy và suy luận từ mô hình Transformer. TE cho phép:

- Tự động chuyển đổi giữa FP8 và FP16

- Giảm 50% memory footprint

- Tăng tốc huấn luyện LLM lên tới 9 lần

- Duy trì độ chính xác tương đương FP16

Multi-Instance GPU (MIG)

MIG là công nghệ cho phép phân chia 1 GPU vật lý thành nhiều GPU instance. Cụ thể, nó cho phép phân chia 1 GPU H100 thành tối đa 7 instance độc lập:

- 1x Full GPU: Toàn bộ tài nguyên

- 2x 3g.40gb: Mỗi instance có 3/7 compute, 40GB memory

- 3x 2g.20gb: 2/7 compute, 20GB memory

- 7x 1g.10gb: 1/7 compute, 10GB memory

MIG cho phép các tổ chức tối đa hóa sử dụng GPU bằng cách chạy nhiều workload nhỏ độc lập trên cùng một GPU, giảm chi phí và tăng ROI lên tới 70%.

Trong thực tế triển khai cho khách hàng, chúng tôi thấy MIG đặc biệt hữu ích cho:

- Môi trường đa thuê bao (multi-tenant)

- CI/CD pipelines cho ML

- Development và testing

- Inference serving với nhiều models khác nhau

Confidential Computing

Confidential Computing cho phép mã hóa dữ liệu trong quá trình xử lý. Nvidia H100 là GPU đầu tiên có tính năng điện toán bảo mật phần cứng tích hợp với công nghê:

- Trusted Execution Environment (TEE)

- Bảo vệ mô hình AI khỏi bị đánh cắp

- Tuân thủ các tiêu chuẩn bảo mật ngành

DPX Instructions

Mục tiêu của thuật toán DPX là nhằm tăng tốc các thuật toán dynamic programming (lập trình động – kỹ thuật nhằm bóc tách một bài toán khó thành các vấn đề nhỏ và xử lý từng phần riêng lẻ). Nó thực hiện điều này bằng cách tích hợp tác vụ xử lý logic vào trực tiếp phần cứng của GPU.

Hiệu Suất Thực Tế: Đánh Giá và So Sánh

Từ kinh nghiệm của đội ngũ VinaHost khi làm việc với các khách hàng:

Huấn luyện AI

- GPT-3 175B: Nhanh gấp 4 lần A100 (thời gian rút ngắn từ 4 tuần xuống 1 tuần)

- ResNet-50: Nhanh gấp 2.5 lần A100

- BERT-Large: Nhanh gấp 3 lần A100

Suy luận AI

- Llama 2 70B: Giảm độ trễ 70% so với A100

- Stable Diffusion: Gấp đôi thông lượng

- Nhận diện giọng nói: Nhanh gấp 5 lần thời gian lấy token đầu tiên

Ứng dụng HPC:

- GROMACS (động lực học phân tử): Tăng 60% hiệu suất

- NAMD: Tăng 80% hiệu suất

- Mô phỏng thời tiết: Tăng 120% hiệu suất

4. Tính Năng và Các Tác Vụ GPU H100 Có Thể Xử Lý

Trí Tuệ Nhân Tạo và Machine Learning

Huấn Luyện Các Mô Hình Ngôn Ngữ Lớn (LLM)

H100 được NVIDIA tối ưu hóa riêng cho việc training các mô hình ngôn ngữ siêu lớn. Dưới đây là những mô hình phổ biến mà GPU này xử lý mượt mà:

Các mô hình được hỗ trợ tốt nhất:

- GPT series – Bao gồm GPT-3, GPT-4, GPT-J với quy mô lên tới 175B+ tham số

- LLaMA series – Các phiên bản LLaMA 2 từ 7B, 13B đến 70B parameters

- BLOOM – Mô hình đa ngôn ngữ khổng lồ với 176B tham số

- PaLM – Pathways Language Model của Google

- Claude – Dòng mô hình AI hiến định từ Anthropic

Kết quả thực tế từ khách hàng VinaHost:

Sau khi triển khai H100 cho các dự án AI, chúng tôi ghi nhận được những con số ấn tượng: thời gian training giảm 60-75%, chi phí cloud computing tiết kiệm 40-50%, đồng thời khách hàng có thể thử nghiệm nhiều mô hình hơn trong cùng một khoảng thời gian.

Computer Vision và Xử Lý Hình Ảnh

GPU H100 thể hiện sức mạnh vượt trội trong các tác vụ thị giác máy tính:

Phát hiện và phân đoạn đối tượng:

- Object Detection với YOLO, Faster R-CNN, RetinaNet

- Segmentation sử dụng Mask R-CNN, U-Net, DeepLab

Tạo và xử lý hình ảnh:

- Stable Diffusion (nhanh gấp đôi so với thế hệ trước)

- Các mô hình kiểu DALL-E 2

- StyleGAN và BigGAN cho sinh ảnh chất lượng cao

Ứng dụng chuyên sâu:

- Video Analytics – Theo dõi đối tượng và nhận diện hành động real-time

- Medical Imaging – Phân tích CT scan, phân loại X-quang, phân đoạn MRI

Nhờ có Transformer Engine, H100 xử lý được batch size lớn gấp 2-3 lần A100 khi làm việc với Vision Transformer (ViT), giúp rút ngắn đáng kể thời gian training cho các bài toán phân loại hình ảnh.

Xử Lý Ngôn Ngữ Tự Nhiên (NLP)

H100 đáp ứng mượt mà các tác vụ NLP từ cơ bản đến nâng cao:

- Named Entity Recognition (NER) – Nhận diện thực thể có tên

- Sentiment Analysis – Phân tích cảm xúc quy mô lớn

- Machine Translation – Dịch thuật đa ngôn ngữ theo thời gian thực

- Question Answering – Hệ thống hỏi đáp thông minh

- Text Summarization – Tóm tắt tài liệu dài một cách hiệu quả

- Speech-to-Text – Chuyển đổi giọng nói với độ chính xác cao

Điện Toán Hiệu Năng Cao (HPC)

Mô Phỏng Khoa Học

- Hóa học lượng tử giúp tính toán cấu trúc phân tử phức tạp một cách chi tiết.

- Mô hình khí hậu mang đến khả năng dự báo thời tiết và phân tích biến đổi khí hậu chính xác hơn.

- Động lực học chất lỏng tính toán (CFD), công nghệ này hỗ trợ thiết kế hàng không và ô tô hiệu quả.

- Vật lý thiên văn, H100 cho phép mô phỏng vũ trụ và các hố đen

- Vật lý hạt nhân tận dụng sức mạnh này để mô phỏng phản ứng hạt nhân.

Genomics và Sinh Học Tính Toán

Giải trình tự DNA nhanh hơn với thuật toán Smith-Waterman – gấp 7 lần so với A100. Quá trình lắp ráp và chú thích genome cũng được đẩy nhanh đáng kể.

Dự đoán cấu trúc protein thông qua AlphaFold2 và RoseTTAFold mở ra cánh cửa mới cho nghiên cứu sinh học. Trong phát triển thuốc, H100 xử lý molecular docking và sàng lọc ảo hàng triệu hợp chất một cách hiệu quả. Phân tích tế bào đơn cho phép nghiên cứu biểu hiện gene ở mức độ chi tiết chưa từng có.

Tài Chính và Phân Tích Rủi Ro

Mô phỏng Monte Carlo giúp phân tích rủi ro danh mục đầu tư toàn diện hơn. Giao dịch thuật toán tận dụng H100 để backtest chiến lược một cách nhanh chóng.

Hệ thống phát hiện gian lận hoạt động real-time, trong khi đánh giá rủi ro cho tín dụng và bảo hiểm trở nên chính xác và nhanh gọn.

Phân Tích Dữ Liệu Lớn

Xử Lý Dữ Liệu với GPU-Accelerated Frameworks

Apache Spark kết hợp RAPIDS tạo nên bước nhảy vọt về tốc độ. Các truy vấn data warehousing được tăng tốc nhờ GPU, trong khi quy trình ETL (Extract, Transform, Load) nhanh hơn 10-50 lần so với phương pháp truyền thống. Phân tích real-time với Apache Kafka xử lý stream processing mượt mà hơn bao giờ hết.

Hệ Thống Gợi Ý

Collaborative Filtering xây dựng hệ thống recommend sản phẩm thông minh. Deep Learning Recommendations áp dụng Neural Collaborative Filtering và mô hình Two-tower để nâng cao trải nghiệm. Cá nhân hóa real-time mang đến trải nghiệm người dùng được tùy chỉnh linh hoạt.

Các nền tảng lớn như Amazon và Netflix xử lý hàng tỷ tương tác mỗi ngày. H100 cho phép training với dataset khổng lồ và cập nhật model liên tục, cải thiện độ chính xác 15-25% – một con số ấn tượng trong ngành công nghiệp này.

Rendering và Sáng Tạo Nội Dung

3D Rendering và Animation

Ray tracing tạo ra chất lượng hình ảnh đỉnh cao. Sản xuất CGI cho phim ảnh và quảng cáo trở nên mượt mà hơn. Visualization kiến trúc 3D giúp kiến trúc sư thể hiện ý tưởng sống động, trong khi thiết kế sản phẩm được prototype visualization một cách chi tiết.

Nội Dung Tạo Bởi AI

Text-to-Image với Stable Diffusion và các công nghệ tương tự mở ra khả năng sáng tạo vô hạn. Text-to-Video tạo video từ mô tả văn bản. Image Enhancement nâng cấp độ phân giải và phục hồi ảnh cũ, còn Style Transfer chuyển đổi phong cách nghệ thuật một cách tự nhiên.

Xem thêm cấu hình: Nvidia Quadro RTX A2000

Hệ Thống Tự Động và Robotics

Xe tự lái sử dụng H100 cho nhận diện môi trường (camera, LiDAR, radar fusion), lập kế hoạch đường đi, ra quyết định và training qua simulation.

Điều hướng drone tự động xử lý bay tự động và tránh vật cản thông minh. Robot công nghiệp thực hiện pick-and-place và kiểm tra chất lượng chính xác. Robot nông nghiệp giám sát mùa màng và canh tác chính xác, tối ưu năng suất.

Edge AI và IoT

Dù H100 chủ yếu hoạt động trong data center, vai trò của nó trong Edge AI không thể phủ nhận:

- Training Edge Models: Huấn luyện các mô hình gọn nhẹ cho thiết bị đầu cuối

- Federated Learning: Học phân tán từ nhiều nguồn dữ liệu khác nhau

- Knowledge Distillation: Chuyển đổi mô hình lớn thành phiên bản nhỏ gọn, phù hợp triển khai thực tế

5. Các Dòng Máy Chủ Trang Bị NVIDIA Tesla H100 trên thị trường

5.1. Server Tích Hợp 4 GPU NVIDIA H100

Cấu hình 4 GPU là lựa chọn cân bằng giữa hiệu suất và chi phí, phù hợp cho doanh nghiệp vừa và nhỏ.

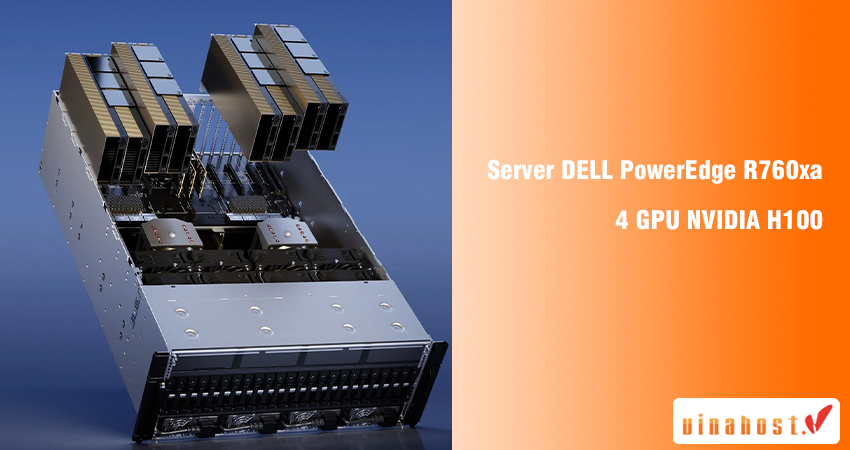

DELL PowerEdge R760xa

Thông số kỹ thuật nổi bật:

- Form Factor: 2U Rack Server

- CPU: Dual Intel Xeon Scalable Gen 4/5 (up to 350W TDP)

- Memory: 32 khe DDR5 RDIMM (tối đa 8TB @ 5600 MT/s)

- GPU Support: 4x H100 PCIe hoặc 4x H100 SXM5

- Storage: 24x 2.5″ drive bays (NVMe/SAS/SATA)

- Networking: 2x 1GbE onboard, optional 25/100GbE

- Power: Redundant PSU (2000W – 3000W tùy cấu hình)

Ưu điểm:

- ✅ Dell iDRAC9: Quản lý từ xa mạnh mẽ

- ✅ Bảo hành ProSupport Plus 24/7

- ✅ Hỗ trợ cả PCIe và SXM5 variants

- ✅ Thermal management tốt

Nhược điểm:

- ❌ Giá cao hơn đối thủ 10-15%

- ❌ Cấu hình phức tạp, cần chuyên gia

Giá tham khảo: $150,000 – $250,000 (tùy cấu hình)

Phù hợp cho:

- Doanh nghiệp có ngân sách tốt, ưu tiên support

- Môi trường production cần uptime cao

- Khách hàng đã sử dụng hạ tầng Dell

HPE ProLiant DL380a Gen11

Thông số kỹ thuật:

- Form Factor: 2U Rack Server

- CPU: Dual Intel Xeon Scalable Gen 4/5 (up to 350W)

- Memory: 32 khe DDR5 (tối đa 8TB @ 5600 MT/s)

- GPU: 4x H100 PCIe hoặc SXM5

- Storage: 28x SFF drive bays

- Networking: HPE FlexibleLOM, optional HDR InfiniBand

- Management: HPE iLO 6

Ưu điểm:

- ✅ HPE iLO quản lý toàn diện

- ✅ Tích hợp tốt với HPE GreenLake (cloud hybrid)

- ✅ Thiết kế modular, dễ nâng cấp

- ✅ Hiệu quả năng lượng tốt

Nhược điểm:

- ❌ Ít tùy chọn GPU hơn Dell

- ❌ Lead time giao hàng dài (2-3 tháng)

Giá tham khảo: $145,000 – $240,000

Phù hợp cho:

- Doanh nghiệp đang dùng HPE ecosystem

- Cần tích hợp cloud hybrid

- Ưu tiên quản lý tập trung

H3C UniServer R4900 G6

Thông số kỹ thuật:

- Form Factor: 2U Rack Server

- CPU: Dual Intel Xeon Scalable Gen 4/5

- Memory: 32 khe DDR5 (tối đa 6TB @ 5600 MT/s)

- GPU: 4x H100 PCIe (double-width) hoặc 8x single-width

- Storage: 12x 3.5″ + 12x 2.5″ hybrid bays

- PCIe: 10x Gen5 slots

Ưu điểm:

- ✅ Giá cạnh tranh nhất (thấp hơn 20-30% so với Dell/HPE)

- ✅ Linh hoạt về storage

- ✅ Nhiều khe PCIe cho mở rộng

- ✅ Hỗ trợ tốt tại thị trường Châu Á

Nhược điểm:

- ❌ Thương hiệu ít phổ biến tại Việt Nam

- ❌ Support và warranty không rộng khắp như Dell/HPE

- ❌ Tài liệu tiếng Anh hạn chế

Giá tham khảo: $120,000 – $190,000

Phù hợp cho:

- Startups, SMB có ngân sách hạn chế

- Dự án POC (Proof of Concept)

- Khách hàng ưu tiên cost-performance

Supermicro SuperServer SYS-221GE-TNHT-LCC

Thông số kỹ thuật:

- Form Factor: 2U Rack Server

- CPU: Dual Intel Xeon Scalable Gen 4/5

- Memory: 32 khe DDR5 (tối đa 8TB)

- GPU: 4x H100 SXM5 hoặc PCIe

- Cooling: Hỗ trợ liquid cooling option

- Storage: 24x 2.5″ NVMe/SAS/SATA

Ưu điểm:

- ✅ Tùy biến cấu hình linh hoạt nhất

- ✅ Hỗ trợ liquid cooling cho thermal tốt

- ✅ Build quality cao

- ✅ Phù hợp cho custom workload

Nhược điểm:

- ❌ Cần kiến thức chuyên sâu để cấu hình

- ❌ Support phụ thuộc vào đại lý

- ❌ Warranty không comprehensive như Dell

Giá tham khảo: $135,000 – $215,000

Phù hợp cho:

- HPC labs, research institutions

- Khách hàng có team IT mạnh

- Cần cấu hình custom cho workload đặc biệt

5.2. Server Tích Hợp 8 GPU NVIDIA H100

Cấu hình 8 GPU là lựa chọn cho các tổ chức cần hiệu suất tối đa cho AI và HPC.

ASUS ESC8000-E11P

Thông số kỹ thuật:

- Form Factor: 4U Rack Server

- CPU: Dual Intel Xeon Scalable Gen 5 (up to 350W)

- Memory: 32 khe DDR5 RDIMM (tối đa 8TB @ 5600 MT/s)

- GPU: 8x H100 SXM5 với NVLink

- Storage: 10x 2.5″ NVMe bays

- Networking: 2x 10GbE, optional 100GbE/InfiniBand

- Power: 6000W Redundant PSU (2+2)

Ưu điểm:

- ✅ Thermal design xuất sắc cho 8 GPU

- ✅ NVLink full bandwidth giữa các GPU

- ✅ ASUS Control Center quản lý tốt

- ✅ Giá cạnh tranh trong phân khúc 8 GPU

Nhược điểm:

- ❌ Kích thước lớn (4U) tốn rack space

- ❌ Tiếng ồn cao khi full load

- ❌ Support tại VN chưa mạnh bằng Dell/HPE

Giá tham khảo: $350,000 – $500,000

Phù hợp cho:

- AI research labs

- Huấn luyện LLM quy mô lớn

- HPC workloads cần multi-GPU scaling

ASUS ESC8000A-E12P (AMD Platform)

Thông số kỹ thuật:

- Form Factor: 4U Rack Server

- CPU: Dual AMD EPYC 9004 Series (up to 400W)

- Memory: 24 khe DDR5 (tối đa 6TB @ 4800 MT/s)

- GPU: 8x H100 SXM5

- PCIe: Gen 5.0 slots

- Storage: 8x 2.5″ NVMe

Ưu điểm:

- ✅ AMD EPYC có nhiều PCIe lanes hơn Intel

- ✅ Giá CPU thấp hơn Intel 20-30%

- ✅ Hiệu suất memory bandwidth tốt

- ✅ Tốt cho workload cần nhiều I/O

Nhược điểm:

- ❌ Ecosystem AMD nhỏ hơn Intel

- ❌ Một số software tối ưu hơn cho Intel

- ❌ Ít khe RAM hơn (24 vs 32)

Giá tham khảo: $340,000 – $480,000

Phù hợp cho:

- Data analytics workloads

- Khách hàng ưu tiên cost-per-performance

- Workload cần nhiều PCIe bandwidth

Supermicro SYS-421GE-TNRT3

Thông số kỹ thuật:

- Form Factor: 4U Rack Server

- CPU: Dual Intel Xeon Scalable Gen 4/5 (350W)

- Memory: 32 khe DDR5 (8TB max @ 5600 MT/s)

- GPU: 8x H100 SXM5 với NVSwitch

- Storage: 24x 2.5″ NVMe hot-swap

- Cooling: Liquid cooling capable

- Management: Supermicro Server Manager, Redfish API

Ưu điểm:

- ✅ NVSwitch fabric cho kết nối GPU tối ưu

- ✅ Liquid cooling giảm nhiệt và tiếng ồn

- ✅ Storage capacity cao nhất (24 bays)

- ✅ Tùy biến cao, phù hợp custom workload

Nhược điểm:

- ❌ Giá cao nhất trong danh sách

- ❌ Phức tạp, cần expertise để setup

- ❌ Lead time giao hàng dài

Giá tham khảo: $380,000 – $550,000

Phù hợp cho:

- Exascale HPC clusters

- National labs, top universities

- AI companies huấn luyện foundation models

Lenovo ThinkSystem SR675 V3

Thông số kỹ thuật:

- Form Factor: 4U Rack Server

- CPU: Dual AMD EPYC 9004 Series

- Memory: 24 khe DDR5 (6TB max)

- GPU: 8x H100 SXM5, A100, A30, hoặc mix

- Storage: Multiple EDSFF NVMe options

- Networking: 25GbE onboard, optional 100GbE

Ưu điểm:

- ✅ Lenovo XClarity quản lý tốt

- ✅ Warranty và support comprehensive

- ✅ Tích hợp tốt với Lenovo ecosystem

- ✅ Energy efficiency cao

Nhược điểm:

- ❌ Ít phổ biến trong AI community

- ❌ Tùy chọn cấu hình hạn chế hơn Supermicro

Giá tham khảo: $360,000 – $510,000

Phù hợp cho:

- Enterprise với Lenovo infrastructure sẵn có

- Cần support và warranty tốt

- Ưu tiên quản lý dễ dàng

Dell PowerEdge XE9680

Thông số kỹ thuật:

- Form Factor: 6U Rack Server (cao nhất)

- CPU: Dual Intel Xeon Scalable Gen 4

- Memory: 32 khe DDR5 (8TB max)

- GPU: 8x H100 SXM5 với NVLink

- Storage: Multiple NVMe và SAS/SATA options

- Networking: NDR InfiniBand ready

- Power: 7000W+ redundant

Ưu điểm:

- ✅ Build quality và reliability cao nhất

- ✅ Dell ProSupport AI: 24/7 predictive support

- ✅ Integrated lifecycle management

- ✅ Tối ưu cho GPU cooling và performance

Nhược điểm:

- ❌ Giá cao nhất trong phân khúc (premium 20-30%)

- ❌ Kích thước 6U tốn nhiều rack space

- ❌ Overkill cho hầu hết SMB

Giá tham khảo: $400,000 – $600,000+

Phù hợp cho:

- Fortune 500 companies

- Mission-critical AI infrastructure

- Khách hàng cần uptime 99.999% và support tốt nhất

Bảng So Sánh Tổng Quan

| Model | GPU | CPU | RAM Max | Form | Giá (USD) | Điểm mạnh |

|---|---|---|---|---|---|---|

| Dell R760xa | 4 | Intel | 8TB | 2U | 150K-250K | Support tốt |

| HPE DL380a | 4 | Intel | 8TB | 2U | 145K-240K | Cloud hybrid |

| H3C R4900 G6 | 4 | Intel | 6TB | 2U | 120K-190K | Cost-effective |

| Supermicro 221GE | 4 | Intel | 8TB | 2U | 135K-215K | Customizable |

| ASUS ESC8000-E11P | 8 | Intel | 8TB | 4U | 350K-500K | Thermal design |

| ASUS ESC8000A-E12P | 8 | AMD | 6TB | 4U | 340K-480K | AMD value |

| Supermicro 421GE | 8 | Intel | 8TB | 4U | 380K-550K | NVSwitch |

| Lenovo SR675 V3 | 8 | AMD | 6TB | 4U | 360K-510K | Management |

| Dell XE9680 | 8 | Intel | 8TB | 6U | 400K-600K+ | Enterprise |

Khám phá: Các loại server hiện nay

Máy chủ GPU NVIDIA H100 Tensor Core đã chứng minh là bước nhảy vọt trong công nghệ xử lý AI và HPC, mang lại hiệu suất gấp 4-30 lần so với thế hệ trước. Từ việc huấn luyện các mô hình ngôn ngữ lớn với hàng trăm tỷ tham số, đến mô phỏng khoa học phức tạp và phân tích dữ liệu quy mô massive, H100 đáp ứng được mọi nhu cầu điện toán hiện đại.

Qua hơn 17 năm kinh nghiệm triển khai giải pháp máy chủ cho khách hàng, đội ngũ chuyên gia của VinaHost nhận thấy rằng việc lựa chọn đúng cấu hình máy chủ – từ 4 GPU cho doanh nghiệp vừa đến 8 GPU cho tổ chức nghiên cứu lớn – là yếu tố quyết định đến ROI và khả năng cạnh tranh trong kỷ nguyên AI. Các dòng server từ Dell, HPE, Supermicro, ASUS, Lenovo và H3C đều mang đến những ưu điểm riêng, phù hợp với từng phân khúc khách hàng và ngân sách cụ thể.

Nếu doanh nghiệp của bạn đang có nhu cầu triển khai hệ thống máy chủ GPU NVIDIA H100 hoặc cần tư vấn về cấu hình phù hợp nhất cho workload của mình, đừng ngần ngại liên hệ với VinaHost. Chúng tôi sẵn sàng đồng hành cùng bạn từ khâu tư vấn, thiết kế hệ thống, đến triển khai và hỗ trợ 24/7.

Bài viết liên quan

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文