Tensor Core là một công nghệ phần cứng chuyên dụng đột phá từ NVIDIA – được xem như một giải pháp cách mạng giúp tăng tốc các phép toán ma trận phức tạp. Đây là nền tảng của mọi mô hình AI hiện đại.

Chuyên gia làm việc tại đã VinaHost nhận định rằng: Tensor Core không chỉ là một tính năng phần cứng thông thường – đây chính là chìa khóa giúp rút ngắn thời gian huấn luyện mô hình AI từ vài tháng xuống còn vài ngày, đồng thời mở ra cánh cửa cho những ứng dụng từng chỉ tồn tại trong tưởng tượng. Từ xe tự lái Tesla đến các mô hình ngôn ngữ lớn như ChatGPT, từ công nghệ DLSS mang lại trải nghiệm gaming đỉnh cao đến những đột phá y khoa cứu sống hàng triệu người – tất cả đều có “bàn tay vô hình” của Tensor Core đằng sau.

Bài viết này sẽ đưa bạn vào hành trình khám phá toàn diện về Tensor Core: từ khái niệm cơ bản, cơ chế hoạt động độc đáo, cho đến các ứng dụng thực tiễn đang thay đổi thế giới. Chúng ta cũng sẽ phân tích sâu sự khác biệt giữa Tensor Core với CPU và CUDA Core, cùng hành trình tiến hóa qua 5 thế hệ từ Volta đến Blackwell mới nhất.

1. Tổng quan về Tensor Core và nền tảng Tensor

Tensor là gì?

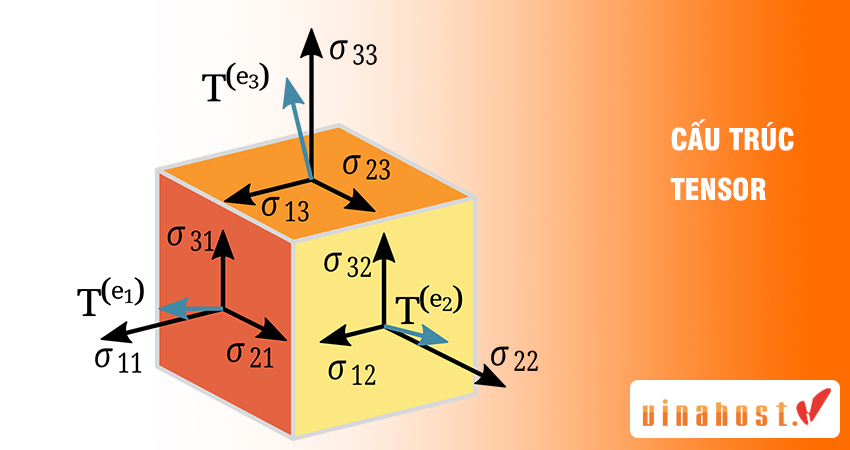

Tensor là một cấu trúc dữ liệu đa chiều, có thể được xem như sự tổng quát hóa của các khái niệm quen thuộc:

- Tensor 0 chiều (Scalar – Vô hướng): Một số đơn lẻ như 5, 3.14

- Tensor 1 chiều (Vector): Một dãy số như [1, 2, 3, 4]

- Tensor 2 chiều (Matrix – Ma trận): Bảng số hai chiều như hình ảnh đen trắng

- Tensor 3+ chiều: Cấu trúc phức tạp hơn như hình ảnh màu (3 chiều: chiều cao × chiều rộng × kênh màu RGB), video (4 chiều: thêm chiều thời gian)

Trong khoa học máy tính và AI, tensor đóng vai trò trung tâm vì khả năng biểu diễn linh hoạt nhiều loại dữ liệu:

- Hình ảnh, video, âm thanh

- Văn bản được mã hóa (text embeddings)

- Tham số của mô hình mạng nơ-ron

- Các hàm phân phối xác suất phức tạp

Tensor không chỉ là công cụ lưu trữ dữ liệu – chúng còn là “ngôn ngữ chung” mà các thuật toán Machine Learning và Deep Learning sử dụng để xử lý, biến đổi và học từ dữ liệu. Hiểu đơn giản, nếu so sánh AI với một đứa trẻ đang học, thì tensor chính là “ngôn ngữ” mà não bộ đứa trẻ sử dụng để ghi nhớ và xử lý thông tin.

Tensor Core là gì?

Tensor Core (Lõi Tensor) là đơn vị xử lý chuyên dụng do NVIDIA thiết kế và tích hợp trực tiếp vào kiến trúc GPU, lần đầu tiên xuất hiện trong kiến trúc Volta vào năm 2017 và tiếp tục phát triển qua các thế hệ Turing, Ampere, Hopper và mới nhất là Blackwell.

Chức năng cốt lõi của Tensor Core là tăng tốc đáng kể các phép toán nhân ma trận và tích lũy (Matrix Multiplication and Accumulation – MMA) – loại phép tính chiếm đến 80-90% khối lượng tính toán trong hầu hết các mô hình AI và Deep Learning hiện nay.

Điểm đặc biệt của Tensor Core nằm ở khả năng thực hiện phép tính Fused Multiply-Add (FMA) trên các ma trận nhỏ (ví dụ 4×4) chỉ trong một chu kỳ xung nhịp. Có nghĩa là:

- Thay vì thực hiện 16 phép nhân riêng lẻ, sau đó cộng dồn kết quả

- Tensor Core xử lý song song toàn bộ ma trận 4×4 (16 phép tính) đồng thời trong một bước duy nhất

Một ví dụ để hiểu hơn về Tensor core như sau:

Hãy tưởng tượng bạn cần nhân hai ma trận 1000×1000 (một triệu phần tử). Với CPU thông thường, công việc này giống như một người thợ xây đang xây tường từng viên gạch một. Với CUDA Core, bạn có một đội công nhân song song làm việc. Nhưng với Tensor Core, bạn có những cỗ máy tự động hóa chuyên dụng – mỗi cỗ có thể đặt cùng lúc nhiều viên gạch theo từng khối 4×4, tốc độ nhanh gấp hàng chục lần.

2. Cơ chế hoạt động và ưu điểm cốt lõi của Tensor Core

2.1 Nguyên lý hoạt động

Tensor Core hoạt động dựa trên một kiến trúc chuyên biệt, được tối ưu hóa để thực hiện phép toán nhân–cộng tích lũy (Fused Multiply-Accumulate) với tốc độ vượt trội. Hãy phân tích chi tiết cơ chế này:

Xử lý song song quy mô lớn:

- Mỗi Tensor Core có thể xử lý một ma trận 4×4 (16 phần tử) trong một chu kỳ clock

- GPU NVIDIA A100 có 432 Tensor Core → có thể xử lý 6,912 phần tử đồng thời

- So sánh: CPU thông thường chỉ xử lý 4-8 phần tử mỗi chu kỳ

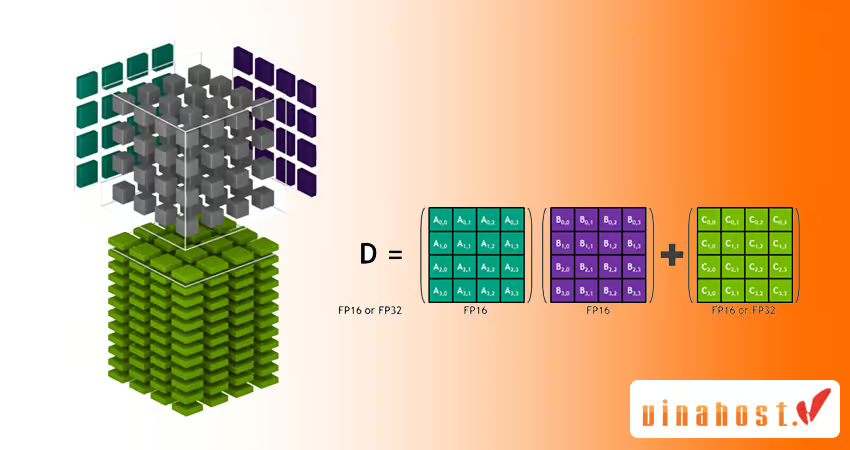

Phép tính Fused Multiply-Add (FMA):

Công thức cơ bản: D = A × B + C

Khi này, Tensor Core không chỉ thực hiện phép tính A × B, mà còn cộng thêm ma trận C và lưu kết quả vào D – tất cả trong một chu kỳ duy nhất. Khả năng này đặc biệt quan trọng trong Deep Learning, cho phép:

- Tensor Core kết nối trực tiếp với bộ nhớ đệm tốc độ cao (L1/L2 cache)

- Băng thông lên tới 3.35 TB/s trên H100 (gấp 10 lần so với CPU)

- Giảm độ trễ truy cập dữ liệu từ ~100ns xuống còn ~10ns

Jensen Huang CEO NVIDIATrích dẫn từ Chuyên gia“Sức mạnh của Tensor Core không nằm ở việc làm nhiều hơn, mà nằm ở việc làm đúng điều cần thiết – và làm nó nhanh hơn bất kỳ công nghệ nào trước đây.”

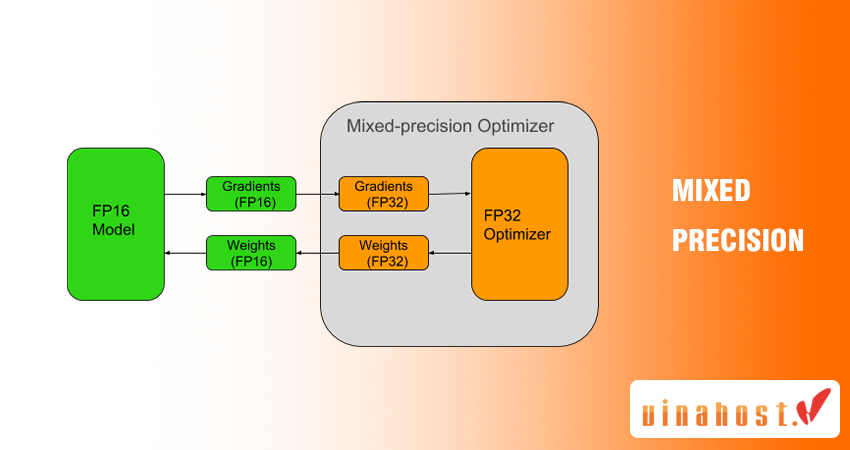

2.2 Vai trò của Mixed Precision (Độ chính xác hỗn hợp)

Một trong những đột phá quan trọng nhất của Tensor Core là khả năng xử lý Mixed Precision – đây là kỹ thuật sử dụng nhiều định dạng số khác nhau trong cùng một quá trình tính toán, tận dụng ưu điểm của từng định dạng để đạt hiệu quả tối đa. Tensor Core hỗ trợ đa dạng các định dạng số:

Các định dạng số được hỗ trợ:

| Định dạng | Số bit | Thế hệ hỗ trợ | Ứng dụng chính |

|---|---|---|---|

| FP32 (Float 32) | 32 bit | Tất cả | Độ chính xác chuẩn, tích lũy kết quả |

| FP16 (Half Precision) | 16 bit | Volta trở đi | Training & Inference, tiết kiệm bộ nhớ |

| BF16 (BFloat16) | 16 bit | Ampere trở đi | Training mô hình lớn, dải động tốt hơn FP16 |

| TF32 (TensorFloat-32) | 19 bit | Ampere trở đi | Training tự động, không cần thay đổi code |

| FP8 (8-bit Float) | 8 bit | Hopper, Blackwell | LLM inference siêu nhanh, giảm 50% băng thông |

| INT8/INT4 | 8/4 bit | Turing trở đi | Inference edge devices, model quantization |

Trong thực tế triển khai tại VinaHost, chúng tôi đã chứng kiến các dự án AI của khách hàng đạt được tăng tốc 2-3 lần chỉ bằng cách bật Mixed Precision Training trên Tensor Core, mà không cần thay đổi kiến trúc mô hình. Đây là một ví dụ điển hình về sức mạnh của công nghệ phần cứng kết hợp với thuật toán thông minh.

2.3 Lợi ích vượt trội của Tensor Core

Sau hơn 17 năm triển khai các dự án AI và HPC, đội ngũ chuyên gia của VinaHost đã tổng hợp những lợi ích quan trọng nhất mà Tensor Core mang lại:

Tăng tốc AI vượt trội: Rút ngắn thời gian huấn luyện và suy luận

Cụ thể, một mô hình ResNet-50 có thể được huấn luyện trên GPU A100 với Tensor Core trong khoảng 40 phút, trong khi cùng tác vụ trên CPU có thể mất hàng ngày thậm chí hàng tuần.

Theo báo cáo của NVIDIA, việc huấn luyện GPT-3 trên GPU H100 với Tensor Core thế hệ thứ 4 nhanh hơn gấp 30 lần so với GPU A100 thế hệ trước. Điều này không chỉ tiết kiệm thời gian mà còn cho phép các nhà nghiên cứu thử nghiệm nhiều ý tưởng hơn trong cùng một khoảng thời gian, tăng tốc độ đổi mới.

Trong giai đoạn suy luận (inference) – khi mô hình AI được triển khai để phục vụ người dùng thực tế – Tensor Core cũng mang lại lợi ích đáng kể.

Ví dụ thực tế từ Alibaba Cloud:

- Chatbot AI phục vụ 50 triệu người dùng

- Trước: Độ trễ trung bình 2.3 giây (dùng CPU)

- Sau: Độ trễ 0.15 giây (dùng GPU T4 với Tensor Core) – nhanh gấp 15 lần

Hiệu quả năng lượng – Tiết kiệm chi phí vận hành

Theo nghiên cứu của NVIDIA, GPU H100 với Tensor Core có thể đạt 3.9 TeraFLOPs/watt cho các phép toán FP8, trong khi CPU hiện đại thường chỉ đạt khoảng 0.1-0.2 TeraFLOPs/watt cho cùng loại tác vụ. Điều này có nghĩa là Tensor Core hiệu quả năng lượng hơn CPU gấp 20-30 lần cho các tác vụ AI.

Khả năng xử lý các mô hình AI lớn và phức tạp

Công nghệ Sparsity trên Tensor Core thế hệ thứ 3 và 4 còn đưa hiệu quả lên tầm cao mới. Nhiều mô hình AI sau khi được pruning có thể có tới 50% trọng số bằng 0.

Tensor Core có khả năng phát hiện và bỏ qua các phép tính với số 0, nhân đôi hiệu suất thực tế mà không làm giảm độ chính xác. Điều này đặc biệt hữu ích cho các mô hình suy luận edge computing, nơi tài nguyên bị giới hạn.

Kinh nghiệm từ VinaHost: “Trong quá trình triển khai hơn 200 dự án AI cho khách hàng, chúng tôi đã chứng kiến Tensor Core không chỉ tăng tốc độ tính toán. Điều quan trọng hơn là nó mở ra khả năng triển khai những mô hình AI mà trước đây bị coi là ‘không khả thi’ do giới hạn phần cứng và chi phí.”

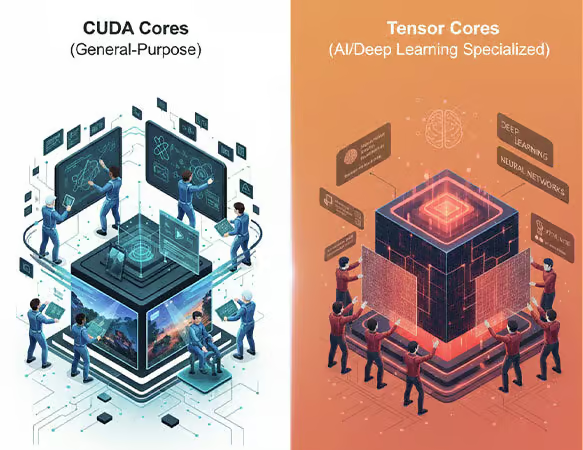

3. So sánh Tensor Core với các đơn vị xử lý khác

Để hiểu rõ vai trò đặc biệt của Tensor Core trong hệ sinh thái tính toán hiện đại, chúng ta cần so sánh công nghệ này với hai loại đơn vị xử lý phổ biến khác: CPU và CUDA Core. Mỗi loại đều có điểm mạnh riêng và phục vụ những mục đích khác nhau trong kiến trúc máy tính.

Khác biệt so với CPU

Khi đối mặt với các phép toán ma trận quy mô lớn – nền tảng của AI và Deep Learning – CPU bộc lộ hạn chế nghiêm trọng. Với số lượng lõi hạn chế và kiến trúc không được tối ưu cho tính toán song song, CPU không thể xử lý hàng nghìn phép nhân ma trận đồng thời một cách hiệu quả. Một phép nhân ma trận lớn trên CPU có thể mất hàng giờ, trong khi Tensor Core có thể hoàn thành cùng tác vụ đó chỉ trong vài phút.

Tensor Core, ngược lại, là một siêu chuyên gia được thiết kế với mục đích duy nhất: tăng tốc các phép toán ma trận với độ chính xác hỗn hợp. Thay vì xử lý tuần tự như CPU, mỗi Tensor Core có thể thực hiện đồng thời hàng nghìn phép nhân-cộng ma trận trong một chu kỳ xung nhịp. Chuyên biệt hóa cao độ này giúp Tensor Core đạt hiệu suất vượt trội gấp 10-30 lần so với CPU cho các tác vụ AI/DL.

Tuy nhiên, điều quan trọng cần nhấn mạnh là Tensor Core không thay thế CPU, mà bổ sung cho nó. CPU vẫn đóng vai trò điều phối tổng thể, quản lý luồng dữ liệu và xử lý các tác vụ logic phức tạp, trong khi Tensor Core tập trung vào việc tăng tốc các phép toán ma trận cốt lõi.

Khác biệt so với CUDA Core

CUDA Core được thiết kế để xử lý đa dạng các phép toán số học song song, nhưng khi thực hiện phép nhân ma trận, chúng phải thực hiện từng phép nhân và phép cộng một cách riêng lẻ.

Tensor Core, ngược lại, được thiết kế chuyên biệt để tối ưu hóa phép toán nhân-cộng ma trận (Matrix Multiply-Accumulate – MMA). Điều này mang lại thông lượng (throughput) cao hơn nhiều lần so với CUDA Core khi xử lý các tác vụ ma trận.

Hơn nữa, Tensor Core hỗ trợ độ chính xác hỗn hợp (mixed precision), cho phép sử dụng các định dạng số như FP16, BF16, TF32, INT8, hoặc FP8 để tăng tốc tính toán.

Kết luận quan trọng: CUDA Core và Tensor Core không loại trừ lẫn nhau mà bổ sung cho nhau trong một GPU hiện đại. CUDA Core xử lý các tác vụ đồ họa, tính toán song song đa dạng và các phép toán không liên quan đến ma trận. Tensor Core siêu tăng tốc các phép toán ma trận – trái tim của các thuật toán AI. Một GPU NVIDIA hiện đại (như A100 hoặc H100) tích hợp cả hai loại lõi để tối ưu hóa hiệu suất tổng thể.

So sánh tóm tắt:

| Tiêu chí | CPU | CUDA Core | Tensor Core |

|---|---|---|---|

| Mục đích chính | Đa năng, điều phối tổng thể | Song song đa năng | Chuyên biệt cho ma trận AI |

| Số lượng lõi | Vài chục (4-64) | Hàng nghìn (2,000-16,000+) | Vài trăm (100-600+) |

| Tối ưu cho | Logic phức tạp, điều khiển | Đồ họa, tính toán song song | Phép toán ma trận (MMA) |

| Độ chính xác | FP32, FP64, INT | FP32, FP64 | FP16, BF16, TF32, INT8, FP8 |

| Hiệu suất AI/DL | Thấp | Trung bình | Rất cao (gấp 10-30 lần) |

| Linh hoạt | Rất cao | Cao | Trung bình (chuyên biệt) |

| Tiêu thụ năng lượng | Thấp (cho tác vụ đơn lẻ) | Cao | Hiệu quả (FLOPs/watt cao) |

4. Lịch sử và các thế hệ Tensor Core qua kiến trúc NVIDIA

Qua mỗi thế hệ kiến trúc GPU, Tensor Core đã được cải tiến đáng kể về hiệu năng, tính năng và khả năng xử lý.

Thế hệ 1 – Volta (V100)

Năm 2017 đánh dấu một cột mốc lịch sử trong ngành công nghiệp AI khi NVIDIA giới thiệu kiến trúc GPU Volta, lần đầu tiên tích hợp công nghệ Tensor Core. GPU Tesla V100, sản phẩm đầu bảng của dòng Volta, đã mở ra kỷ nguyên mới cho tính toán AI.

Volta Tensor Core thế hệ đầu tiên được thiết kế với mục tiêu chính là hỗ trợ đào tạo chính xác hỗn hợp (mixed-precision training) bằng cách sử dụng định dạng số FP16 (16-bit floating point) cho đầu vào và tích lũy kết quả ở FP32 (32-bit floating point). Công nghệ này cho phép tăng tốc quá trình huấn luyện mô hình AI lên tới 12 lần so với thế hệ GPU Pascal trước đó, đồng thời vẫn duy trì độ chính xác cần thiết.

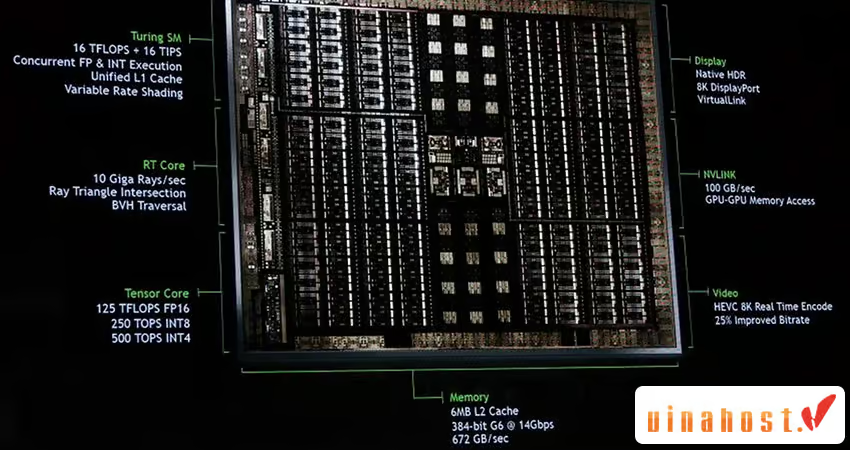

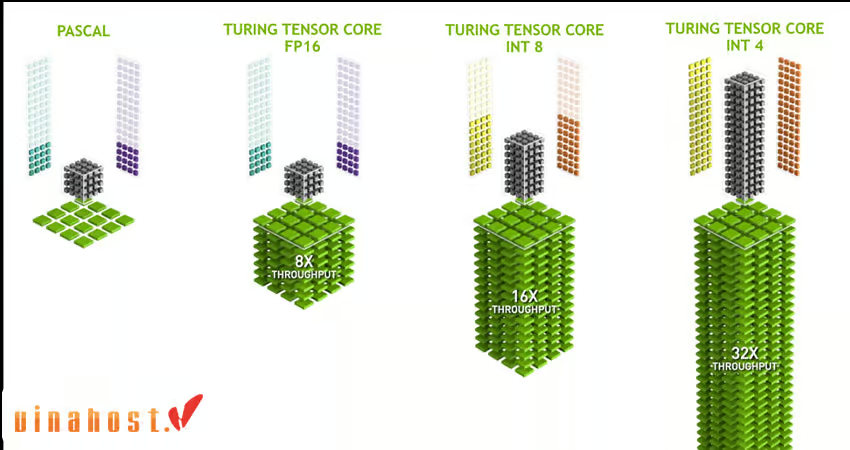

Thế hệ 2 – Turing (RTX 20 Series)

Chỉ một năm sau Volta, NVIDIA tiếp tục đột phá với kiến trúc Turing, được giới thiệu vào năm 2018. Thế hệ Tensor Core thứ hai mang đến nhiều cải tiến quan trọng và lần đầu tiên xuất hiện trên các card đồ họa dành cho người dùng thông thường (GeForce RTX 20 series), không chỉ giới hạn ở các GPU cho trung tâm dữ liệu như Volta.

Điểm đột phá lớn nhất của Turing Tensor Core là mở rộng hỗ trợ cho các định dạng số chính xác thấp hơn như INT8, INT4 và thậm chí INT1 (số nguyên 8-bit, 4-bit và 1-bit). Turing Tensor Core cho phép tăng tốc hiệu suất GPU lên tới 32 lần so với GPU Pascal (thế hệ trước Volta) cho các tác vụ AI.

Một đóng góp quan trọng khác của Turing là tích hợp Tensor Core với các lõi Ray Tracing (RT Core) mới, mở ra kỷ nguyên của DLSS (Deep Learning Super Sampling) trong gaming. Công nghệ này đã cách mạng hóa ngành công nghiệp game, cho phép các hiệu ứng Ray Tracing chân thực trở nên khả thi trên các card đồ họa mainstream.

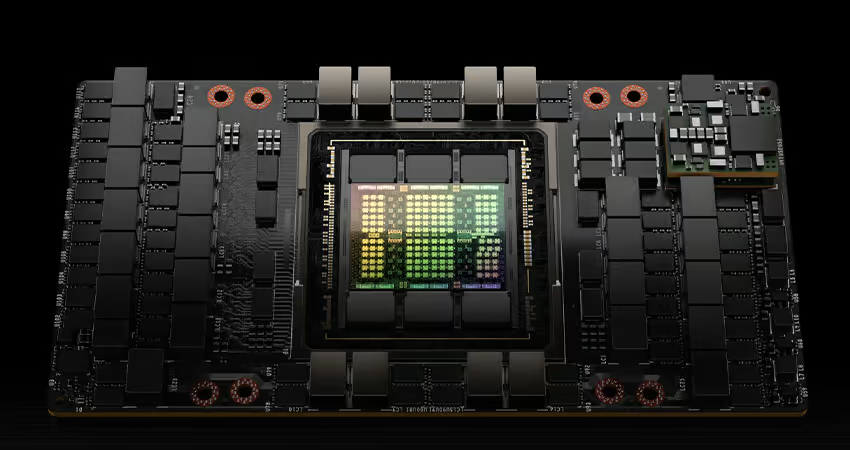

Thế hệ 3 – Ampere (A100, RTX 30 Series)

Năm 2020, NVIDIA giới thiệu kiến trúc Ampere, đánh dấu bước tiến lớn tiếp theo trong sự phát triển của Tensor Core. Ampere Tensor Core giới thiệu một định dạng số mới mang tính cách mạng: TF32 (TensorFloat-32). TF32 là một định dạng độc đáo kết hợp ưu điểm của cả FP16 và FP32: nó có phạm vi động (dynamic range) của FP32 nhưng tốc độ tính toán gần bằng FP16.

Ampere cũng tăng cường hỗ trợ cho BF16 (BFloat16), một định dạng số được Google phát triển và ngày càng phổ biến trong cộng đồng AI. BF16 đặc biệt hiệu quả cho các mô hình ngôn ngữ lớn (Large Language Models – LLM) và các mạng nơ-ron sâu.

Một tính năng đột phá khác của Ampere Tensor Core là hỗ trợ Sparsity (tính thưa). Công nghệ Fine-Grained Structured Sparsity này đặc biệt hiệu quả cho các mô hình đã được tối ưu hóa.

GPU A100, sản phẩm đầu bảng của Ampere dành cho trung tâm dữ liệu, được trang bị 432 Tensor Core thế hệ thứ ba (trong phiên bản 80GB), cung cấp hiệu suất lên tới 312 TeraFLOPs cho các tác vụ TF32 và 624 TeraFLOPs khi sử dụng sparsity. A100 đã trở thành xương sống cho hầu hết các trung tâm AI và các dịch vụ cloud AI hàng đầu thế giới.

Thế hệ 4 – Hopper (H100, RTX 40 Series)

Vào tháng 9 năm 2022, NVIDIA công bố kiến trúc Hopper – một bước nhảy vọt mới trong công nghệ Tensor Core, được đặt tên theo Grace Hopper, nhà khoa học máy tính tiên phong. Hopper được thiết kế đặc biệt để xử lý các mô hình AI siêu lớn, đặc biệt là các mô hình ngôn ngữ lớn (LLM) có hàng trăm tỷ đến nghìn tỷ tham số.

Đột phá lớn nhất của Hopper Tensor Core là hỗ trợ định dạng FP8 (8-bit floating point). FP8 cung cấp gấp đôi thông lượng so với FP16, giúp tăng tốc đáng kể cả quá trình huấn luyện lẫn suy luận các mô hình LLM. Theo NVIDIA, Hopper Tensor Core có thể tăng tốc các mô hình như GPT-3 lên tới 30 lần so với thế hệ Ampere trước đó.

Hopper cũng giới thiệu Transformer Engine, một công nghệ AI độc đáo có khả năng tự động phân tích và quyết định sử dụng FP8 hay FP16 cho từng lớp của mô hình Transformer, tối ưu hóa cân bằng giữa tốc độ và độ chính xác mà không cần can thiệp thủ công từ lập trình viên. Transformer Engine đặc biệt hiệu quả cho các mô hình như BERT, GPT, T5 và các biến thể của chúng.

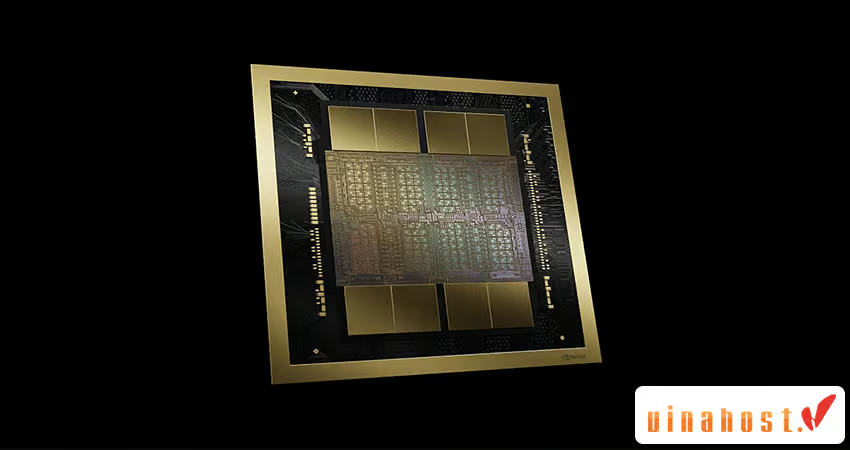

Thế hệ 5 – Blackwell

Mới đây, NVIDIA đã công bố kiến trúc Blackwell – thế hệ Tensor Core mới nhất, được đặt tên theo David Blackwell, nhà toán học và thống kê học nổi tiếng. Blackwell đại diện cho bước tiến mới nhất trong công nghệ AI, được thiết kế đặc biệt cho kỷ nguyên AI tạo sinh (Generative AI) và các mô hình nền tảng (Foundation Models) quy mô chưa từng có.

Blackwell Tensor Core mang đến hiệu suất vượt trội gấp 30 lần so với Hopper cho các mô hình siêu lớn như GPT-MoE-1.8T (mô hình hỗn hợp chuyên gia với 1.8 nghìn tỷ tham số). Để đạt được điều này, Blackwell giới thiệu nhiều cải tiến quan trọng:

- Hỗ trợ định dạng FP4 (4-bit floating point), mang lại thông lượng gấp đôi so với FP8, đặc biệt hiệu quả cho các tác vụ suy luận quy mô lớn.

- Kiến trúc Dual-Die: Blackwell là GPU đầu tiên của NVIDIA sử dụng hai chip được kết nối với băng thông cực cao (10 TB/s), hoạt động như một GPU thống nhất với 208 tỷ bóng bán dẫn.

- Cải tiến Transformer Engine thế hệ thứ hai với khả năng tối ưu hóa tốt hơn cho các mô hình Multimodal (đa phương thức) kết hợp văn bản, hình ảnh, video và âm thanh.

GPU Blackwell đầu tiên, B100 và B200, dự kiến ra mắt vào năm 2025, hứa hẹn sẽ mở ra kỷ nguyên mới cho AI với khả năng xử lý các mô hình có hàng nghìn tỷ tham số một cách hiệu quả và tiết kiệm năng lượng hơn.

Bảng tổng hợp các thế hệ Tensor Core:

| Thế hệ | Kiến trúc | Năm | GPU tiêu biểu | Định dạng hỗ trợ chính | Cải tiến nổi bật | Hiệu suất (TFLOPS) |

|---|---|---|---|---|---|---|

| Gen 1 | Volta | 2017 | Tesla V100 | FP16, FP32 | Ra mắt Tensor Core | 125 (FP16) |

| Gen 2 | Turing | 2018 | RTX 20 series, T4 | FP16, INT8, INT4 | Hỗ trợ INT, DLSS 1.0, RT Core | 130 (FP16) |

| Gen 3 | Ampere | 2020 | A100, RTX 30 series | TF32, FP16, BF16, INT8 | TF32, Sparsity, DLSS 2.0 | 312 (TF32), 624 (sparse) |

| Gen 4 | Hopper | 2022 | H100, RTX 40 series | FP8, FP16, BF16, TF32 | FP8, Transformer Engine, DLSS 3 | 989 (FP8) |

| Gen 5 | Blackwell | 2024-25 | B100, B200 | FP4, FP8, FP16, BF16 | FP4, Dual-Die, Hiệu suất 30× | ~2000+ (FP4, ước tính) |

Qua 5 thế hệ phát triển từ 2017 đến nay, Tensor Core đã không ngừng tiến hóa, mỗi thế hệ mang đến những cải tiến đột phá về hiệu năng, tính năng và hiệu quả năng lượng. Từ công cụ chuyên dụng cho các trung tâm dữ liệu, Tensor Core đã trở thành công nghệ phổ biến xuất hiện trên cả GPU dành cho game thủ, máy trạm chuyên nghiệp và các thiết bị edge computing, thực sự dân chủ hóa sức mạnh AI cho mọi người.

5. Ứng dụng thực tế của NVIDIA Tensor Core

Sau khi hiểu rõ về cơ chế hoạt động và lợi ích của Tensor Core, câu hỏi quan trọng nhất mà nhiều doanh nghiệp và nhà phát triển đặt ra là: “Tensor Core có thể giải quyết những vấn đề gì trong thực tế?” Trong phần này, chúng tôi sẽ khám phá các ứng dụng cụ thể mà Tensor Core đang tạo ra giá trị thực sự trong nhiều lĩnh vực khác nhau.

5.1 Trí tuệ nhân tạo và Học sâu

Đây là lĩnh vực mà Tensor Core được sinh ra để phục vụ, và cũng là nơi công nghệ này thể hiện sức mạnh ấn tượng nhất. Tensor Core đã trở thành xương sống của hầu hết các hệ thống AI hiện đại, từ nghiên cứu học thuật đến ứng dụng thương mại quy mô lớn.

Computer Vision

Thị giác máy tính là một trong những ứng dụng AI phổ biến nhất và Tensor Core đã cách mạng hóa cách chúng ta xây dựng và triển khai các hệ thống này.

- Nhận dạng hình ảnh và phân loại đối tượng: Tensor Core giúp huấn luyện các mô hình như ResNet, EfficientNet, và Vision Transformer (ViT) nhanh hơn 10-20 lần.

- Phát hiện và phân đoạn đối tượng: Các mô hình như YOLO (You Only Look Once), Mask R-CNN và SAM (Segment Anything Model) yêu cầu khối lượng tính toán khổng lồ. Tensor Core là nền tảng cho các ứng dụng như xe tự lái, giám sát an ninh thông minh và robot công nghiệp trở nên khả thi trong thời gian thực.

Xử lý ngôn ngữ tự nhiên (NLP)

- Mô hình ngôn ngữ lớn (LLM): ChatGPT, GPT-4, Claude, Gemini – tất cả các chatbot AI tiên tiến này đều được huấn luyện và vận hành trên các GPU server với Tensor Core. Transformer Engine trên Hopper Tensor Core được thiết kế đặc biệt để tối ưu hóa cơ chế self-attention – trái tim của các mô hình Transformer – giúp tăng tốc huấn luyện GPT-3 lên 30 lần so với thế hệ trước.

- Dịch máy và hiểu ngữ cảnh: Các dịch vụ như Google Translate, DeepL sử dụng các mô hình Transformer được tăng tốc bởi Tensor Core để dịch văn bản giữa hàng trăm cặp ngôn ngữ với độ chính xác gần như con người.

- Phân tích cảm xúc và tóm tắt văn bản: Các công ty fintech sử dụng Tensor Core để phân tích hàng triệu bài đánh giá khách hàng, bài viết tin tức để đánh giá tâm lý thị trường và đưa ra quyết định đầu tư.

Nhận dạng và tổng hợp giọng nói

- Speech-to-Text (STT): Các trợ lý ảo như Siri, Alexa, Google Assistant sử dụng mô hình Wav2Vec 2.0 hoặc Whisper chạy trên Tensor Core để chuyển đổi giọng nói thành văn bản với độ chính xác cao. Whisper của OpenAI, được huấn luyện trên GPU với Tensor Core, có thể nhận dạng 99 ngôn ngữ và xử lý cả những giọng nói có tiếng ồn nền phức tạp.

- Text-to-Speech (TTS): Các mô hình TTS hiện đại như Tacotron 2, FastSpeech 2 sử dụng Tensor Core để tạo ra giọng nói tự nhiên, có cảm xúc từ văn bản. Ứng dụng thực tế bao gồm sách nói tự động, trợ lý ảo cho người khiếm thị, và các hệ thống thông báo công cộng thông minh.

Một dự án ấn tượng mà VinaHost đã tham gia là xây dựng hệ thống voice cloning cho một công ty giải trí, cho phép tạo ra giọng đọc của người nổi tiếng chỉ từ 10 phút mẫu giọng. Hệ thống chạy trên H100 với Tensor Core, có thể tạo ra 1 giờ nội dung audio chất lượng cao chỉ trong 5 phút xử lý.

5.2 Đồ họa máy tính và Gaming

Mặc dù Tensor Core được thiết kế cho AI, công nghệ này đã tạo ra một cuộc cách mạng trong ngành công nghiệp game thông qua DLSS và các công nghệ liên quan.

DLSS (Deep Learning Super Sampling)

DLSS là một trong những ứng dụng Tensor Core ấn tượng nhất trong gaming, cho phép game thủ trải nghiệm đồ họa chất lượng cao mà không cần phần cứng đắt đỏ.

- Cách DLSS hoạt động: Thay vì render game ở độ phân giải 4K gốc (rất tốn tài nguyên), DLSS render ở độ phân giải thấp hơn (ví dụ 1080p) sau đó sử dụng mạng nơ-ron trên Tensor Core để nâng cấp lên 4K bằng AI.

- DLSS 3 Frame Generation: Công nghệ mới nhất trên RTX 40 series sử dụng Tensor Core thế hệ thứ 4 để tạo ra các khung hình trung gian hoàn toàn mới giữa hai khung được render thật.

Ray Tracing và AI-Enhanced Graphics

Ray Reconstruction: Công nghệ mới trong DLSS 3.5 sử dụng Tensor Core để cải thiện chất lượng của các tia ray tracing, giảm nhiễu (noise) và tạo ra ánh sáng, bóng đổ, phản chiếu chân thực hơn mà không cần tăng số lượng ray được xử lý.

5.3 Xe tự động

Xử lý dữ liệu cảm biến thời gian thực

Một chiếc xe tự lái hiện đại trang bị hàng chục cảm biến: camera, LiDAR, radar, ultrasonic, tạo ra hàng gigabyte dữ liệu mỗi giây. Hệ thống AI phải xử lý tất cả dữ liệu này trong thời gian thực để đưa ra quyết định lái xe an toàn.

Nhận diện và dự đoán hành vi

- Phát hiện đối tượng 360°: Tensor Core giúp các mô hình YOLO, PointPillars phát hiện xe cộ, người đi bộ, xe đạp, động vật trong tầm nhìn 360° xung quanh xe với độ trễ dưới 30ms – đủ nhanh để phản ứng kịp thời với các tình huống nguy hiểm.

- Dự đoán quỹ đạo: Không chỉ phát hiện đối tượng, AI còn phải dự đoán chúng sẽ di chuyển như thế nào trong vài giây tới. Các mô hình như TrafficPredict sử dụng Tensor Core để mô phỏng hàng trăm kịch bản khác nhau đồng thời, giúp xe chọn lộ trình an toàn nhất.

Các công ty như Tesla, Waymo, Cruise đều sử dụng GPU NVIDIA với Tensor Core cho cả quá trình huấn luyện mô hình (trên các trung tâm dữ liệu) lẫn suy luận trên xe (edge computing). Theo báo cáo của Tesla, họ đã huấn luyện mô hình FSD (Full Self-Driving) Beta trên siêu máy tính Dojo với hàng nghìn GPU A100, giúp giảm 75% thời gian huấn luyện so với thế hệ trước.

5.4 Điện toán hiệu năng cao (HPC) và Nghiên cứu khoa học

Mặc dù Tensor Core được thiết kế chủ yếu cho AI, công nghệ này cũng mang lại lợi ích lớn cho nhiều lĩnh vực tính toán khoa học.

Mô phỏng khoa học phức tạp

- Khoa học vật liệu và hóa học: Các nhà nghiên cứu sử dụng Tensor Core để mô phỏng cấu trúc phân tử, dự đoán tính chất vật liệu mới, thiết kế thuốc. Mô hình AlphaFold 2 – công cụ AI dự đoán cấu trúc protein – đã sử dụng Tensor Core để giải quyết một bài toán 50 năm trong sinh học, mở ra kỷ nguyên mới cho phát triển thuốc.

- Dự báo thời tiết và khí hậu: Các mô hình dự báo thời tiết hiện đại như FourCastNet, GraphCast sử dụng Deep Learning trên Tensor Core để dự báo thời tiết 10 ngày trước với độ chính xác cao hơn và nhanh hơn 10,000 lần so với các phương pháp truyền thống.

- Vật lý năng lượng cao và thiên văn học: Các thí nghiệm như LHC (Large Hadron Collider) tạo ra lượng dữ liệu khổng lồ cần phân tích. Tensor Core giúp các nhà vật lý tìm kiếm các hạt mới nhanh hơn trong hàng petabyte dữ liệu va chạm.

Phân tích dữ liệu lớn (Big Data Analytics)

Trong lĩnh vực tài chính, y tế, marketing, khả năng phân tích nhanh hàng terabyte dữ liệu là lợi thế cạnh tranh then chốt. Tensor Core tăng tốc các thuật toán machine learning truyền thống như:

- Phát hiện gian lận: Các ngân hàng sử dụng mô hình GNN (Graph Neural Network) trên Tensor Core để phân tích hàng tỷ giao dịch mỗi ngày, phát hiện các mẫu gian lận phức tạp với độ chính xác 99%+.

- Hệ thống khuyến nghị: Netflix, Amazon, Spotify sử dụng Tensor Core để huấn luyện các mô hình collaborative filtering và deep learning, cải thiện 30-40% độ chính xác của khuyến nghị so với phương pháp truyền thống.

- Phân tích gen: Các trung tâm y học sử dụng Tensor Core để phân tích dữ liệu gene sequencing, rút ngắn thời gian từ vài tuần xuống vài giờ, giúp chẩn đoán bệnh di truyền nhanh hơn.

Tại VinaHost, chúng tôi tự hào đã cung cấp giải pháp VPS GPU cho các dự án AI/HPC, từ startup nghiên cứu thuốc đến các tập đoàn tài chính lớn. Khách hàng của chúng tôi đã đạt được những kết quả ấn tượng: giảm 70% chi phí hạ tầng, tăng 15-30 lần tốc độ xử lý, và rút ngắn 60% thời gian đưa sản phẩm AI ra thị trường. Đây là minh chứng rõ ràng cho giá trị thực tế mà Tensor Core mang lại trong môi trường sản xuất.

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文