Trong kỷ nguyên chuyển đổi số và bùng nổ trí tuệ nhân tạo, máy chủ GPU NVIDIA T4 Tensor Core đang trở thành lựa chọn chiến lược của các doanh nghiệp AI, startup công nghệ và trung tâm nghiên cứu học máy tại Việt Nam. Sau nhiều năm triển khai hạ tầng GPU cho khách hàng, VinaHost nhận thấy GPU T4 mang lại sự cân bằng hoàn hảo giữa hiệu năng AI inference mạnh mẽ, chi phí hợp lý và khả năng mở rộng linh hoạt.

- GPU NVIDIA T4: là lựa chọn chiến lược cho suy luận AI (AI inference), mang lại sự cân bằng tối ưu giữa hiệu suất mạnh mẽ và chi phí vận hành thấp, chỉ tiêu thụ 70W TDP giúp giảm đáng kể lượng điện tiêu thụ để vận hành và làm mát máy chủ.

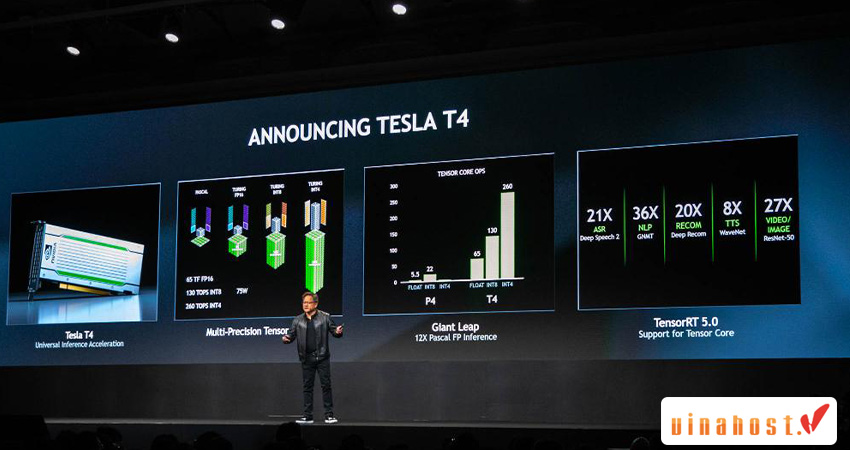

- Lõi Tensor: Được xây dựng trên kiến trúc Turing, T4 tích hợp 320 Tensor Cores thế hệ 2 chuyên dụng, hỗ trợ tính toán đa độ chính xác (FP32, FP16, INT8, INT4) để tăng tốc độ xử lý các mô hình học sâu lên gấp nhiều lần so với GPU thông thường.

- Hiệu suất vượt trội cho ứng dụng thời gian thực: T4 đạt hiệu năng suy luận AI nhanh hơn tới 40 lần so với CPU Intel Xeon Gold 6140, làm giảm độ trễ phản hồi xuống dưới 50ms, lý tưởng cho các ứng dụng tương tác như chatbot, hệ thống gợi ý và phân tích video thông minh quy mô lớn.

- Mô hình thuê máy chủ T4: Loại bỏ nhu cầu đầu tư phần cứng ban đầu tốn kém, cho phép doanh nghiệp và startup mở rộng hoặc thu hẹp tài nguyên linh hoạt theo nhu cầu dự án (thuê theo giờ/tháng), kèm theo hỗ trợ kỹ thuật chuyên sâu 24/7.

1. Thông tin về Tesla T4

GPU NVIDIA Tesla T4 Là Gì?

GPU NVIDIA Tesla T4 là card đồ họa máy chủ thế hệ mới dựa trên kiến trúc Turing tiên tiến, được NVIDIA thiết kế đặc biệt để tăng tốc các workload AI inference, machine learning và xử lý video thông minh trong môi trường datacenter và đám mây.

Khác với các GPU truyền thống tập trung vào đồ họa, NVIDIA T4 Tensor Core được tối ưu hóa cho suy luận AI (AI inference) – giai đoạn mà các mô hình học sâu đã được huấn luyện sẵn sàng xử lý dữ liệu thực tế với độ trễ cực thấp. Điều này làm cho T4 trở thành lựa chọn lý tưởng cho các ứng dụng như chatbot thông minh, hệ thống nhận diện hình ảnh, xử lý ngôn ngữ tự nhiên (NLP), và phân tích video theo thời gian thực.

Máy chủ GPU NVIDIA T4 là gì?

Server GPU NVIDIA T4 là một máy chủ vật lý được trang bị card đồ họa NVIDIA Tesla T4. Đây là dòng GPU chuyên dụng cho trung tâm dữ liệu, được thiết kế để tăng tốc các tác vụ suy luận AI (AI inference), xử lý video thông minh và máy học. Khác với card đồ họa cho game thủ, T4 được tối ưu cho hoạt động 24/7, hiệu suất ổn định và đặc biệt là tiêu thụ điện năng cực thấp, chỉ 70W.

Về cơ bản, khi một mô hình AI đã được huấn luyện xong, nó cần được triển khai để xử lý dữ liệu thực tế – quá trình này gọi là “suy luận”. NVIDIA T4 chính là “bậc thầy” trong lĩnh vực này, giúp các ứng dụng như chatbot, nhận dạng hình ảnh, hay hệ thống gợi ý hoạt động nhanh chóng và hiệu quả trên quy mô lớn.

Kiến Trúc Turing

Kiến trúc Turing của NVIDIA đánh dấu bước tiến vượt bậc trong công nghệ GPU datacenter. Được sản xuất trên quy trình 12nm hiện đại, T4 tích hợp 320 Tensor Cores thế hệ thứ hai – các đơn vị xử lý chuyên biệt cho phép tính toán ma trận với độ chính xác hỗn hợp (mixed precision), giúp tăng tốc độ xử lý AI lên gấp nhiều lần so với GPU thế hệ trước.

Trong quá trình triển khai dịch vụ cho các khách hàng AI tại Việt Nam, đội ngũ kỹ thuật VinaHost đã ghi nhận rằng khả năng xử lý đa độ chính xác của T4 (từ FP32, FP16 đến INT8 và INT4) cho phép các doanh nghiệp linh hoạt tối ưu hóa giữa độ chính xác và tốc độ xử lý, tùy thuộc vào yêu cầu cụ thể của từng ứng dụng AI.

Khám phá: Các dòng sản phẩm Nvidia Tesla

2. Thông Số Kỹ Thuật Chi Tiết NVIDIA T4 Tensor Core

Cấu Hình Phần Cứng Server GPU T4

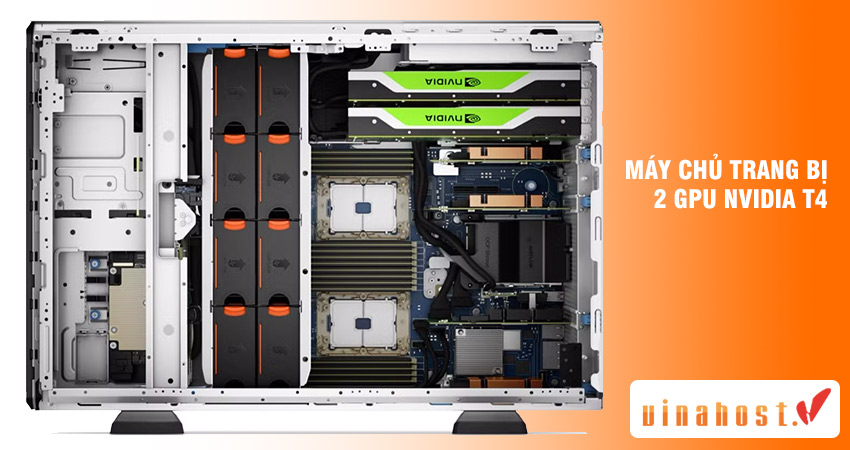

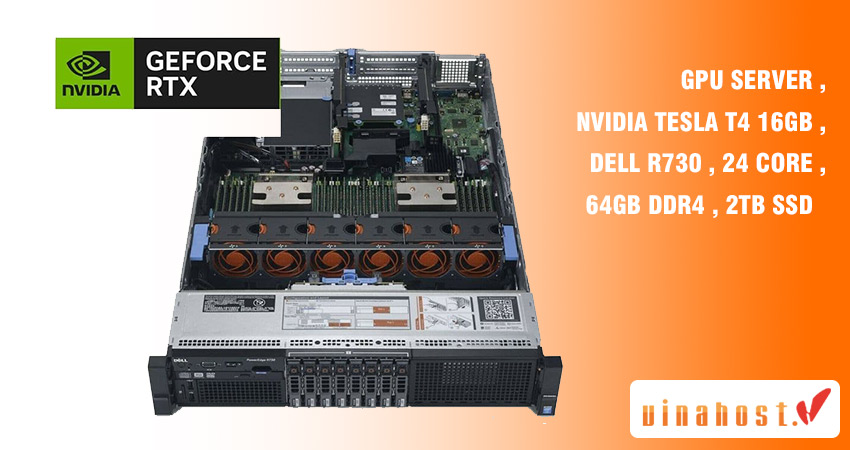

Dịch vụ thuê máy chủ GPU NVIDIA T4 Tensor Core tại VinaHost được xây dựng trên nền tảng server Dell PowerEdge R740/R740xd với cấu hình mạnh mẽ:

Thông số máy chủ vật lý:

- Chassis: Dell PowerEdge R740 / R740xd

- Khe cắm PCIe: PCIe 3.0 x16

- Bộ vi xử lý: Intel Xeon Gold 6100 series (28 cores, 56 threads)

- Bộ nhớ RAM: 128GB DDR4 RDIMM ECC

- Ổ cứng lưu trữ: 900GB NVMe SSD

- Băng thông mạng: 1Gbps quốc tế / 10Gbps nội địa

- Hệ điều hành hỗ trợ: Linux (Ubuntu, CentOS, Rocky Linux), Windows Server

Thông số GPU NVIDIA Tesla T4:

| Thông Số Kỹ Thuật | Chi Tiết |

|---|---|

| Kiến trúc | NVIDIA Turing (12nm) |

| CUDA Cores | 2.560 nhân |

| Tensor Cores | 320 nhân (thế hệ 2) |

| Bộ nhớ VRAM | 16GB GDDR6 |

| Băng thông bộ nhớ | 320 GB/s |

| Hiệu năng FP32 | 8.1 TFLOPS |

| Hiệu năng FP16 | 65 TFLOPS |

| Hiệu năng INT8 | 130 TOPS |

| Hiệu năng INT4 | 260 TOPS |

| Công suất tiêu thụ (TDP) | 70W |

| Kết nối | PCIe Gen3 x16 |

| Kích thước | Half-Height, Half-Length (HHHL) |

Giải thích thông số:

- Kiến trúc NVIDIA Turing: Được sản xuất trên tiến trình 12nm, kiến trúc Turing là một bước nhảy vọt, tích hợp các loại nhân xử lý chuyên biệt cho AI và đồ họa.

- Nhân xử lý đa dạng:

- 2,560 nhân CUDA: Cung cấp sức mạnh xử lý song song cho các tác vụ tính toán hiệu năng cao (HPC).

- 320 nhân Tensor: “Trái tim” của T4, chuyên dụng cho các phép toán ma trận trong deep learning. Nhân Tensor hỗ trợ tính toán đa độ chính xác (FP32, FP16, INT8, INT4), giúp tăng tốc độ suy luận lên gấp nhiều lần so với các GPU chỉ có nhân CUDA.

- Bộ nhớ tốc độ cao: 16 GB bộ nhớ GDDR6 với băng thông 320 GB/s, đảm bảo khả năng xử lý các mô hình AI lớn và luồng dữ liệu phức tạp mà không bị nghẽn cổ chai.

- Tiêu thụ điện năng tối ưu: Với mức tiêu thụ chỉ 70W (TDP), T4 mang lại hiệu suất trên mỗi watt điện năng cực kỳ ấn tượng, giúp giảm đáng kể chi phí vận hành cho các trung tâm dữ liệu.

- Hiệu suất tính toán ấn tượng:

- FP32: 8.1 TFLOPS

- FP16 (Học sâu): 65 TFLOPS

- INT8 (Suy luận): 130 TOPS

- Kiến trúc NVIDIA Turing: Được sản xuất trên tiến trình 12nm, kiến trúc Turing là một bước nhảy vọt, tích hợp các loại nhân xử lý chuyên biệt cho AI và đồ họa.

- Nhân xử lý đa dạng:

- 2,560 nhân CUDA: Cung cấp sức mạnh xử lý song song cho các tác vụ tính toán hiệu năng cao (HPC).

- 320 nhân Tensor: “Trái tim” của T4, chuyên dụng cho các phép toán ma trận trong deep learning. Nhân Tensor hỗ trợ tính toán đa độ chính xác (FP32, FP16, INT8, INT4), giúp tăng tốc độ suy luận lên gấp nhiều lần so với các GPU chỉ có nhân CUDA.

- Bộ nhớ tốc độ cao: 16 GB bộ nhớ GDDR6 với băng thông 320 GB/s, đảm bảo khả năng xử lý các mô hình AI lớn và luồng dữ liệu phức tạp mà không bị nghẽn cổ chai.

- Tiêu thụ điện năng tối ưu: Với mức tiêu thụ chỉ 70W (TDP), T4 mang lại hiệu suất trên mỗi watt điện năng cực kỳ ấn tượng, giúp giảm đáng kể chi phí vận hành cho các trung tâm dữ liệu.

- Hiệu suất tính toán ấn tượng:

- FP32: 8.1 TFLOPS

- FP16 (Học sâu): 65 TFLOPS

- INT8 (Suy luận): 130 TOPS

- Công Suất 70W:

- Giảm chi phí vận hành: Tiết kiệm đáng kể hóa đơn điện cho datacenter, đặc biệt quan trọng khi triển khai hàng chục hoặc hàng trăm GPU trong môi trường quy mô lớn.

- Tối ưu hạ tầng làm mát: Ít nhiệt thải hơn đồng nghĩa với yêu cầu hệ thống làm mát đơn giản hơn, giúp tăng mật độ GPU trên mỗi rack máy chủ.

Trong thực tế triển khai, VinaHost đã giúp nhiều khách hàng giảm tới 40% chi phí điện năng và làm mát khi chuyển đổi từ GPU thế hệ cũ sang NVIDIA T4 Tensor Core.

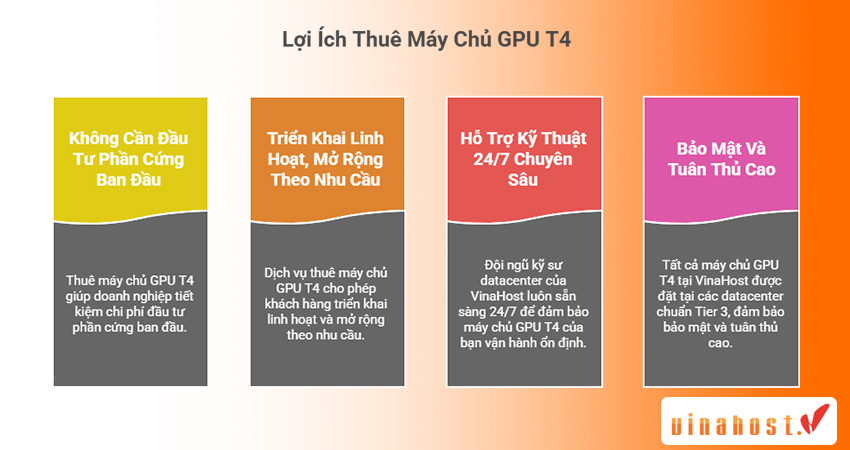

3. Lợi Ích Vượt Trội Khi Thuê Máy Chủ GPU T4

Không Cần Đầu Tư Phần Cứng Ban Đầu

Thay vì chi hàng trăm triệu đồng để thiết lập phần cứng máy chủ vật lý, doanh nghiệp có thể thuê server GPU T4 với chi phí linh hoạt theo nhu cầu. Mô hình thuê này đặc biệt phù hợp với:

- Startup AI giai đoạn đầu: Cần tài nguyên GPU mạnh để phát triển và thử nghiệm mô hình nhưng chưa có nguồn vốn lớn để đầu tư hạ tầng.

- Dự án ngắn hạn: Các dự án nghiên cứu, proof-of-concept hoặc training mô hình trong thời gian giới hạn.

- Doanh nghiệp cần mở rộng nhanh: Khi nhu cầu tính toán tăng đột biến trong các chiến dịch marketing AI hoặc xử lý dữ liệu mùa vụ.

Triển Khai Linh Hoạt, Mở Rộng Theo Nhu Cầu

Dịch vụ thuê máy chủ GPU NVIDIA T4 Tensor Core cho phép khách hàng:

- Thuê theo giờ, theo ngày hoặc theo tháng tùy theo quy mô dự án

- Nâng cấp hoặc hạ cấp cấu hình dễ dàng khi nhu cầu thay đổi

- Kết hợp nhiều GPU T4 trong cùng hệ thống để tăng sức mạnh tính toán

- Tích hợp liền mạch với hệ sinh thái đám mây, API và pipeline dữ liệu hiện có

Hỗ Trợ Kỹ Thuật 24/7 Chuyên Sâu

Đội ngũ kỹ sư datacenter của VinaHost với hơn 17 năm kinh nghiệm triển khai hạ tầng GPU luôn sẵn sàng 24/7 để đảm bảo máy chủ server của bạn vận hành ổn định, xử lý nhanh chóng mọi sự cố kỹ thuật và tư vấn tối ưu hóa hiệu năng cho các workload AI cụ thể.

Không giống như việc mua GPU và tự vận hành, khi thuê server GPU T4 tại VinaHost, khách hàng được hưởng:

- Giám sát hệ thống 24/7 với cảnh báo proactive khi có vấn đề

- Hỗ trợ cài đặt driver CUDA, cuDNN, framework AI (TensorFlow, PyTorch, MXNet)

- Tư vấn tối ưu mã nguồn và siêu tham số để tận dụng tối đa Tensor Cores

- Sao lưu dữ liệu định kỳ và khôi phục nhanh chóng khi cần thiết

Bảo Mật Và Tuân Thủ Cao

Tất cả máy chủ GPU T4 tại VinaHost được đặt tại các datacenter chuẩn Tier 3 của CMC Telecom và FPT Telecom, đảm bảo:

- Uptime 99.9% theo cam kết SLA

- Chống DDoS miễn phí bảo vệ tối đa hệ thống

- Tường lửa cấp doanh nghiệp và cách ly mạng riêng biệt

- Quyền quản trị full root/administrator – tài nguyên không chia sẻ

Bảng giá dịch vụ:

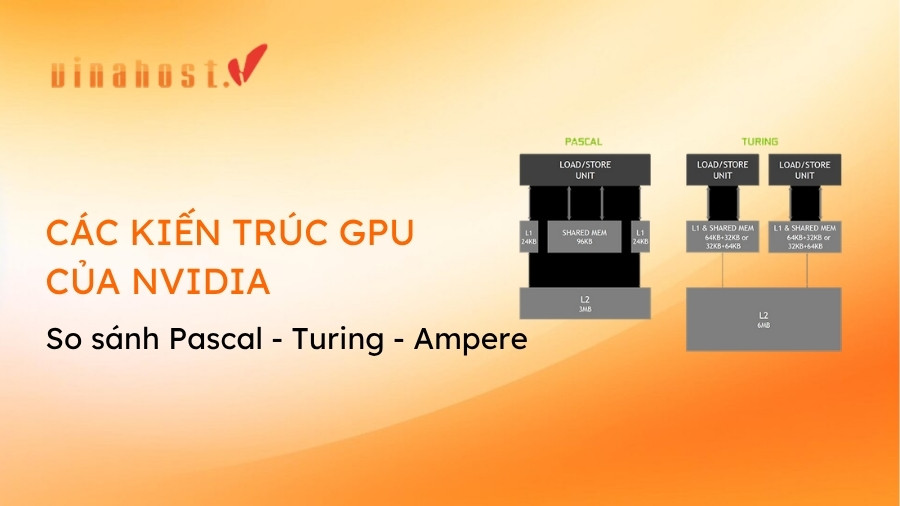

4. So Sánh GPU T4 Tensor Core Với Các Dòng GPU Khác

NVIDIA T4 với RTX 4000 Ada Generation

| Tiêu Chí | NVIDIA T4 Tensor Core | RTX 4000 Ada Generation |

|---|---|---|

| Kiến trúc | Turing (2018) | Ada Lovelace (2022) |

| CUDA Cores | 2.560 | 6.144 |

| Tensor Cores | 320 (Gen 2) | 192 (Gen 4 – hiện đại hơn) |

| Bộ nhớ VRAM | 16GB GDDR6 | 20GB GDDR6 |

| Băng thông bộ nhớ | 320 GB/s | 360 GB/s |

| Hiệu năng FP32 | 8.1 TFLOPS | 26.7 TFLOPS |

| Công suất (TDP) | 70W | 130W |

| Tối ưu cho | AI inference, tiết kiệm chi phí | AI training + inference, đồ họa 3D |

| Giá thuê/tháng | 6.200.000đ | 12.800.000đ |

Kết luận lựa chọn:

- Chọn T4 khi: Bạn cần triển khai inference AI quy mô lớn, xử lý video streaming, chatbot hoặc các dịch vụ real-time với ngân sách tối ưu. T4 mang lại hiệu suất/chi phí tốt nhất cho inference workloads.

- Chọn RTX 4000 Ada khi: Dự án yêu cầu cả training lẫn inference, xử lý đồ họa 3D phức tạp, hoặc cần hiệu năng FP32 cao hơn. Tensor Cores thế hệ 4 mạnh hơn nhưng chi phí vận hành tăng gần gấp đôi.

NVIDIA T4 vs Tesla V100

| Tiêu Chí | NVIDIA T4 | Tesla V100 |

|---|---|---|

| Use case chính | AI Inference | AI Training + HPC |

| Bộ nhớ | 16GB GDDR6 | 16GB/32GB HBM2 |

| Hiệu năng FP16 | 65 TFLOPS | 125 TFLOPS |

| Công suất | 70W | 300W |

| Chi phí điện/năm | ~1.8 triệu đồng | ~7.6 triệu đồng |

| Giá trị tốt nhất | Inference, video AI | Training mô hình lớn |

Nghiên cứu từ NVIDIA chỉ ra rằng 80% các workload AI trong sản xuất là inference (không phải training), khiến T4 trở thành lựa chọn kinh tế hơn cho đa số doanh nghiệp.

5. Ứng Dụng Thực Tế Của Máy Chủ GPU NVIDIA T4

Trí Tuệ Nhân Tạo Và Machine Learning

Inference AI theo thời gian thực:

Trong thử nghiệm thực tế của VinaHost với khách hàng, một máy chủ T4 có thể xử lý:

- 1.000 requests/giây cho mô hình phân loại ảnh ResNet-50

- 500 câu hỏi/giây cho chatbot dựa trên BERT-Base

- 300 câu trả lời/giây cho hệ thống Q&A sử dụng GPT-2

GPU T4 mang lại hiệu năng inference gấp 40 lần so với CPU Intel Xeon Gold 6140, giúp doanh nghiệp giảm độ trễ phản hồi từ 2-3 giây xuống còn dưới 50ms – yếu tố quyết định trải nghiệm người dùng trong các ứng dụng AI tương tác.

Các framework AI được hỗ trợ đầy đủ:

- TensorFlow / TensorFlow Lite

- PyTorch / TorchServe

- ONNX Runtime

- NVIDIA TensorRT (tối ưu inference)

- Apache MXNet

- Hugging Face Transformers

Xử Lý Video Và Phân Tích Thông Minh

GPU T4 tích hợp hardware encoder/decoder chuyên dụng cho video transcoding:

- Giải mã: Lên đến 38 luồng video Full-HD (1080p) đồng thời

- Mã hóa: 16 luồng H.264/HEVC 1080p @ 30fps

- Tăng tốc: Gấp 2 lần so với Tesla P4 thế hệ trước

Use case điển hình:

- An ninh thông minh: Phân tích camera giám sát với nhận diện khuôn mặt, phát hiện hành vi bất thường theo thời gian thực

- Live streaming AI: Thêm hiệu ứng AR/VR, làm đẹp tự động, dịch phụ đề trực tiếp cho nội dung video

- Video analytics: Đếm người, phân tích hành vi khách hàng trong cửa hàng retail

- Medical imaging: Phân tích hình ảnh y tế (X-quang, CT, MRI) với độ chính xác cao

Một khách hàng trong lĩnh vực an ninh của VinaHost đã triển khai hệ thống 100 camera giám sát với AI phát hiện xâm nhập chỉ sử dụng 3 máy chủ GPU T4, giảm 60% chi phí so với giải pháp CPU truyền thống.

Xử Lý Ngôn Ngữ Tự Nhiên (NLP)

Với Tensor Cores tối ưu cho mixed precision, GPU T4 tăng tốc inference các mô hình NLP hiện đại như BERT, GPT, T5 lên 3-5 lần so với chế độ FP32 thông thường, cho phép triển khai chatbot đa ngôn ngữ, phân tích sentiment và tóm tắt văn bản tự động với độ trễ cực thấp.

Các ứng dụng NLP phổ biến:

- Chatbot chăm sóc khách hàng tự động

- Hệ thống dịch máy đa ngôn ngữ

- Phân tích sentiment mạng xã hội

- Trích xuất thông tin từ văn bản (Named Entity Recognition)

- Tóm tắt tài liệu tự động

- Hệ thống gợi ý nội dung cá nhân hóa

Hệ Thống Gợi Ý (Recommender Systems)

Các nền tảng thương mại điện tử, streaming media và mạng xã hội sử dụng GPU T4 để:

- Xử lý hàng triệu sự kiện người dùng theo thời gian thực

- Tính toán similarity giữa hàng triệu sản phẩm/nội dung

- Cá nhân hóa gợi ý cho từng người dùng với độ trễ <100ms

- A/B testing nhiều mô hình gợi ý đồng thời

Nghiên Cứu Khoa Học Và Giáo Dục

Trường đại học và viện nghiên cứu sử dụng máy chủ GPU T4 cho:

- Training và fine-tuning mô hình deep learning trong nghiên cứu

- Phân tích dữ liệu y sinh học (genomics, protein folding)

- Mô phỏng vật lý và khí hậu

- Computer vision cho robot tự hành

- Đào tạo sinh viên về AI/ML với tài nguyên GPU chuyên nghiệp

Câu hỏi thường gặp

GPU T4 có phù hợp cho deep learning training không?

GPU T4 chủ yếu được thiết kế để tối ưu hóa cho inference, nhưng nó vẫn hỗ trợ tốt việc huấn luyện các mô hình cỡ nhỏ và trung bình. Khi huấn luyện những mô hình lớn với hơn 100 triệu tham số, tốt hơn nên chọn GPU như A100 hoặc V100. Mặc dù vậy, T4 đặc biệt thích hợp để thực hiện fine-tuning cho các mô hình đã được đào tạo sẵn và áp dụng phương pháp học chuyển giao.

T4 có phù hợp cho edge computing không?

Có! Với thiết kế nhỏ gọn (half-height, half-length) và công suất thấp 70W, T4 rất phù hợp cho:

- Edge servers tại cửa hàng retail

- Xe tự lái và robot tự hành

- Medical imaging devices

- Industrial IoT gateways

- Smart city infrastructure

NVIDIA cung cấp Jetson AGX Xavier cho edge computing nhỏ hơn, nhưng T4 là lựa chọn tốt cho edge servers cần hiệu năng cao hơn.

GPU NVIDIA T4 có phù hợp để chơi game không?

Không. NVIDIA T4 là GPU dành cho trung tâm dữ liệu, được tối ưu cho các tác vụ AI và tính toán chuyên nghiệp, không phải để chơi game. Nó thiếu các cổng xuất hình và driver không được tối ưu cho game.

Khi nào tôi nên chọn T4 thay vì các GPU mạnh hơn như A100?

Bạn nên chọn T4 khi nhu cầu chính của bạn là suy luận AI, xử lý video, hoặc các dự án có cho phí vừa phải. T4 cung cấp hiệu suất inference xuất sắc với chi phí rất hợp lý. Nếu bạn cần huấn luyện (training) các mô hình AI cực lớn từ đầu, các GPU mạnh hơn như A100 sẽ là lựa chọn phù hợp hơn.

T4 có hỗ trợ NVLink không?

Không, GPU T4 không hỗ trợ NVLink. Các GPU giao tiếp qua PCIe 3.0 x16 với băng thông 16GB/s mỗi chiều. Đối với workload cần giao tiếp GPU-GPU bandwidth cao, nên xem xét A100 hoặc H100 với NVLink.

Driver và CUDA version nào tương thích với T4?

GPU T4 yêu cầu:

- Driver NVIDIA: 418.40 trở lên (khuyến nghị 525.x hoặc mới hơn)

- CUDA Toolkit: 10.0 trở lên (hỗ trợ tốt nhất với CUDA 11.x và 12.x)

- cuDNN: 7.4 trở lên

VinaHost hỗ trợ cài đặt và cấu hình driver phù hợp với framework AI bạn sử dụng.

Có thể cài đặt những hệ điều hành và framework nào trên máy chủ GPU T4?

Máy chủ GPU T4 hỗ trợ hầu hết các hệ điều hành phổ biến như Linux (Ubuntu, CentOS) và Windows Server. Nó cũng tương thích hoàn toàn với các framework AI/ML hàng đầu như: TensorFlow (1.x và 2.x); PyTorch (1.x và 2.x); ONNX Runtime; MXNet; JAX; Hugging Face Transformers; Rapids AI (GPU-accelerated data science); TensorRT (inference optimization) và NVIDIA CUDA Toolkit.

GPU T4 tiêu tốn điện bao nhiêu trong thực tế?

Với TDP 70W, một máy chủ GPU T4 chạy liên tục 24/7 trong một tháng tiêu thụ:

- Điện năng: 70W × 24h × 30 ngày = 50.4 kWh/tháng

- Chi phí điện (giá 3.000đ/kWh): ~151.200đ/tháng

- Chi phí làm mát (30% điện GPU): ~45.000đ/tháng

So với Tesla V100 (300W), T4 giúp tiết kiệm ~77% chi phí điện năng. (Mức giá ước tính)

Làm thế nào để chuyển mô hình từ CPU sang GPU T4?

Quá trình migration đơn giản với hầu hết các framework:

Với PyTorch:

model = model.cuda() # Chuyển model lên GPU

input_tensor = input_tensor.cuda() # Chuyển data lên GPU

Với TensorFlow:

with tf.device('/GPU:0'):

model = create_model()

model.fit(train_data)Kết Luận

Với nhận định của chúng tôi, hiện tại server GPU NVIDIA T4 Tensor Core đại diện cho sự cân bằng hoàn hảo giữa hiệu năng AI inference mạnh mẽ, chi phí vận hành tối ưu và khả năng mở rộng linh hoạt.

Với kiến trúc Turing tiên tiến, 320 Tensor Cores thế hệ 2, 16GB VRAM GDDR6 và mức tiêu thụ điện chỉ 70W, GPU T4 đã chứng minh là lựa chọn hàng đầu cho inference AI, xử lý video thông minh, NLP và countless các ứng dụng machine learning trong sản xuất.

Dù bạn là startup AI đang tìm kiếm hạ tầng linh hoạt để phát triển sản phẩm, doanh nghiệp cần triển khai chatbot và hệ thống gợi ý quy mô lớn, hay viện nghiện cứu muốn tăng tốc các thử nghiệm khoa học – máy chủ GPU NVIDIA T4 Tensor Core tại VinaHost là giải pháp đáng tin cậy với chi phí tối ưu nhất.

Bài viết khác về các dòng Card CPU

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文