Trong thời đại mà trí tuệ nhân tạo, học sâu và tính toán khoa học đang bùng nổ, việc tăng tốc xử lý bằng GPU đã trở thành yếu tố then chốt. Nếu bạn từng nghe đến thuật ngữ CUDA khi tìm hiểu về card đồ họa NVIDIA hay các giải pháp điện toán đám mây, thì đây chính là công nghệ đang định hình lại cách chúng ta xử lý dữ liệu lớn.

Với hơn 16 năm kinh nghiệm triển khai hạ tầng GPU cho khách hàng doanh nghiệp, VinaHost sẽ giúp bạn hiểu sâu về CUDA – từ kiến trúc cơ bản đến những xu hướng mới nhất năm 2025.

Bài viết này sẽ giúp bạn khám phá thế giới của CUDA:

- 🚀 CUDA là gì và tại sao nó lại quan trọng? Tìm hiểu cách CUDA “mở khóa” sức mạnh xử lý song song của GPU để tăng tốc mọi thứ, từ AI, học máy, cho đến phân tích dữ liệu lớn.

- ⚙️ Cách thức hoạt động: Khám phá cấu trúc 3 tầng thông minh (Thread, Block, Grid) giúp CUDA chia nhỏ một nhiệm vụ khổng lồ thành hàng triệu tác vụ tí hon để xử lý đồng thời.

- 🏢 Ứng dụng thực tế: CUDA không chỉ dành cho game thủ hay nhà khoa học. Nó đã trở thành nền tảng cốt lõi của các dịch vụ đám mây (AWS, Azure), giúp các doanh nghiệp tăng tốc xử lý và đổi mới.

- ⚖️ So sánh với các công nghệ khác: Đặt CUDA lên bàn cân với các đối thủ như OpenCL và Stream Processor của AMD để thấy rõ ưu thế vượt trội về hiệu năng và hệ sinh thái hỗ trợ.

Sẵn sàng để khám phá công nghệ đang định hình lại tương lai của điện toán hiệu năng cao chưa? Hãy cùng VinaHost tìm hiểu chi tiết ngay bên dưới! 👇

1. CUDA là gì?

CUDA viết đầy đủ là Compute Unified Device Architecture – nền tảng tính toán song song và mô hình lập trình độc quyền do NVIDIA phát triển từ năm 2006. Kiến trúc Thiết bị Tính toán Hợp nhất cho phép lập trình viên khai thác sức mạnh xử lý song song của GPU để tăng tốc các tác vụ tính toán nặng gấp hàng chục lần so với CPU truyền thống.

NVIDIA Developer Jonathan Bentz, Tony Scudiero, Jon Waxman và Rob ArmstrongTrích dẫn từ Chuyên giaCUDA Toolkit 13.0 ra mắt năm 2025 đã tích hợp tile programming model và hỗ trợ mạnh mẽ cho Python, đánh dấu bước tiến quan trọng trong việc đơn giản hóa lập trình GPU cho các nhà phát triển AI.

Nguồn: Nvidia

Khác với việc GPU chỉ phục vụ đồ họa, CUDA biến GPU thành bộ xử lý đa năng (GPGPU – General Purpose GPU), phục vụ đa dạng lĩnh vực:

- Trí tuệ nhân tạo và học máy: Huấn luyện mô hình deep learning nhanh hơn 10-100 lần

- Khoa học dữ liệu: Phân tích big data, data mining, xử lý dữ liệu phức tạp

- Tính toán khoa học: Mô phỏng vật lý, hóa học, khí tượng học

- Xử lý hình ảnh và video: Render 3D, chỉnh sửa video 4K/8K

- Điện toán đám mây: GPU servers, cloud computing services

2. NVIDIA phát triển CUDA Core để giải quyết vấn đề gì?

2.1 Bối cảnh ra đời: Khi CPU gặp giới hạn

Trước khi CUDA xuất hiện vào năm 2006, ngành công nghiệp đối mặt với một thách thức lớn: CPU với kiến trúc tuần tự không thể đáp ứng nhu cầu tính toán song song khổng lồ từ các lĩnh vực như AI, khoa học dữ liệu, và mô phỏng vật lý. GPU lúc đó chỉ phục vụ đồ họa, trong khi tiềm năng xử lý song song của chúng vẫn chưa được khai thác.

Trong hơn 16 năm hoạt động, VinaHost đã chứng kiến sự chuyển đổi từ CPU-based sang GPU-accelerated computing. Khách hàng triển khai GPU server với CUDA thường đạt hiệu suất tăng 20-50 lần trong các tác vụ AI training và data processing.

2.2 CUDA Core: Kiến trúc xử lý song song thế hệ mới

CUDA Core là đơn vị xử lý song song được NVIDIA thiết kế chuyên biệt để thực thi hàng nghìn luồng tính toán đồng thời. Nếu CPU có 8-16 lõi xử lý tuần tự mạnh mẽ, thì GPU hiện đại có thể chứa hàng nghìn đến hàng chục nghìn CUDA cores xử lý song song.

| Đặc điểm | CPU Core | CUDA Core |

|---|---|---|

| Số lượng lõi | 8-64 lõi (consumer/server) | 2,560 – 18,432 lõi (RTX 4070 – H100) |

| Kiến trúc xử lý | Tuần tự (sequential) | Song song (parallel) |

| Tốc độ mỗi lõi | Rất cao (3-5 GHz) | Thấp hơn (1-2 GHz) |

| Ứng dụng tối ưu | Tác vụ phức tạp, logic điều khiển | Tính toán song song, matrix operations |

| Hiệu năng AI/ML | Baseline (1x) | 10-100x nhanh hơn CPU |

2.3 Vai trò của CUDA trong hệ sinh thái NVIDIA

CUDA không chỉ là kiến trúc phần cứng mà còn là nền tảng phần mềm hoàn chỉnh bao gồm:

- CUDA Toolkit: Bộ công cụ lập trình với compiler, debugger, profiler

- Thư viện tăng tốc: cuBLAS, cuDNN, cuFFT, TensorRT, Thrust

- Hỗ trợ ngôn ngữ: C, C++, Python, Fortran, MATLAB

- Framework AI: TensorFlow, PyTorch, JAX đều tối ưu cho CUDA

3. Tại sao cần dùng CUDA thay vì CPU truyền thống?

Câu hỏi này thường được đặt ra khi doanh nghiệp cân nhắc đầu tư vào hạ tầng GPU. Với kinh nghiệm triển khai của mình, chúng tôi nhận thấy rằng việc chuyển đổi sang CUDA-based computing mang lại lợi ích vượt trội trong các tình huống cụ thể.

3.1 Khác biệt cốt lõi giữa CPU và GPU CUDA

Trong kiến trúc GPU, lõi CUDA tương đương với lõi trong CPU về chức năng cơ bản, nhưng khác biệt về thiết kế và mục đích sử dụng. CPU được tối ưu cho xử lý tuần tự phức tạp với khả năng thực thi vài luồng song song, trong khi lõi CUDA là thành phần của hệ thống xử lý song song quy mô lớn, có thể xử lý hàng nghìn luồng đồng thời.

Theo trải nghiệm thực tế của chúng tôi, một khách hàng trong lĩnh vực fintech đã giảm thời gian training mô hình dự đoán từ 48 giờ xuống còn 2.5 giờ sau khi chuyển từ CPU cluster sang GPU server với 8x NVIDIA A100.

3.2 Khi nào nên sử dụng CUDA?

| Loại tác vụ | CPU tối ưu | CUDA GPU tối ưu |

|---|---|---|

| Tính toán tuần tự | ✅ Rất tốt | ❌ Không phù hợp |

| Xử lý matrix/tensor | ❌ Chậm | ✅ Nhanh hơn 50-100x |

| Training AI/ML | ❌ Không khả thi với model lớn | ✅ Tối ưu nhất |

| Render 3D/Video | ❌ Rất chậm | ✅ Nhanh hơn 20-50x |

| Xử lý văn bản đơn giản | ✅ Đủ dùng | ⚠️ Over-kill, lãng phí |

3.3 Ví dụ thực tế về hiệu suất CUDA

Để minh họa sự khác biệt, hãy xem các case study thực tế mà đội ngũ kỹ thuật VinaHost đã triển khai:

- Game rendering: CUDA giúp kết xuất hình ảnh 4K real-time với 120+ FPS, mang lại trải nghiệm mượt mà và chân thực

- Điện toán khoa học: Mô phỏng khí tượng toàn cầu giảm từ 7 ngày xuống 6 giờ với CUDA cluster

- AI training: Huấn luyện mô hình NLP 175B parameters (GPT-scale) chỉ khả thi với hàng nghìn GPU CUDA

- Medical imaging: Phân tích CT scan/MRI nhanh hơn 40 lần, hỗ trợ chẩn đoán sớm

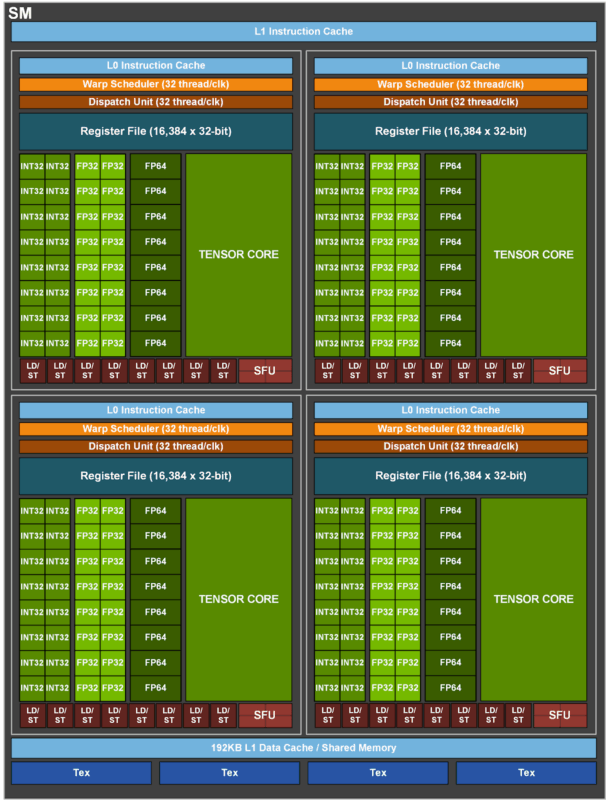

4. Thành phần kiến trúc chi tiết của nhân CUDA

Kiến trúc nhân CUDA được thiết kế để thực hiện tính toán song song hiệu quả, thông qua việc tổ chức và phối hợp nhiều thành phần phần cứng bên trong GPU. Dưới đây là ba thành phần cốt lõi cấu thành nên một nhân CUDA:

Đơn vị tính toán logic (ALU – Arithmetic Logic Unit)

Đây là trung tâm thực hiện các phép toán số học và logic. Mỗi lõi CUDA có khả năng xử lý song song một phép toán dấu chấm động (FP32/FP64) và một phép toán số nguyên (INT32), giúp tăng tốc các tác vụ như kết xuất đồ họa, mô phỏng vật lý hay xử lý dữ liệu AI.

Với kiến trúc Ampere và Hopper mới nhất (2024-2025), NVIDIA đã tích hợp thêm Tensor Cores cho phép tính toán ma trận hỗn hợp precision (FP16, BF16, INT8) nhanh hơn gấp nhiều lần.

Bộ nhớ đăng ký (Register Memory)

Là vùng lưu trữ tốc độ cao nhất bên trong lõi CUDA, được dùng để chứa các biến và dữ liệu tạm thời trong quá trình xử lý. Hiệu suất của register file ảnh hưởng trực tiếp đến tốc độ thực thi luồng tính toán. GPU hiện đại như H100 có tới 256KB register file per SM (Streaming Multiprocessor).

Bộ nhớ chia sẻ (Shared Memory)

Đây là vùng bộ nhớ dùng chung giữa các lõi CUDA trong cùng một Streaming Multiprocessor (SM). Nó cho phép các lõi trao đổi dữ liệu nhanh hơn, đồng bộ hóa tốt hơn và giảm phụ thuộc vào global memory – vốn có độ trễ cao hơn. Shared memory hoạt động như một “cache do lập trình viên kiểm soát”, với băng thông lên tới 20+ TB/s trên kiến trúc Hopper.

Kiến trúc Hopper (H100) ra mắt 2024 mang đến bước nhảy vọt với Transformer Engine, Thread Block Clusters và Tensor Memory Accelerator – giúp tăng hiệu năng AI training lên 9x so với thế hệ trước.

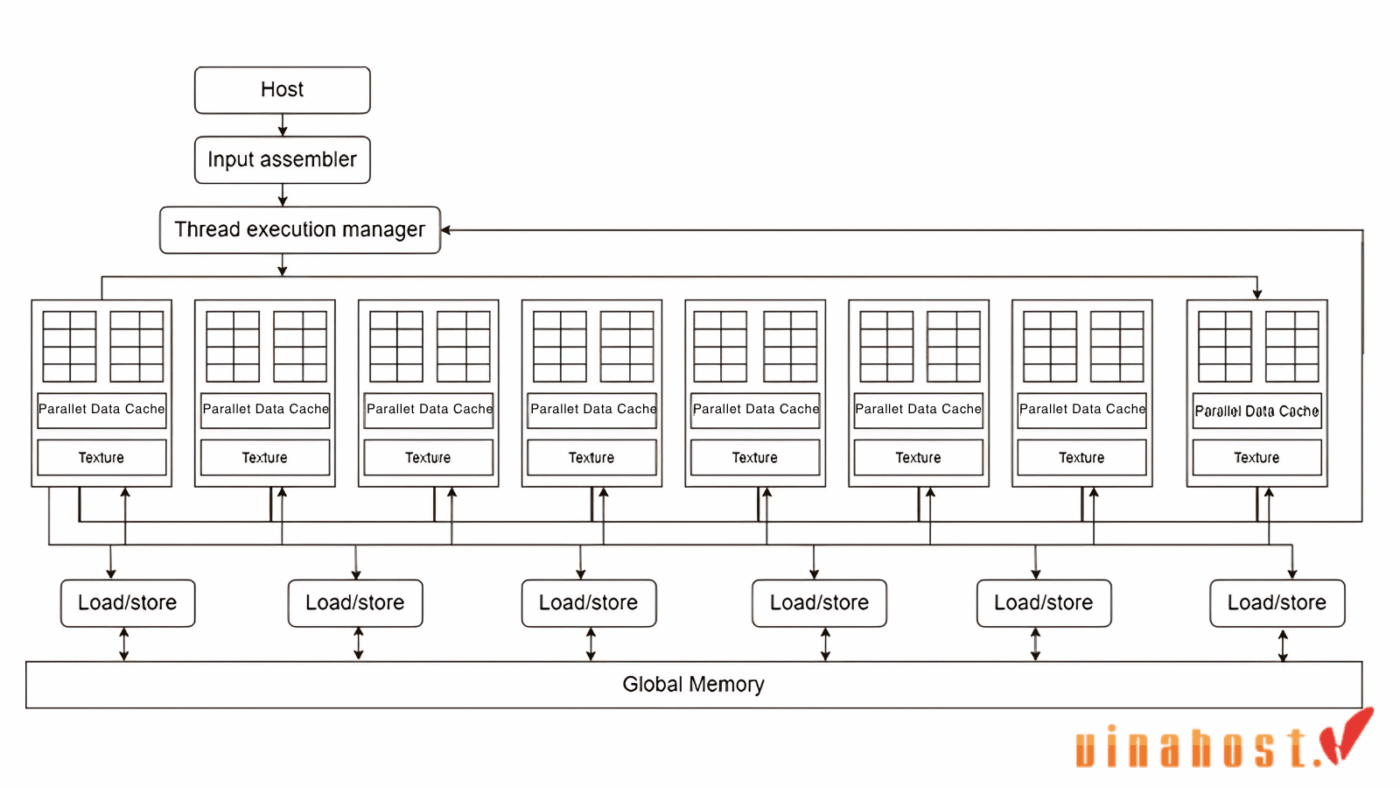

5. Cơ chế hoạt động chi tiết của CUDA: Thread, Block, Grid

Sau khi hiểu về phần cứng, chúng ta cần tìm hiểu mô hình lập trình CUDA – cách mà phần mềm khai thác sức mạnh phần cứng này. Đây là kiến thức cốt lõi để bất kỳ ai muốn lập trình CUDA hay tối ưu ứng dụng GPU.

5.1 Kiến trúc song song ba lớp của CUDA

CUDA phân chia công việc rõ ràng giữa CPU (host) và GPU (device) thông qua ba loại chức năng chính:

5.1.1 Host Functions (CPU)

Trong mô hình CUDA, CPU đóng vai trò máy chủ (host). Các hàm host là những hàm thông thường được viết bằng C/C++, chỉ thực thi trên CPU. Chúng đảm nhiệm:

- Khởi tạo dữ liệu và cấp phát bộ nhớ

- Cấu hình GPU và transfer data giữa host-device

- Gọi kernel functions để GPU thực thi

- Thu thập kết quả và xử lý post-processing

5.1.2 Kernel Functions (CPU → GPU)

Hàm kernel là cầu nối giữa CPU và GPU, được định nghĩa bằng từ khóa __global__. Khi CPU gọi kernel, CUDA runtime sẽ:

- Phân chia công việc thành hàng nghìn threads

- Tổ chức threads thành blocks và grid

- Dispatch các blocks lên các SMs trên GPU

- Thực thi song song tất cả threads

5.1.3 Device Functions (GPU only)

Hàm device được định nghĩa bằng từ khóa __device__, chỉ được gọi và thực thi hoàn toàn bên trong GPU. Chúng đóng vai trò như helper functions, hỗ trợ kernel xử lý logic phức tạp hơn.

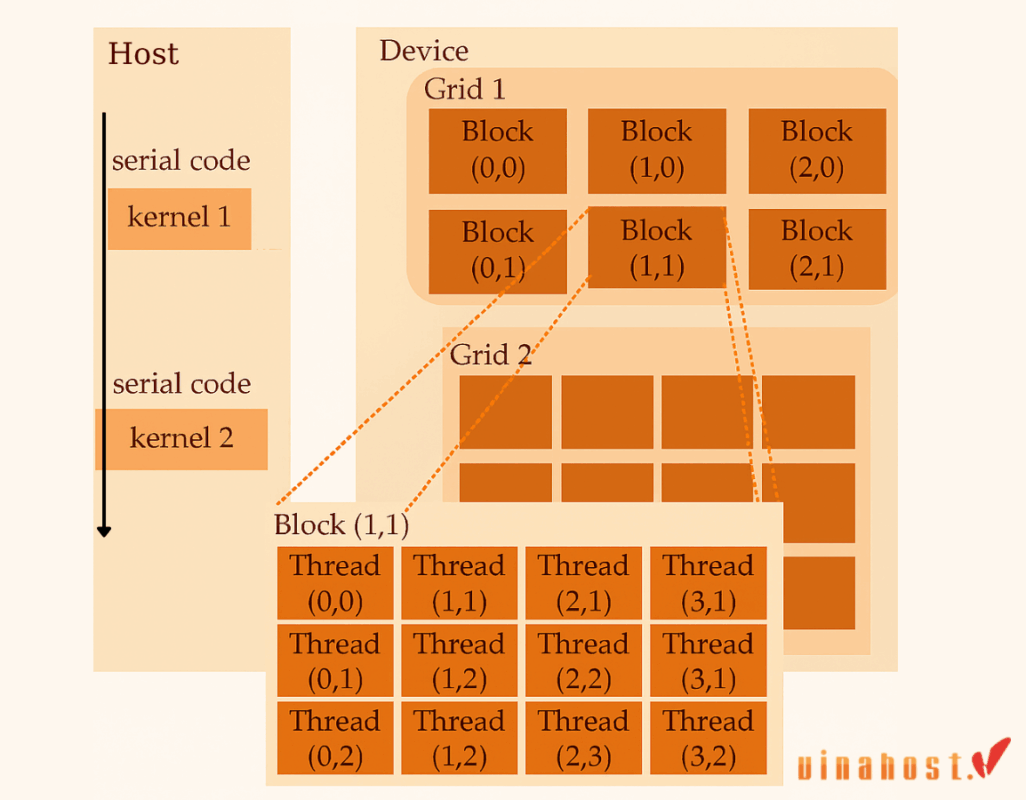

5.2 Mô hình Thread → Block → Grid

Để tận dụng tối đa khả năng song song, CUDA tổ chức luồng tính toán theo cấu trúc phân cấp ba tầng:

Thread: Đơn vị xử lý cơ bản nhất

Mỗi thread là một “worker” thực hiện một phần nhỏ của nhiệm vụ. Thread có ID duy nhất (threadIdx) để xác định phần việc của mình. Các thread trong cùng block có thể:

- Chia sẻ shared memory

- Đồng bộ hóa qua

__syncthreads() - Giao tiếp nhanh thông qua shared memory

Giới hạn: Mỗi block tối đa 1,024 threads (kiến trúc Ampere/Hopper)

Block: Nhóm các threads làm việc cùng nhau

Block là tập hợp threads chạy cùng một kernel. Tất cả threads trong block:

- Chạy trên cùng một Streaming Multiprocessor (SM)

- Có thể truy cập shared memory chung (48-164KB tùy GPU)

- Có block ID riêng (

blockIdx) để xác định vị trí trong grid

Block có thể tổ chức 1D, 2D hoặc 3D tùy theo bài toán (ví dụ: xử lý ảnh dùng 2D, simulation 3D dùng 3D).

Grid: Tập hợp tất cả blocks

Grid là cấu trúc song song lớn nhất, đại diện cho toàn bộ nhiệm vụ. Mỗi lần gọi kernel tạo ra một grid chứa:

- Hàng nghìn blocks (giới hạn 2³¹-1 blocks per dimension)

- Hàng triệu threads tổng cộng

- Các blocks được phân phối tự động lên các SMs

Với kiến trúc H100, mỗi GPU có 132 SMs, mỗi SM xử lý tới 64 warps (2,048 threads) đồng thời. Điều này cho phép thực thi hơn 270,000 threads song song trên toàn GPU.

5.3 Ví dụ minh họa: Cộng hai ma trận

Để hiểu rõ hơn, hãy xem ví dụ thực tế về cách CUDA xử lý phép cộng hai ma trận 1024×1024:

// Định nghĩa kernel function

__global__ void matrixAdd(float *A, float *B, float *C, int N) {

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

if (row < N && col < N) {

int index = row * N + col;

C[index] = A[index] + B[index];

}

}

// Gọi kernel từ CPU

dim3 threadsPerBlock(16, 16); // 256 threads per block

dim3 numBlocks(N/16, N/16); // 4096 blocks total

matrixAdd<<<numBlocks, threadsPerBlock>>>(d_A, d_B, d_C, N);

Trong ví dụ này:

- Grid: 64×64 = 4,096 blocks

- Block: 16×16 = 256 threads

- Tổng threads: 1,048,576 threads xử lý đồng thời

- Thời gian: ~0.5ms trên RTX 4090 (vs ~50ms trên CPU)

6. Ứng dụng thực tế của CUDA trong Cloud Computing và AI

Với khả năng xử lý song song mạnh mẽ, CUDA đã vượt xa phạm vi đồ họa truyền thống để trở thành xương sống của hạ tầng điện toán hiện đại. Dưới đây là những lĩnh vực mà CUDA đang tạo ra tác động lớn nhất.

6.1 Trí tuệ nhân tạo và Machine Learning

Đây là lĩnh vực CUDA phát huy vai trò quan trọng nhất. Trong thực tế triển khai cho khách hàng, chúng tôi nhận thấy:

- Training mô hình AI: CUDA giúp huấn luyện mô hình nhanh hơn 10-100 lần nhờ tính toán ma trận song song. Các framework như TensorFlow, PyTorch đều được tối ưu sâu cho CUDA.

- Deep Learning: Các mô hình lớn như GPT, BERT, Stable Diffusion chỉ khả thi khi training trên hàng trăm/nghìn GPU CUDA.

- Inference realtime: Xử lý nhận diện hình ảnh, xử lý ngôn ngữ tự nhiên với độ trễ thấp (< 100ms).

Một startup AI của chúng tôi đã giảm chi phí training từ $45,000/tháng (AWS CPU instances) xuống $8,500/tháng (GPU server) khi chuyển sang CUDA-optimized infrastructure.

6.2 Đồ họa và ngành giải trí

Đây là lĩnh vực truyền thống của GPU, nhưng CUDA đã đưa khả năng đồ họa lên tầm cao mới:

- Game rendering: CUDA hỗ trợ ray tracing real-time, physics simulation (PhysX), và AI-powered DLSS 3.0 giúp tăng FPS lên 2-4 lần.

- Phim và animation: Các studio lớn như Pixar, ILM sử dụng CUDA render farm để tạo ra các khung hình chất lượng cao trong phim blockbuster.

- Live streaming: Mã hóa video 4K/8K real-time với codec H.264/H.265 hardware-accelerated.

6.3 Dịch vụ đám mây (Cloud Services)

CUDA là nền tảng cốt lõi của các dịch vụ GPU cloud từ các nhà cung cấp lớn như AWS, Microsoft Azure và Google Cloud Platform. Điều này giúp các dịch vụ đám mây không chỉ linh hoạt mà còn mạnh mẽ vượt trội về hiệu năng tính toán.

Amazon Web Services (AWS)

Người dùng có thể lựa chọn các dòng GPU instance như P3, P4, G5, hay mới nhất là P5 với GPU Blackwell, đều được tích hợp sẵn CUDA Toolkit và các thư viện tăng tốc như cuDNN, TensorRT hay cuBLAS.

Các giải pháp này cho phép xử lý nhanh chóng các tác vụ chuyên sâu như huấn luyện mô hình AI, xử lý video, mô phỏng vật lý hoặc dựng hình 3D ở quy mô lớn mà không cần đầu tư phần cứng tại chỗ.

Microsoft Azure

Máy ảo GPU thuộc dòng N-series (NC, ND, NV) với khả năng hỗ trợ CUDA mạnh mẽ, tối ưu cho các workload như học sâu, đồ họa chuyên nghiệp hoặc mô phỏng tính toán hiệu năng cao (HPC). Azure còn hỗ trợ triển khai các container từ NVIDIA NGC, giúp nhà phát triển dễ dàng tích hợp CUDA vào hệ thống một cách linh hoạt và bảo mật.

Google Cloud Platform

- A2 instances: NVIDIA A100 với CUDA 12.x

- G2 instances: L4 GPU cho inference

- TPU alternative: Nhưng vẫn hỗ trợ CUDA ecosystem

CUDA trong dịch vụ đám mây không chỉ đơn thuần là giải pháp tăng tốc — nó đã trở thành nền tảng mở rộng hiệu suất xử lý cho AI, khoa học dữ liệu, và doanh nghiệp hiện đại. Với khả năng xử lý hàng nghìn luồng song song, CUDA giúp rút ngắn thời gian thực thi, giảm chi phí vận hành, đồng thời mở ra khả năng mở rộng không giới hạn trên hạ tầng đám mây.

6.4 Email và các ứng dụng doanh nghiệp

CUDA không chỉ phục vụ cho AI hay đồ họa mà còn được ứng dụng trong nhiều nền tảng doanh nghiệp như email, CRM hay hệ thống quản lý dữ liệu. Trong các hệ thống email quy mô lớn, CUDA giúp tăng tốc các tác vụ như lọc thư rác, phát hiện tấn công mạng và tìm kiếm dữ liệu nhờ khả năng xử lý song song hiệu quả.

Tương tự, trong các ứng dụng doanh nghiệp như ERP hoặc phân tích người dùng, CUDA hỗ trợ xử lý khối lượng dữ liệu lớn nhanh chóng hơn, góp phần nâng cao hiệu suất và độ tin cậy của hệ thống.

6.5 Khoa học dữ liệu và Analytics

CUDA đã cách mạng hóa cách chúng ta xử lý big data:

- RAPIDS AI: Framework xử lý data science trên GPU, nhanh hơn pandas 50-100x

- SQL acceleration: BlazingSQL cho phép query terabyte data trong vài giây

- Graph analytics: cuGraph xử lý đồ thị lớn (billions nodes) nhanh hơn NetworkX

6.6 Tính toán khoa học (HPC – High Performance Computing)

- Mô phỏng vật lý: ANSYS, COMSOL sử dụng CUDA mô phỏng fluid dynamics, structural analysis

- Hóa học tính toán: GROMACS, AMBER tăng tốc molecular dynamics

- Khí tượng: WRF model dự báo thời tiết với độ phân giải cao

7. So sánh CUDA với các công nghệ khác

CUDA không phải là công nghệ duy nhất được sử dụng trong lĩnh vực tăng tốc phần cứng và xử lý song song. Bên cạnh nó, các nền tảng như OpenCL và kiến trúc Stream Processor của chip AMD cũng đóng vai trò quan trọng trong nhiều hệ thống điện toán hiệu năng cao. Để hiểu rõ hơn vị trí và ưu thế của CUDA, ta sẽ cùng so sánh với hai đối thủ chính sau đây:

7.1 So sánh với OpenCL

Khi lập trình tăng tốc trên GPU, CUDA và OpenCL là hai nền tảng phổ biến nhất. Mỗi nền tảng đều có điểm mạnh và hạn chế riêng, tùy thuộc vào nhu cầu về hiệu năng, khả năng tương thích và mục tiêu triển khai.

- Hiệu năng và tối ưu hóa

CUDA được NVIDIA phát triển dành riêng cho GPU của họ, do đó nó tận dụng tối đa phần cứng, mang lại hiệu suất cao hơn trong nhiều ứng dụng thực tế, đặc biệt là AI, đồ họa và tính toán khoa học. Nhờ trình biên dịch chuyên biệt và hệ sinh thái thư viện tối ưu, CUDA thường cho kết quả vượt trội khi chạy trên phần cứng NVIDIA.

OpenCL, trái lại, là nền tảng mở, hỗ trợ nhiều loại phần cứng từ các hãng như AMD, Intel và cả CPU. Tuy nhiên, vì phải đảm bảo tính di động cao nên OpenCL khó tối ưu sâu cho từng thiết bị, dẫn đến hiệu suất không ổn định bằng CUDA trong nhiều trường hợp.

- Tính tương thích phần cứng và hệ điều hành

CUDA chỉ hoạt động trên GPU NVIDIA, nhưng hỗ trợ tốt các hệ điều hành lớn như Windows, Linux và macOS. Trong khi đó, OpenCL linh hoạt hơn, có thể chạy trên CPU, GPU và các kiến trúc phần cứng khác, bao gồm cả AMD, Intel và Apple. Với môi trường đa nền tảng, OpenCL là lựa chọn phù hợp cho những hệ thống yêu cầu tính linh hoạt cao.

- Thư viện và hỗ trợ phát triển

CUDA nổi bật với hệ sinh thái thư viện mạnh mẽ như cuBLAS, cuFFT, cuSPARSE, Thrust, cuDNN, giúp lập trình viên dễ dàng tiếp cận và triển khai các thuật toán hiệu suất cao. OpenCL tuy có các thư viện như ViennaCL và thư viện của AMD, nhưng vẫn chưa thực sự phong phú và tối ưu như CUDA.

- Tính mở và cộng đồng phát triển

OpenCL là mã nguồn mở, được nhiều nhà phát triển và tổ chức hỗ trợ. Ngược lại, CUDA là framework độc quyền của NVIDIA, điều này có thể hạn chế về mặt pháp lý hoặc chiến lược trong một số tổ chức. Tuy nhiên, cộng đồng CUDA lớn mạnh, tài liệu phong phú và hỗ trợ kỹ thuật tốt hơn, nhất là từ chính NVIDIA.

Để giúp bạn hình dung rõ hơn sự khác biệt giữa hai nền tảng này, dưới đây là bảng so sánh tổng quan:

| CUDA | OpenCL | |

| Hiệu suất | Cao, tối ưu tốt trên GPU NVIDIA | Tùy thuộc phần cứng, khó tối ưu sâu |

| Phần cứng hỗ trợ | Chỉ GPU NVIDIA | GPU/CPU đa dạng (AMD, Intel, Apple…) |

| Tính mở rộng | Độc quyền | Mã nguồn mở, di động hơn |

| Thư viện hỗ trợ | Rất mạnh và tối ưu | Đang phát triển, ít phổ biến hơn |

| Cộng đồng | Rộng, hỗ trợ kỹ thuật tốt | Mới hơn, đang phát triển |

| Hệ điều hành | Windows, Linux, macOS (NVIDIA only) | Tất cả hệ điều hành phổ biến |

7.2 So sánh với Stream Processor AMD

Khi nói đến xử lý song song trên GPU, CUDA cores (trên GPU NVIDIA) và Stream Processors (trên GPU AMD) là hai khái niệm thường được nhắc đến. Dù cùng mục đích, nhưng chúng khác nhau về kiến trúc, hiệu suất và tính tối ưu.

Kiến trúc và hiệu suất

- CUDA được thiết kế riêng cho GPU NVIDIA nên tận dụng tối đa phần cứng, thường cho hiệu năng cao hơn trong các tác vụ như AI, tính toán khoa học, đồ họa…

- Stream Processors của AMD nhẹ hơn, đơn giản hơn, thường cần số lượng lớn hơn để đạt cùng mức hiệu suất. Tuy nhiên, hiệu suất thực tế còn phụ thuộc vào phần mềm và driver hỗ trợ.

Tính tương thích

- CUDA chỉ hoạt động trên phần cứng NVIDIA.

- Stream Processor có thể được sử dụng với nhiều nền tảng nhờ OpenCL hoặc ROCm, phù hợp với hệ thống dùng GPU Intel, AMD hoặc CPU hỗ trợ.

Thư viện và hỗ trợ

- CUDA có hệ sinh thái thư viện rất mạnh như cuDNN, cuBLAS, Thrust, giúp lập trình nhanh và hiệu quả.

- AMD cũng cung cấp thư viện, nhưng chưa phong phú bằng CUDA, nên việc phát triển phức tạp hơn.

Cộng đồng

- CUDA có cộng đồng lớn và tài liệu kỹ thuật phong phú.

- Stream Processor (qua OpenCL hoặc ROCm) có cộng đồng đang phát triển, nhưng hỗ trợ chưa rộng bằng CUDA.

Dưới đây là bảng so sánh CUDA và AMD Stream Processor chi tiết

| CUDA | Stream Processor | |

| Kiến trúc | Thiết kế đặc biệt cho tính toán song song, tối ưu cho GPU NVIDIA | Kiến trúc SIMD đơn giản hơn, yêu cầu nhiều nhân để đạt hiệu năng tương đương |

| Hiệu suất | Tối ưu tốt cho AI, khoa học, đồ họa – hiệu năng vượt trội nếu dùng thư viện CUDA | Phụ thuộc nhiều vào driver và phần mềm, có thể hiệu quả nhưng khó tối ưu |

| Số nhân xử lý | Ít hơn AMD nhưng mạnh hơn từng nhân (vì phức tạp và hiệu năng cao hơn) | Nhiều hơn CUDA cores, nhưng mỗi nhân yếu hơn |

| API hỗ trợ chính | CUDA (độc quyền của NVIDIA), hỗ trợ tốt C/C++ và Python | OpenCL, ROCm – ít phổ biến hơn và kém tối ưu hơn CUDA |

| Tương thích phần cứng | Chỉ hoạt động trên GPU NVIDIA | Hoạt động trên nhiều nền tảng (AMD, Intel, CPU) thông qua OpenCL/ROCm |

| Khả năng lập trình | Dễ dùng hơn nhờ CUDA toolkit, thư viện và hỗ trợ tốt | Phức tạp hơn, ít công cụ hỗ trợ chính thức và thư viện |

| Hệ sinh thái thư viện | Rất phong phú: cuDNN, cuBLAS, cuFFT, Thrust… | Ít thư viện hơn, một số có ROCm hoặc OpenCL thay thế |

| Tính di động mã nguồn | Chỉ dùng được trên GPU NVIDIA | Có thể chạy trên nhiều loại phần cứng nếu tuân thủ OpenCL |

| Cộng đồng & Tài liệu | Lớn, giàu tài nguyên, nhiều khóa học và hỗ trợ | Đang phát triển, ít hơn nhưng tăng nhanh nhờ ROCm và OpenCL |

7.3 Khi nào nên chọn CUDA?

Chúng tôi khuyến nghị chọn CUDA khi:

- ✅ AI/ML là ưu tiên hàng đầu (TensorFlow/PyTorch ecosystem)

- ✅ Cần stability và support tốt từ vendor

- ✅ Sẵn sàng đầu tư vào phần cứng NVIDIA

- ✅ Cần performance tối đa cho production workload

- ✅ Có đội ngũ engineer đã familiar với CUDA

Chọn OpenCL/ROCm khi:

- ⚠️ Cần chạy trên nhiều loại phần cứng khác nhau

- ⚠️ Budget hạn chế, AMD GPU có price/perf tốt hơn

- ⚠️ Workload không phụ thuộc nhiều vào AI frameworks

8. Xu hướng CUDA và GPU Computing năm 2025

Công nghệ CUDA không ngừng phát triển. Năm 2025 đánh dấu nhiều bước tiến quan trọng mà mọi professional trong lĩnh vực AI và HPC cần nắm bắt.

8.1 CUDA Toolkit 13.0

NVIDIA đã công bố CUDA Toolkit 13.0 tại GTC 2025 với những cải tiến đột phá:

Tile Programming Model

- Abstraction layer cao hơn giúp lập trình dễ dàng hơn

- Tự động điều chỉnh phân cấp bộ nhớ và tổ chức thread.

- Nâng cao hiệu suất làm việc của lập trình viên từ 3 đến 5 lần so với CUDA thông thường.

CUDA Python Native Support

- Viết CUDA kernels trực tiếp trong Python (không cần C++)

- Tích hợp native với NumPy, CuPy ecosystem

- JIT compilation với Numba acceleration

CUDA 13.0 giới thiệu tile programming model – một bước tiến lớn giúp lập trình viên tập trung vào logic thuật toán thay vì low-level optimization. Điều này giảm development time xuống 60% trong testing của NVIDIA.

Nâng cấp Math Libraries

- cuBLAS 13: Tăng hiệu suất gấp đôi cho các hoạt động ma trận.

- cuDNN 9: Tối ưu hóa cho các mô hình Transformer như GPT và BERT.

- cuFFT: Thực hiện nhanh phép biến đổi Fourier cho xử lý tín hiệu.

8.2 Kiến trúc Hopper (H100) và Superchip Grace Hopper

Kiến trúc Hopper đại diện cho thế hệ GPU mạnh mẽ nhất từ NVIDIA.

- Với 18,432 lõi CUDA: Đây là con số cao nhất từng có.

- Công cụ Transformer: Được thiết kế riêng cho các Mô hình Ngôn ngữ Lớn.

- Độ chính xác FP8: Giảm dung lượng bộ nhớ 50% mà vẫn duy trì độ chính xác.

- NVLink 4.0: Cung cấp băng thông lên đến 900 GB/s giữa các GPU.

- Grace Hopper: Kết hợp CPU dựa trên ARM và GPU trong cùng một gói, giúp giảm độ trễ.

8.3 Xu hướng AI và CUDA

Các Mô hình Ngôn ngữ Lớn (LLMs)

Các mô hình như GPT-4, Claude và Gemini được huấn luyện trên hàng nghìn GPU CUDA. Xu hướng năm 2025 bao gồm:

- Các mô hình ngày càng lớn hơn (với hơn 1 nghìn tỷ tham số).

- Chiến lược huấn luyện đa GPU như FSDP và DeepSpeed.

- Tối ưu hóa suy luận với TensorRT-LLM.

Generative AI

- Chuyển đổi văn bản thành hình ảnh: Như Stable Diffusion và DALL-E 3.

- Chuyển đổi văn bản thành video: Như Sora và Gen-2, đòi hỏi khả năng tính toán GPU lớn.

- Các đại lý AI: Như AutoGPT và LangChain để phối hợp.

8.4 Edge AI và Nền tảng Jetson

CUDA không chỉ dành cho trung tâm dữ liệu, mà NVIDIA Jetson đưa tính toán GPU xuống các thiết bị biên.

- Jetson Orin: Trang bị 2,048 lõi CUDA trong hình thức nhỏ gọn.

- Ứng dụng trong robotics: Các robot tự động và drone sử dụng tầm nhìn được tăng tốc bởi CUDA.

- Ứng dụng trong IoT: Các camera thông minh và tự động hóa công nghiệp.

8.5 Tính toán Lượng tử và CUDA

NVIDIA cuQuantum sử dụng CUDA để mô phỏng các mạch lượng tử:

- Giúp nghiên cứu các thuật toán lượng tử trên phần cứng cổ điển.

- Tăng tốc độ mô phỏng lượng tử lên gấp 1000 lần.

- Làm cầu nối giữa tính toán cổ điển và tính toán lượng tử.

Câu hỏi thường gặp

CUDA có miễn phí không?

Có, CUDA Toolkit hoàn toàn miễn phí để download và sử dụng cho mục đích thương mại và nghiên cứu. NVIDIA cung cấp free license cho cả developer và enterprise. Tuy nhiên, bạn cần phần cứng GPU NVIDIA để chạy CUDA.

Cần bao nhiêu CUDA cores để chạy AI?

Tùy vào model size:

- Học tập/thử nghiệm: RTX 3060 (3,584 cores) đủ cho small models

- Professional work: RTX 4090 (16,384 cores) hoặc A5000

- Production/Research: A100 (6,912 cores) hoặc H100 (14,592 cores) cho large-scale training

CUDA có chạy được trên card AMD không?

Không trực tiếp. CUDA là proprietary technology của NVIDIA. Tuy nhiên, bạn có thể:

- Dùng HIPify tool chuyển CUDA code sang ROCm (AMD)

- Viết lại bằng OpenCL (cross-platform nhưng performance thấp hơn)

- Dùng framework hỗ trợ cả CUDA và ROCm (PyTorch, TensorFlow)

Làm sao để bắt đầu học CUDA?

Lộ trình học CUDA hiệu quả:

- Nền tảng: Học C/C++ cơ bản, hiểu về parallel computing

- CUDA C: Đọc CUDA Programming Guide, làm Udacity course

- Hands-on: Cài CUDA Toolkit, chạy samples trên NVIDIA GPU

- Advanced: Học optimization techniques, profiling với Nsight

- Frameworks: Áp dụng vào TensorFlow/PyTorch cho AI

CUDA có phù hợp cho startup không?

Phụ thuộc vào từng trường hợp sử dụng:

- ✅ Phù hợp: AI/ML startup cần training models, workload intensive

- ✅ Phù hợp: SaaS products với AI features (recommendation, vision)

- ❌ Không cần: Web apps, CRUD applications, content websites

Lời khuyên: Bắt đầu với cloud GPU (VinaHost, AWS, GCP) trước khi đầu tư phần cứng.

CUDA Toolkit mới nhất là phiên bản nào?

Tính đến tháng 11/2025: CUDA Toolkit 13.0 là phiên bản mới nhất, ra mắt tháng 8/2025. Hỗ trợ từ compute capability 3.5 trở lên, tối ưu cho kiến trúc Ampere (RTX 30xx, A-series) và Hopper (H100, H200).

Có thể dùng nhiều GPU cùng lúc không?

Có, CUDA hỗ trợ multi-GPU programming qua:

- NCCL: NVIDIA Collective Communications Library cho distributed training

- NVLink: High-speed interconnect giữa các GPU (900 GB/s)

- CUDA Streams: Overlapping computation và data transfer

- Frameworks: PyTorch DDP, TensorFlow MirroredStrategy

CUDA có tốn nhiều điện không?

GPU tiêu thụ power đáng kể:

- RTX 4090: 450W TDP

- A100: 400W TDP

- H100: 700W TDP

Nhưng hiệu suất/watt vẫn tốt hơn CPU cho parallel workloads. Nên dùng GPU hiệu quả (không để idle), bật power management features.

Kết luận: CUDA – Chìa khóa cho tương lai điện toán

Qua hành trình tìm hiểu chi tiết từ khái niệm, kiến trúc, cơ chế hoạt động đến ứng dụng thực tế, chúng ta có thể thấy CUDA đã trở thành xương sống không thể thiếu của ngành công nghệ hiện đại. Từ AI và machine learning, đồ họa game, khoa học dữ liệu đến điện toán đám mây – CUDA đang định hình cách chúng ta xử lý thông tin và giải quyết các bài toán phức tạp.

Với kinh nghiệm hơn 17 năm trong ngành hosting và cloud computing, VinaHost đã chứng kiến sự chuyển đổi mạnh mẽ từ CPU-based sang GPU-accelerated infrastructure. Chúng tôi tin rằng việc hiểu rõ và áp dụng CUDA không chỉ là lợi thế cạnh tranh mà còn là yêu cầu thiết yếu cho các doanh nghiệp muốn dẫn đầu trong kỷ nguyên AI.

VinaHost cung cấp giải pháp Thuê máy chủ giá rẻ. Hỗ trợ 24/7, triển khai nhanh chóng, giá cạnh tranh cho doanh nghiệp Việt Nam.

Những xu hướng mới năm 2025 như CUDA 13.0 với tile programming model, kiến trúc Hopper, và sự bùng nổ của Large Language Models cho thấy CUDA sẽ còn quan trọng hơn nữa trong tương lai. Cho dù bạn là developer, data scientist hay IT decision maker, việc đầu tư thời gian tìm hiểu CUDA là một quyết định đúng đắn.

Nếu bạn đang cân nhắc triển khai hạ tầng GPU cho AI/ML workload hoặc cần tư vấn về giải pháp CUDA-based computing, đừng ngần ngại liên hệ đội ngũ chuyên gia của VinaHost. Chúng tôi sẵn sàng đồng hành cùng doanh nghiệp bạn trên con đường chuyển đổi số và ứng dụng trí tuệ nhân tạo.

Hãy tiếp tục theo dõi VinaHost để cập nhật những kiến thức mới nhất về công nghệ GPU, cloud computing và AI!

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文