GPGPU là gì? GPGPU là một thuật ngữ không còn xa lạ đối với các nhà lập trình và chuyên gia công nghệ, nhưng đối với nhiều người, khái niệm này vẫn còn khá mới mẻ. Trong bài viết này, VinaHost sẽ giới thiệu cách GPGPU hoạt động, ưu nhược điểm cũng như tính ứng dụng của nó trong việc giải quyết các bài toán phức tạp và tăng cường hiệu suất xử lý dữ liệu trong các ứng dụng hiện đại.

1. Tổng quan kiến thức về GPGPU

1.1 GPGPU là gì? Ví dụ về GPGPU

Để hiểu rõ về GPGPU, trước tiên ta cần hiểu GPU là đơn vị xử lý đồ họa – được viết tắt Graphics Processing Unit. GPU được thiết kế để xử lý các tác vụ liên quan đến đồ họa, chẳng hạn như hiển thị hình ảnh, video và đồ họa 3D,… thông thường GPU bổ trợ cho CPU (Central Processing Unit) để xử lý, tính toán các dữ liệu hình ảnh và xuất trên màn hình. Tuy nhiên việc hỗ trợ này chỉ xảy ra một chiều, nghĩa là chỉ có CPU tính toán và trả kết quả cho GPU xử lý hình ảnh chứ không có chiều ngược lại.

Do đó để CPU giao tiếp được với GPU ta cần đến sự hỗ trợ của GPGPU được viết tắt là General-Purpose Computing on Graphics Processing Units – Tính toán đa năng trên bộ xử lý đồ họa. Có thể hiểu rằng GPGPU là ứng dụng để hỗ trợ GPU trả lại các kết quả với CPU.

1.2. OpenCL và CUDA là gì?

OpenCL và CUDA là các khung cài đặt được phép sử dụng đơn vị xử lý đồ họa (GPU) để thực hiện các tính năng tối đa cho phép, không giới hạn chỉ định trong quá trình xử lý đồ họa. Đây là một thành phần của GPGPU, tức là để GPU và CPU giao tiếp với nhau ta cần một cầu nối là GPGPU. Nhưng để GPGPU làm việc ta cần đến một software frameworks gọi là OpenCL và CUDA.

OpenCL là gì?

OpenCL – viết tắt của Open Computing Language là một framework mã nguồn mở cho phép lập trình song song trên các nền tảng phần cứng đa dạng như CPU, GPU, DSP, FPGA và các bộ xử lý khác. Nó bao gồm:

- Ngôn ngữ lập trình: Dựa trên tiêu chuẩn C99 (và phiên bản mở rộng C++ cho OpenCL) dùng để viết các hàm gọi là kernel, chạy trên thiết bị tính toán.

- API: Cho phép lập trình viên truy cập, quản lý bộ nhớ, và điều phối việc thực thi các kernel trên các thiết bị phần cứng từ host (CPU) đến các bộ xử lý chuyên dụng như GPU.

Với khả năng tận dụng sức mạnh tính toán song song của các thiết bị, OpenCL được ứng dụng trong nhiều lĩnh vực như xử lý ảnh/video, machine learning, mô phỏng vật lý, tài chính và các ứng dụng tính toán hiệu năng cao (HPC). Framework này ban đầu được phát triển bởi Apple và hiện được duy trì bởi Khronos Group, với sự tham gia của các hãng lớn như AMD, Intel, NVIDIA, ARM,…

CUDA là gì?

CUDA (hay CUDA core) là một kiến trúc và nền tảng tính toán song song được NVIDIA phát triển. Nó cho phép lập trình viên viết các ứng dụng sử dụng sức mạnh xử lý song song của GPU (đơn vị xử lý đồ họa) để giải quyết các bài toán tính toán phức tạp một cách nhanh chóng và hiệu quả.

Với CUDA, các nhà phát triển có thể sử dụng các ngôn ngữ lập trình như C, C++ (và có hỗ trợ cho Python, Fortran, MATLAB, v.v.) để viết các hàm (gọi là kernel) chạy trực tiếp trên GPU. Điều này giúp offload các tác vụ tính toán nặng từ CPU sang GPU, vốn có hàng trăm đến hàng nghìn nhân xử lý nhỏ hoạt động song song, từ đó cải thiện đáng kể hiệu suất của ứng dụng, đặc biệt trong các lĩnh vực như đồ họa máy tính, khoa học dữ liệu, trí tuệ nhân tạo, mô phỏng vật lý và nhiều ứng dụng khác.

2. Cách thức hoạt động của GPGPU

Để hiểu cách GPGPU hoạt động, ta cần xem xét cả phần cứng (kiến trúc GPU) và phần mềm (các công cụ lập trình như CUDA hoặc OpenCL). Dưới đây là quy trình chi tiết:

2.1 Kiến trúc phần cứng của GPU

- Nhiều lõi xử lý (CUDA Cores, Stream Processors): GPU chứa hàng nghìn lõi nhỏ (ví dụ: NVIDIA RTX 4090 có hơn 16.000 CUDA Cores). Mỗi lõi tuy yếu hơn so với lõi CPU nhưng có thể thực hiện các phép tính đơn giản đồng thời.

- Bộ nhớ VRAM (Video RAM): GPU có bộ nhớ riêng (thường là GDDR) với băng thông rất cao, phù hợp để truy cập nhanh dữ liệu trong các tác vụ song song.

- SIMD Architecture (Single Instruction, Multiple Data): GPU hoạt động theo mô hình SIMD, nghĩa là một lệnh duy nhất được áp dụng cho nhiều tập dữ liệu cùng lúc. Điều này lý tưởng cho các tác vụ như nhân ma trận hoặc xử lý hình ảnh.

2.2 Lập trình GPGPU

Để sử dụng GPU cho tính toán mục đích chung, các lập trình viên cần công cụ đặc biệt:

- CUDA: Là nền tảng của NVIDIA, cho phép lập trình viên viết mã bằng C/C++ để điều khiển GPU. CUDA cung cấp các thư viện và API để phân bổ công việc cho các lõi GPU.

- OpenCL: Là một tiêu chuẩn mở, tương thích với nhiều loại GPU (NVIDIA, AMD, Intel), nhưng phức tạp hơn CUDA.

- Các thư viện khác: Như cuBLAS (cho đại số tuyến tính), cuDNN (cho học sâu), hoặc DirectCompute.

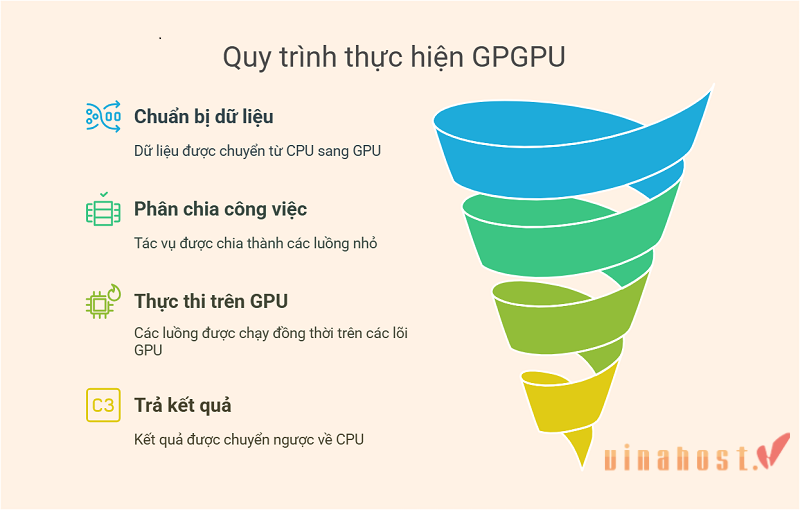

2.3 Quy trình thực thi

Dưới đây là các bước cơ bản khi một chương trình GPGPU được chạy:

- Chuẩn bị dữ liệu: Dữ liệu cần xử lý được truyền từ CPU (bộ nhớ RAM hệ thống) sang GPU (VRAM). Quá trình này gọi là “data transfer” và có thể gây độ trễ (latency).

- Phân chia công việc (Parallelization): Tác vụ được chia thành hàng nghìn “thread” nhỏ (luồng). Mỗi thread thực hiện một phần công việc độc lập. Ví dụ: trong nhân ma trận, mỗi thread tính một phần tử của ma trận kết quả.

- Thực thi trên GPU: Các thread được nhóm thành “blocks” hoặc “workgroups” và chạy đồng thời trên các lõi GPU. GPU sử dụng scheduler (bộ lập lịch) để quản lý hàng nghìn thread này.

- Trả kết quả: Sau khi tính toán xong, kết quả được chuyển ngược từ GPU về CPU để sử dụng hoặc lưu trữ.

3. Các thành phần chính của GPGPU

GPGPU không chỉ là phần cứng GPU mà còn bao gồm cả phần mềm và cách chúng tương tác với hệ thống máy tính. Dưới đây là các thành phần cốt lõi:

3.1 Phần cứng GPU

- Lõi xử lý (Processing Cores): Đây là “trái tim” của GPU, thường được gọi là CUDA Cores (trong GPU NVIDIA) hoặc Stream Processors (trong GPU AMD). Số lượng lõi rất lớn (hàng nghìn), mỗi lõi thực hiện các phép tính đơn giản song song. Ví dụ: NVIDIA RTX 4090 có 16.384 CUDA Cores, cho phép thực hiện hàng triệu phép tính cùng lúc.

- Bộ nhớ VRAM (Video RAM): Là bộ nhớ tốc độ cao (thường là GDDR6 hoặc HBM) được tích hợp trên GPU, chuyên lưu trữ dữ liệu cần xử lý. Băng thông của VRAM rất cao (có thể lên đến 1 TB/s), giúp truy cập dữ liệu nhanh chóng trong các tác vụ song song. Dung lượng VRAM quyết định lượng dữ liệu GPU có thể xử lý mà không cần chuyển qua lại với RAM hệ thống.

- Bộ điều khiển bộ nhớ (Memory Controller): Quản lý việc đọc/ghi dữ liệu giữa VRAM và các lõi xử lý, đảm bảo hiệu suất tối ưu.

- Bộ lập lịch (Scheduler): Điều phối hàng nghìn thread (luồng) để chạy trên các lõi xử lý. Scheduler đảm bảo các thread được phân bổ hiệu quả và giảm thiểu thời gian chờ.

- Đơn vị tính toán đặc biệt (Special Function Units – SFUs): Xử lý các phép toán phức tạp như hàm lượng giác (sin, cos) hoặc căn bậc hai, hỗ trợ các lõi chính trong một số tác vụ.

3.2 Giao diện giữa CPU và GPU

- Bus giao tiếp (PCIe – Peripheral Component Interconnect Express): Kết nối GPU với CPU qua bo mạch chủ, cho phép truyền dữ liệu giữa RAM hệ thống và VRAM. Tốc độ của PCIe (ví dụ: PCIe 4.0 hoặc 5.0) ảnh hưởng đến độ trễ khi chuyển dữ liệu.

- Driver GPU: Là phần mềm trung gian do nhà sản xuất cung cấp (NVIDIA, AMD), giúp hệ điều hành và ứng dụng giao tiếp với GPU.

3.3 Phần mềm lập trình

- CUDA (Compute Unified Device Architecture): Nền tảng của NVIDIA, cung cấp API và thư viện để lập trình viên viết mã C/C++ điều khiển GPU. CUDA bao gồm các khái niệm như kernel (hàm chạy trên GPU), thread, block, và grid.

- OpenCL (Open Computing Language): Tiêu chuẩn mở, hỗ trợ đa nền tảng (NVIDIA, AMD, Intel). Tuy linh hoạt hơn CUDA, OpenCL phức tạp hơn và ít tối ưu hóa cho phần cứng cụ thể.

- Thư viện hỗ trợ: Ví dụ: cuBLAS, cuFFT, cuDNN. Các thư viện này cung cấp các hàm đã tối ưu để giảm công sức lập trình.

- Shader Language (như GLSL): Ban đầu dùng cho đồ họa, nhưng trong những ngày đầu của GPGPU, lập trình viên đã “lách” bằng cách dùng shader để thực hiện tính toán phi đồ họa.

3.4 Kiến trúc song song và hệ thống làm mát

- Mô hình SIMD (Single Instruction, Multiple Data): Một lệnh được áp dụng đồng thời cho nhiều tập dữ liệu. Điều này là nền tảng cho khả năng xử lý song song của GPU.

- Thread Hierarchy (Cấu trúc luồng): Trong CUDA, các thread được tổ chức thành block, và các block tạo thành grid. Mỗi thread thực hiện một phần nhỏ của tác vụ tổng thể.

- GPU xử lý khối lượng tính toán lớn nên sinh nhiệt rất cao, nên cần quạt, tản nhiệt nước, hoặc các giải pháp làm mát tiên tiến để duy trì hiệu suất.

4. Ưu và nhược điểm của GPGPU

4.1 Ưu điểm của GPGPU

- Hiệu suất vượt trội trong tính toán song song: Với hàng nghìn lõi, GPU có thể xử lý hàng triệu phép tính cùng lúc. Ví dụ: huấn luyện mạng nơ-ron trên GPU nhanh hơn CPU hàng chục hoặc hàng trăm lần (tùy quy mô).

- Ứng dụng thực tế: Một mô hình học sâu như BERT có thể mất hàng tuần trên CPU, nhưng chỉ vài giờ trên GPU cao cấp.

- Hiệu quả năng lượng trong khối lượng tính toán lớn: Mặc dù GPU tiêu thụ nhiều điện hơn CPU khi hoạt động tối đa, nhưng với cùng một khối lượng công việc, GPU hoàn thành nhanh hơn, dẫn đến tổng năng lượng tiêu thụ trên mỗi phép tính thấp hơn.

- Ví dụ: Một GPU NVIDIA A100 tiêu thụ 400W nhưng có thể thực hiện 19.5 teraflops (FP32), trong khi CPU cao cấp như Intel Xeon khó đạt được hiệu suất tương tự với mức tiêu thụ tương đương.

- Khả năng mở rộng: Nhiều GPU có thể được kết hợp (multi-GPU setup) qua NVLink hoặc PCIe để tăng hiệu suất. Điều này phổ biến trong các siêu máy tính hoặc trung tâm dữ liệu.

- Hỗ trợ mạnh mẽ từ ngành công nghiệp:

- Các công ty như NVIDIA và AMD đầu tư lớn vào GPGPU, cung cấp phần cứng (như dòng NVIDIA Tesla, AMD Instinct) và phần mềm (CUDA, ROCm) tối ưu hóa cho tính toán mục đích chung.

- Các framework AI như TensorFlow, PyTorch đều tích hợp sẵn hỗ trợ GPU.

- Ứng dụng đa dạng: Từ học máy, mô phỏng vật lý, khai thác tiền điện tử, đến xử lý tín hiệu số, GPGPU có thể áp dụng trong nhiều lĩnh vực đòi hỏi tính toán dữ liệu lớn.

4.2 Nhược điểm của GPGPU

- Không hiệu quả với tác vụ tuần tự: GPU được thiết kế cho xử lý song song, nên các tác vụ yêu cầu xử lý tuần tự (sequential tasks) hoặc phụ thuộc lẫn nhau (data dependency) chạy chậm hơn trên GPU so với CPU.

- Ví dụ: Một thuật toán như tìm kiếm nhị phân (binary search) không thể tận dụng được sức mạnh của GPU.

- Độ trễ truyền dữ liệu (Data Transfer Latency): Việc chuyển dữ liệu giữa RAM (CPU) và VRAM (GPU) qua PCIe tốn thời gian và có thể làm giảm hiệu suất tổng thể, đặc biệt trong các ứng dụng yêu cầu trao đổi dữ liệu liên tục.

- Ví dụ: Nếu dữ liệu chỉ được xử lý một lần và phải chuyển qua lại, tổng thời gian có thể lâu hơn so với chạy trực tiếp trên CPU.

- Lập trình phức tạp: Viết mã cho GPGPU đòi hỏi hiểu biết về kiến trúc song song, quản lý thread, và tối ưu hóa bộ nhớ. CUDA và OpenCL có đường cong học tập (learning curve) dốc hơn so với lập trình CPU thông thường.

- Ví dụ: Một lập trình viên phải tự tay chia nhỏ tác vụ thành các thread và đảm bảo không có xung đột bộ nhớ (memory race condition).

- Chi phí cao: GPU cao cấp (như NVIDIA A100, RTX 4090) đắt hơn nhiều so với CPU thông thường. Ngoài ra, cần hệ thống làm mát và nguồn điện mạnh, tăng chi phí vận hành.

- Ví dụ: Một GPU RTX 4090 có giá khoảng $1.500, trong khi CPU tương đương như AMD Ryzen 9 7950X chỉ khoảng $600.

- Hạn chế về bộ nhớ: VRAM trên GPU thường nhỏ hơn RAM hệ thống (ví dụ: 24GB trên RTX 4090 so với 128GB RAM trên máy trạm). Nếu dữ liệu vượt quá dung lượng VRAM, hiệu suất sẽ giảm do phải phân lô (batching) hoặc chuyển dữ liệu qua lại.

- Phụ thuộc vào phần mềm hỗ trợ: Không phải ứng dụng nào cũng hỗ trợ GPGPU. Nếu phần mềm không được tối ưu cho GPU, người dùng không thể tận dụng sức mạnh của nó.

So sánh trực quan giữa ưu và nhược điểm

| Tiêu chí | Ưu điểm | Nhược điểm |

| Hiệu suất | Rất cao với tác vụ song song | Kém với tác vụ tuần tự |

| Năng lượng | Hiệu quả cho khối lượng lớn | Tiêu thụ cao khi idle hoặc tải thấp |

| Lập trình | Hỗ trợ mạnh từ CUDA, thư viện | Phức tạp, đòi hỏi kỹ năng cao |

| Chi phí | Đáng giá cho ứng dụng lớn | Đắt đỏ, cần đầu tư ban đầu lớn |

| Ứng dụng | Linh hoạt, đa lĩnh vực | Hạn chế nếu phần mềm không tương thích |

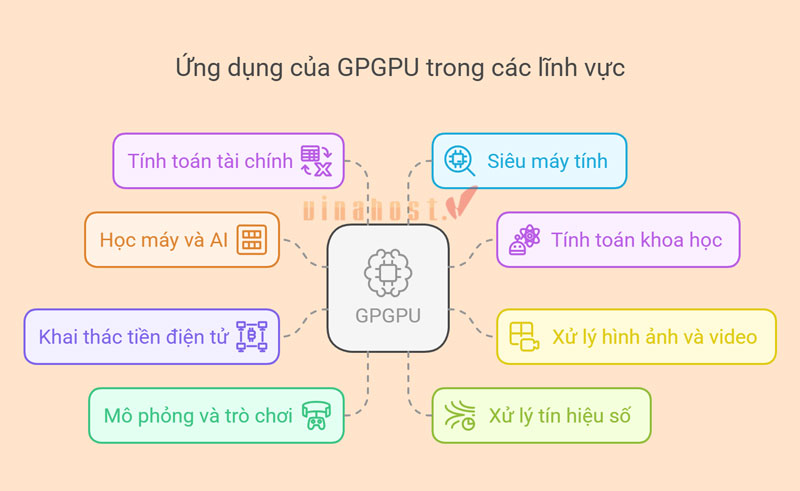

5. Tính ứng dụng của GPGPU

GPGPU (General-Purpose Computing on Graphics Processing Units) tận dụng sức mạnh song song của GPU để xử lý các tác vụ không chỉ liên quan đến đồ họa mà còn mở rộng sang nhiều lĩnh vực khác. Dưới đây là các ứng dụng chính:

- Học máy và trí tuệ nhân tạo (AI): GPGPU là nền tảng cho việc huấn luyện và suy luận (inference) các mô hình học sâu (deep learning) như mạng nơ-ron sâu (DNN), CNN, và Transformer.

- Ví dụ: Huấn luyện mô hình ngôn ngữ lớn (như GPT) trên các GPU NVIDIA A100 hoặc H100 nhanh hơn hàng chục lần so với CPU.

- Tính toán khoa học: Mô phỏng vật lý (molecular dynamics), dự báo thời tiết, và tính toán khí động lực học (CFD – Computational Fluid Dynamics) đều cần xử lý số lượng lớn phép tính song song.

- Ví dụ: Các nhà nghiên cứu sử dụng GPGPU để mô phỏng sự tương tác của protein trong y học.

- Xử lý hình ảnh và video: Áp dụng bộ lọc thời gian thực, mã hóa/giải mã video (H.264, H.265), và chỉnh sửa ảnh/video chuyên nghiệp.

- Ví dụ: Phần mềm như Adobe Premiere Pro dùng GPGPU để tăng tốc render video.

- Khai thác tiền điện tử (Cryptocurrency Mining): Các thuật toán như SHA-256 (Bitcoin) hoặc Ethash (Ethereum trước khi chuyển sang PoS) tận dụng khả năng tính toán song song của GPU để giải các bài toán mật mã.

- Ví dụ: Các dàn máy đào (mining rigs) thường sử dụng nhiều GPU NVIDIA hoặc AMD.

- Mô phỏng và trò chơi: Tính toán vật lý thời gian thực (real-time physics) trong game, như va chạm, chất lỏng, hoặc hiệu ứng hạt (particle effects). Tham khảo ngay dịch vụ VPS GPU của VinaHost

- Ví dụ: Công nghệ PhysX của NVIDIA chạy trên GPU để mô phỏng vật lý trong trò chơi.

- Xử lý tín hiệu số (Digital Signal Processing – DSP): Phân tích âm thanh, radar, hoặc xử lý dữ liệu từ cảm biến trong y tế (như MRI, CT scan).

- Ví dụ: GPGPU được dùng để tái tạo hình ảnh từ dữ liệu y học nhanh chóng.

- Tính toán tài chính: Mô phỏng rủi ro (Monte Carlo simulations), định giá quyền chọn (option pricing), và phân tích dữ liệu thị trường.

- Ví dụ: Các quỹ đầu tư dùng GPGPU để xử lý khối lượng dữ liệu giao dịch lớn.

- Siêu máy tính (High-Performance Computing – HPC): GPGPU là thành phần chính trong các siêu máy tính như Summit (IBM) hay Frontier, giúp đạt hiệu suất tính toán hàng exaflop.

- Ví dụ: Nghiên cứu biến đổi khí hậu hoặc mô phỏng vũ trụ.

6. So sánh giữa GPGPU, GPU, CPU và VPU

Để so sánh, ta cần hiểu rằng GPGPU không phải là một loại phần cứng riêng biệt mà là cách sử dụng GPU cho mục đích tính toán chung. Dưới đây là bảng phân tích chi tiết giữa GPU (truyền thống), GPGPU (GPU dùng cho tính toán chung), CPU, và VPU (Vision Processing Unit) dựa trên nhiều tiêu chí:

6.1 Định nghĩa

- CPU (Central Processing Unit): Bộ xử lý trung tâm, được thiết kế cho các tác vụ đa năng, xử lý tuần tự và quản lý hệ thống.

- GPU (Graphics Processing Unit): Bộ xử lý đồ họa, tối ưu cho render hình ảnh, video, và các tác vụ đồ họa.

- GPGPU: GPU được lập trình lại (qua CUDA, OpenCL) để thực hiện tính toán mục đích chung, không chỉ giới hạn ở đồ họa.

- VPU (Vision Processing Unit): Bộ xử lý chuyên dụng cho các tác vụ thị giác (computer vision), thường dùng trong AI và xử lý hình ảnh.

6.2 Kiến trúc

| Tiêu chí | CPU | GPU | GPGPU | VPU |

| Số lõi | Ít (4-64 lõi) | Nhiều (hàng nghìn lõi) | Nhiều (hàng nghìn lõi) | Ít, nhưng chuyên dụng |

| Thiết kế lõi | Mạnh, đa năng (complex cores) | Nhỏ, đơn giản (SIMD) | Nhỏ, đơn giản (SIMD) | Tối ưu cho ma trận và vector |

| Bộ nhớ | Cache lớn, RAM hệ thống | VRAM băng thông cao | VRAM băng thông cao | Bộ nhớ tích hợp nhỏ |

| Mô hình xử lý | MIMD (đa lệnh, đa dữ liệu) | SIMD (một lệnh, đa dữ liệu) | SIMD | SIMD hoặc chuyên biệt |

6.3 Hiệu suất

- CPU: Tốt cho tác vụ tuần tự, quản lý hệ thống, và các phép tính phức tạp với độ trễ thấp. Hiệu suất tính toán thô (FLOPS) thấp hơn GPU (ví dụ: Intel Core i9-13900K ~1-2 TFLOPS).

- GPU: Xuất sắc trong render đồ họa và các tác vụ song song liên quan đến hình ảnh (ví dụ: NVIDIA RTX 4090 ~80 TFLOPS cho đồ họa).

- GPGPU: Tối ưu cho tính toán song song phi đồ họa như học máy, mô phỏng (cùng phần cứng với GPU nhưng được lập trình khác).

- VPU: Hiệu suất cao trong các tác vụ thị giác như nhận diện đối tượng, nhưng kém linh hoạt hơn (ví dụ: Intel Movidius Myriad X ~4 TOPS cho AI).

6.4 Ứng dụng

| Tiêu chí | CPU | GPU | GPGPU | VPU |

| Chính | Hệ điều hành, tác vụ đa năng | Đồ họa, render game | Học máy, mô phỏng khoa học | Thị giác máy, AI nhúng |

| Ví dụ | Chạy phần mềm, server | Chơi game, thiết kế 3D | Huấn luyện AI, mining | Camera thông minh, drone |

6.5 Lập trình

- CPU: Dễ lập trình (C, Python, Java), không cần kiến thức song song.

- GPU: Dùng shader (GLSL, HLSL) cho đồ họa, khó hơn CPU.

- GPGPU: Phức tạp (CUDA, OpenCL), đòi hỏi hiểu về quản lý thread.

- VPU: Thường dùng framework (OpenVINO, TensorFlow Lite), ít cần lập trình cấp thấp.

6.6 Ưu điểm và nhược điểm

| Ưu điểm | Nhược điểm | |

| CPU |

|

|

| GPU |

|

|

| GPGPU |

|

|

| VPU |

|

|

6.7 Ví dụ phần cứng

- CPU: Intel Core i9, AMD Ryzen 9.

- GPU/GPGPU: NVIDIA RTX 4090, AMD Radeon RX 7900 XTX.

- VPU: Intel Movidius, Google Coral.

Tóm tắt so sánh

| Tiêu chí | CPU | GPU | GPGPU | VPU |

| Mục đích | Đa năng | Đồ họa | Tính toán chung | Thị giác/AI nhúng |

| Hiệu suất song song | Thấp | Cao (đồ họa) | Rất cao | Trung bình |

| Độ linh hoạt | Cao | Trung bình | Trung bình | Thấp |

| Tiêu thụ năng lượng | Trung bình | Cao | Cao | Thấp |

7. Tương lai của GPGPU

GPGPU (General-Purpose computing on Graphics Processing Units) đã trở thành một xu hướng quan trọng trong lĩnh vực tính toán hiệu năng cao và trí tuệ nhân tạo. Tương lai của GPGPU được dự báo sẽ tiếp tục phát triển mạnh mẽ, đóng vai trò quan trọng trong nhiều lĩnh vực. Dưới đây là một số khía cạnh chi tiết về hướng đi tương lai của GPGPU:

7.1 Sự Phát Triển Của Kiến Trúc GPU

- Tiến Bộ Về Kiến Trúc: Các nhà sản xuất như NVIDIA, AMD và Intel đang không ngừng cải tiến kiến trúc GPU để tăng cường hiệu năng tính toán, giảm tiêu thụ điện năng và tối ưu hóa việc xử lý song song. Công nghệ mới như Tensor Cores của NVIDIA đã được thiết kế đặc biệt để tối ưu cho các ứng dụng AI và deep learning.

- Tích Hợp và Đồng Bộ Hóa: Xu hướng tích hợp CPU và GPU trên cùng một chip (APU) sẽ giúp giảm độ trễ trong truyền dữ liệu và tăng hiệu suất xử lý. Điều này đặc biệt hữu ích trong các hệ thống nhúng và điện toán biên (edge computing).

7.2 Ứng Dụng Mới và Tiềm Năng Trong Trí Tuệ Nhân Tạo

- Đào Tạo Mô Hình Sâu: Sự tăng trưởng của deep learning và các mô hình học sâu đòi hỏi một lượng tính toán khổng lồ, và GPU đã chứng tỏ được vai trò không thể thiếu trong việc huấn luyện các mô hình này. Trong tương lai, sự phát triển của các kiến trúc GPU sẽ càng thúc đẩy khả năng đào tạo mô hình lớn, phức tạp hơn và tiết kiệm thời gian huấn luyện.

- Ứng Dụng Trong Xử Lý Hình Ảnh và Video: Ngoài AI, GPGPU còn được ứng dụng mạnh mẽ trong xử lý hình ảnh, video, mô phỏng và đồ họa. Các ứng dụng này không chỉ dừng lại ở giải trí mà còn được mở rộng trong y tế, khoa học vật liệu và mô phỏng hiện tượng tự nhiên.

7.3 Môi Trường Điện Toán Đám Mây Và Tính Toán Phân Tán

- Dịch Vụ Đám Mây GPU: Các nền tảng điện toán đám mây như AWS, Google Cloud hay Microsoft Azure đã và đang cung cấp các dịch vụ GPU dưới dạng thuê bao, giúp các doanh nghiệp và nhà nghiên cứu có thể dễ dàng tiếp cận sức mạnh tính toán cao mà không cần đầu tư hạ tầng riêng.

- Tính Toán Phân Tán: GPGPU không chỉ giới hạn trong một máy chủ mà còn được áp dụng trong các hệ thống tính toán phân tán, mở ra khả năng xử lý dữ liệu lớn và mô phỏng phức tạp theo quy mô lớn hơn.

7.4 Thách Thức Và Giải Pháp

- Tiêu Thụ Năng Lượng: Mặc dù GPU mang lại hiệu năng vượt trội, nhưng tiêu thụ điện năng vẫn là một thách thức lớn. Các nhà nghiên cứu đang nỗ lực cải tiến công nghệ để tăng hiệu suất năng lượng, giúp giảm chi phí vận hành và bảo vệ môi trường.

- Lập Trình và Phát Triển Phần Mềm: Việc phát triển phần mềm hiệu quả trên GPU đòi hỏi kiến thức chuyên sâu về lập trình song song. Các công cụ và framework như CUDA, OpenCL và các thư viện học sâu đang được cải tiến để hỗ trợ việc phát triển dễ dàng hơn và mở rộng cộng đồng lập trình viên.

- Bảo Mật và Ổn Định: Khi các ứng dụng quan trọng và dữ liệu nhạy cảm được xử lý trên GPU, việc đảm bảo bảo mật và ổn định của hệ thống trở nên cấp thiết. Các giải pháp bảo mật mới và các chuẩn mực kiểm định sẽ được phát triển song song với sự gia tăng của các ứng dụng GPGPU.

7.5 Dự Báo Tương Lai

- Tăng Cường Ứng Dụng Trong Công Nghiệp: Với sự bùng nổ của dữ liệu và nhu cầu tính toán mạnh mẽ, GPGPU sẽ được ứng dụng ngày càng rộng rãi trong các ngành công nghiệp như tự động hóa, y tế, ô tô (xe tự lái), và nghiên cứu khoa học.

- Sự Hợp Nhất Với Các Công Nghệ Mới: GPGPU có thể sẽ được tích hợp mạnh mẽ với các công nghệ như trí tuệ nhân tạo, machine learning, và Internet of Things (IoT), tạo ra các hệ thống thông minh và tự động hóa có khả năng xử lý thời gian thực.

- Đổi Mới Trong Nghiên Cứu Khoa Học: Với sức mạnh tính toán cao, các mô hình mô phỏng phức tạp, từ khí hậu đến vật lý hạt nhân, sẽ được thực hiện với độ chính xác cao hơn, mở ra những cơ hội nghiên cứu mới và những hiểu biết sâu sắc hơn về thế giới tự nhiên.

Xem thêm: NPU là gì? | So sánh sự khác nhau giữa NPU, CPU, GPU

8. Tổng kết

GPGPU là một công nghệ quan trọng giúp tận dụng sức mạnh của GPU để thực hiện các nhiệm vụ tính toán tổng hợp. Với khả năng xử lý song song mạnh mẽ, GPGPU đã trở thành công cụ không thể thiếu trong các lĩnh vực như AI, khoa học dữ liệu, mô phỏng vật lý và xử lý video. Tuy nhiên, để tận dụng tối đa GPGPU, người sử dụng cần am hiểu về phần cứng và kiến trúc song song của gpgpu. Mong rằng bài viết này sẽ cung cấp thông tin cần thiết để giúp bạn hiểu rõ hơn về gpgpu là gì cũng như lợi ích mà nó đem lại.

Mời bạn truy cập vào blog của VinaHost TẠI ĐÂY để theo dõi thêm nhiều bài viết mới. Hoặc bạn muốn được tư vấn thêm về dịch vụ VPS giá rẻ, VPS Windows, VPS MMO, VPS NVMe, VPS Forex, VPS n8n thì có thể liên hệ với chúng tôi qua:

- Email: support@vinahost.vn

- Hotline: 1900 6046

- Livechat: https://livechat.vinahost.vn/chat.php

Xem thêm một số bài viết khác:

iGPU là gì? | Tổng quan kiến thức về iGPU

dGPU là gì? | Tổng quan kiến thức về dGPU

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文