Khi mà dữ liệu ngày càng trở nên lớn mạnh và phức tạp, Apache Spark xuất hiện như một công cụ đắc lực trong việc xử lý và phân tích dữ liệu. Được biết đến với tốc độ xử lý nhanh, khả năng mở rộng linh hoạt và hỗ trợ đa ngôn ngữ, Spark không chỉ là một framework mà còn là một bước đột phá trong lĩnh vực big data. Hãy cùng VinaHost tìm hiểu về Apache Spark là gì và khám phá cách nó đã thay đổi cách chúng ta nghĩ về xử lý dữ liệu.

1. Apache Spark là gì?

Apache Spark là một framework tính toán phân tán, mã nguồn mở, được thiết kế để xử lý dữ liệu lớn một cách nhanh chóng và hiệu quả. Nó cung cấp một giao diện lập trình đơn giản để xử lý các tập dữ liệu khổng lồ trên các cụm máy tính một cách song song.

Điểm đột phá lớn nhất và cũng là “vũ khí bí mật” của Spark chính là khả năng xử lý dữ liệu trong bộ nhớ (in-memory processing). Thay vì phải liên tục đọc/ghi dữ liệu xuống ổ đĩa cứng chậm chạp như các công nghệ tiền nhiệm, Spark cố gắng giữ càng nhiều dữ liệu càng tốt trên RAM, giúp tốc độ xử lý được tăng lên gấp hàng chục, thậm chí hàng trăm lần.

Một trong những đặc điểm độc đáo của Apache Spark là khả năng xử lý dữ liệu theo thời gian thực thông qua Spark Streaming. Khả năng này cho phép Spark nhận dữ liệu từ nhiều nguồn đồng thời và tiếp tục xử lý ngay lập tức, mở rộng khả năng ứng dụng của nó đến các lĩnh vực yêu cầu xử lý dữ liệu nhanh chóng và linh hoạt.

Đặc biệt, Apache Spark không phụ thuộc vào hệ thống file cụ thể, thay vào đó sử dụng nhiều hệ thống file như HDFS, Cassandra, S3, và hỗ trợ nhiều định dạng file khác nhau như text, csv, json. Điều này mang lại sự linh hoạt, dễ dàng tích hợp vào môi trường dữ liệu đa dạng. Apache Spark, với tốc độ và tính linh hoạt của mình, không chỉ là một công cụ, mà là động lực đằng sau sự đổi mới và phát triển trong lĩnh vực xử lý big data.

Xem thêm: [Bật Mí] Apache là gì? | Tổng hợp kiến thức [A-Z] về Apache

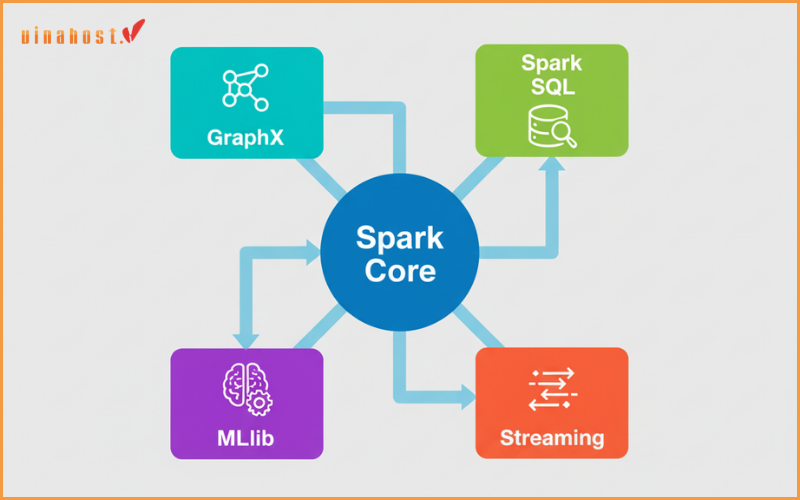

2. Những thành phần của Apache Spark

Spark không chỉ là một công cụ, nó là cả một hệ sinh thái mạnh mẽ với các thành phần được tích hợp liền mạch:

2.1 Spark Core

Spark Core đóng vai trò quan trọng, là nền tảng cốt lõi của Apache Spark, chịu trách nhiệm đối với việc thực hiện và điều phối công việc tính toán, cũng như xử lý dữ liệu trong bộ nhớ (In-memory computing). Điều này lý giải vì sao Apache Spark trở thành một trong những công cụ xử lý dữ liệu hàng đầu trong thế giới big data.

Spark Core không chỉ giới hạn ở việc xử lý dữ liệu mà còn đóng vai trò như một trung tâm điều khiển cho các thành phần khác của Spark. Để bất kỳ thành phần nào khác của Spark muốn khởi chạy và hoạt động mạnh mẽ, chúng đều phải thông qua Spark Core. Điều này tạo ra sự nhất quán và tính tương thích cao giữa các thành phần, giúp tối ưu hóa quá trình phân tán và điều khiển tài nguyên.

Khả năng thực hiện tính toán và xử lý trong bộ nhớ của Spark Core là một đặc điểm quan trọng, mang lại hiệu suất vượt trội so với các phương pháp truyền thống. Việc duy trì dữ liệu trong bộ nhớ giúp giảm thời gian truy cập và tăng cường khả năng xử lý cùng lúc. Đồng thời, Spark Core có khả năng tham chiếu đến dữ liệu được lưu trữ tại các hệ thống lưu trữ bên ngoài, tạo ra sự linh hoạt và tích hợp mạnh mẽ trong quá trình làm việc với các nguồn dữ liệu đa dạng.

Trong tầm nhìn chiến lược của Apache Spark, Spark Core là nền tảng mạnh mẽ đưa ra tiền đề cho sự thành công của toàn bộ hệ sinh thái Spark, làm nổi bật tầm quan trọng của việc có một cơ sở cốt lõi vững chắc để Apache Spark tiếp tục phát triển.

2.2 Spark SQL

Apache Spark SQL có khả năng hỗ trợ không chỉ cho kiểu dữ liệu có cấu trúc mà còn cho dữ liệu nửa cấu trúc (semi-structured data). Spark SQL giới thiệu một kiểu trừu tượng mới, SchemaRDD, làm nền tảng trong quá trình làm việc linh hoạt và hiệu quả với cả dữ liệu có cấu trúc và nửa cấu trúc.

Dữ liệu nửa cấu trúc thường xuất hiện trong thế giới thực khi chúng ta có dữ liệu có cấu trúc nhưng không đồng nhất, với cấu trúc của dữ liệu phụ thuộc vào nội dung cụ thể của dữ liệu đó. Spark SQL hiểu và đáp ứng tốt đối với những thách thức này, mang lại khả năng xử lý mạnh mẽ và linh hoạt cho các kịch bản dữ liệu đa dạng.

Spark SQL không chỉ giới thiệu một kiểu trừu tượng mới mà còn cung cấp một ngôn ngữ DSL (Domain-specific language) cho phép thực hiện các thao tác trên DataFrames bằng Scala, Java, hoặc Python. Điều này tạo ra một cách tiếp cận dễ dàng cho việc xử lý và truy vấn dữ liệu. Đồng thời, Spark SQL cũng hỗ trợ ngôn ngữ SQL thông qua giao diện command-line và ODBC/JDBC server, giúp nâng cao sự thuận tiện và linh hoạt trong việc tương tác với dữ liệu.

Với Spark SQL, Apache Spark không chỉ là một công cụ xử lý dữ liệu mà còn là một nền tảng mạnh mẽ và đa nhiệm, đáp ứng mọi nhu cầu từ dữ liệu có cấu trúc đến dữ liệu nửa cấu trúc, và từ ngôn ngữ lập trình đến SQL truyền thống.

2.3 Spark Streaming

Apache Spark Streaming là một thành phần quan trọng trong hệ sinh thái Spark, giúp xử lý dữ liệu theo thời gian thực. Spark Streaming không nhìn nhận dữ liệu stream như là các sự kiện riêng lẻ, mà thay vào đó, nó áp dụng khái niệm của mini-batches, tức là xem xét dữ liệu dưới dạng các đợt nhỏ.

Quyết định này mang lại một lợi ích quan trọng: khả năng tái sử dụng đoạn mã được viết cho xử lý batch vào trong quá trình xử lý stream. Điều này giúp tối ưu hóa quá trình phát triển lambda architecture, làm cho việc tích hợp và duy trì mã nguồn trở nên dễ dàng hơn.

Tuy nhiên, nhược điểm của cách tiếp cận này là độ trễ trong xử lý dữ liệu, bằng với thời gian giữa các mini-batches. Điều này tạo ra một khoảng thời gian nhất định trước khi dữ liệu stream được xử lý và phản hồi, gây ra độ trễ trong quá trình phân tích dữ liệu thời gian thực.

Nhưng đối với nhiều chuyên gia, Spark Streaming không thể coi là công cụ xử lý streaming chân thực, như các đối thủ Storm hay Flink, vì nó không đáp ứng được yêu cầu về độ trễ thấp trong các ứng dụng cần xử lý sự kiện ngay lập tức. Mặc dù có nhược điểm về độ trễ, Spark Streaming vẫn tiếp tục giữ vững vị thế của mình trong việc kết hợp xử lý batch và xử lý stream trong một môi trường đồng nhất.

2.4 Spark MLlib (Machine Learning Library)

MLlib (Machine Learning Library) là hạt nhân của hệ sinh thái Apache Spark, đánh dấu một bước tiến đột phá trong lĩnh vực máy học phân tán. Được xây dựng trên kiến trúc phân tán có sử dụng bộ nhớ, MLlib mang đến hiệu suất và tính linh hoạt không ngờ.

So với phiên bản chạy trên Hadoop, MLlib thể hiện sức mạnh vượt trội, nhanh hơn tới 9 lần theo các so sánh benchmark. Điều này không chỉ là một ưu điểm làm tăng hiệu suất, mà còn thể hiện sự hiện đại và tiên tiến trong việc xử lý dữ liệu lớn trên các môi trường phân tán.

Kiến trúc phân tán của MLlib giúp tận dụng tối đa nguồn lực có sẵn, đồng thời giảm thiểu độ trễ trong quá trình xử lý. Đây là điều quan trọng trong học máy, nơi mà việc xử lý và đào tạo mô hình trên tập dữ liệu lớn đòi hỏi sự hiệu quả cao và khả năng mở rộng linh hoạt.

MLlib không chỉ đơn thuần là một thư viện học máy mạnh mẽ, mà còn là một phần quan trọng trong việc đưa Spark lên tầm cao mới trong lĩnh vực big data và xử lý dữ liệu lớn. Sự nhanh chóng và hiệu quả của MLlib mở ra không gian cho việc triển khai ứng dụng máy học quy mô lớn và phức tạp, đưa Spark và MLlib trở thành lựa chọn hàng đầu trong cộng đồng nghiên cứu.

2.5 GraphX

GrapX là một nền tảng xử lý đồ thị đặt trên Apache Spark, đưa ra giải pháp mạnh mẽ cho việc xử lý và phân tích dữ liệu đồ thị quy mô lớn. Được tích hợp vào Spark, GrapX không chỉ thừa hưởng sức mạnh và hiệu suất của Spark mà còn mang đến một bộ công cụ mạnh mẽ thông qua các API được thiết kế đặc biệt để thực hiện tính toán trong đồ thị.

Một điểm nổi bật của GrapX là việc sử dụng Pregel API, một công cụ quen thuộc và mạnh mẽ trong lĩnh vực xử lý đồ thị. Pregel API giúp mô tả các tính toán phức tạp trong đồ thị một cách linh hoạt và hiệu quả, tạo điều kiện thuận lợi cho việc phân tích các mô hình đồ thị phức tạp.

GrapX không chỉ là một công cụ xử lý đồ thị thông thường mà còn mở rộng khả năng tích hợp và mở rộng, nhờ vào sự linh hoạt của Apache Spark. Điều này giúp nó trở thành lựa chọn hàng đầu cho các ứng dụng yêu cầu xử lý đồ thị quy mô lớn, từ phân tích mạng xã hội đến phân loại các đối tượng trong các hệ thống phức tạp.

Với GrapX, Spark không chỉ là một nền tảng xử lý dữ liệu lớn, mà còn là một giải pháp đầy tham vọng cho việc xử lý dữ liệu đồ thị phức tạp, mở ra những cơ hội mới và tiềm năng lớn trong các lĩnh vực nghiên cứu, khoa học dữ liệu, và các ứng dụng đòi hỏi sự hiểu biết sâu sắc về mối quan hệ và cấu trúc của dữ liệu đồ thị.

Xem thêm: Apache Tomcat là gì? | Cách cài đặt Apache Tomcat chi tiết

3. Kiến trúc của Apache Spark

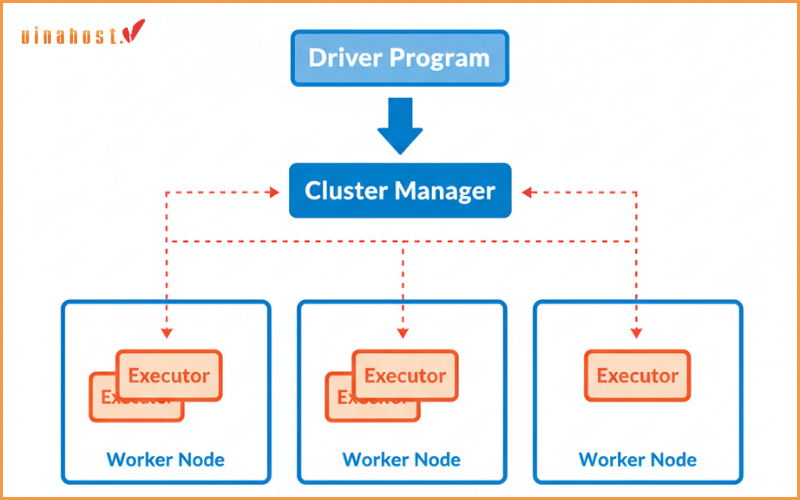

Spark hoạt động theo mô hình chủ-tớ (master-worker).

Driver Program (Chương trình Điều khiển – Giám đốc): Đây là “bộ não” của ứng dụng Spark, nơi bạn viết code. Nó chứa đối tượng SparkContext, chịu trách nhiệm điều phối toàn bộ công việc.

Cluster Manager (Trình quản lý Cụm – Quản đốc): Đây là người “quản lý tài nguyên”, chịu trách nhiệm phân bổ công việc cho các máy công nhân. Spark rất linh hoạt và có thể làm việc với nhiều Cluster Manager khác nhau như:

Standalone (trình quản lý tích hợp sẵn của Spark).

Apache Mesos.

Hadoop YARN (phổ biến nhất khi chạy Spark trên hệ sinh thái Hadoop).

Kubernetes (ngày càng trở nên phổ biến).

Worker Node (Nút Công nhân): Là các máy tính vật lý trong cụm.

Executor (Trình thực thi – Công nhân): Là một tiến trình chạy trên Worker Node, chịu trách nhiệm thực thi các tác vụ (task) mà Driver Program giao phó.

4. Cách thức hoạt động của Apache Spark

Apache Spark, một framework mạnh mẽ cho xử lý dữ liệu lớn và phức tạp, hoạt động theo cách đặc biệt, mang lại hiệu suất và linh hoạt đáng kể trong xử lý dữ liệu.

Đầu tiên và quan trọng nhất là Spark hoạt động dựa trên kiến trúc phân tán. Dữ liệu được chia thành các phần nhỏ và xử lý đồng thời trên nhiều máy tính, tận dụng toàn bộ khả năng lực của cluster để tăng hiệu suất.

Spark sử dụng khái niệm Resilient Distributed Datasets (RDDs), cấu trúc dữ liệu bất biến và phân tán, làm trung tâm của quá trình xử lý. RDDs cho phép các hoạt động xử lý dữ liệu được thực hiện một cách an toàn và đồng nhất trên nhiều máy tính, giảm thiểu các lỗi và đảm bảo tính nhất quán.

Spark cũng tận dụng việc xử lý dữ liệu trong bộ nhớ (in-memory computing), giúp tăng tốc quá trình tính toán bằng cách lưu trữ dữ liệu trung gian trong bộ nhớ thay vì đọc và ghi từ và đến ổ đĩa. Điều này đặt ra một sự thay đổi lớn so với các hệ thống truyền thống, làm tăng đáng kể hiệu suất của Spark.

Hệ sinh thái Spark bao gồm các thành phần như Spark SQL, MLlib (Machine Learning Library), và Spark Streaming, mỗi thành phần phục vụ một mục tiêu cụ thể trong việc xử lý dữ liệu và phân tích.

Cách thức hoạt động của Apache Spark là sự kết hợp chặt chẽ giữa kiến trúc phân tán, RDDs, xử lý dữ liệu trong bộ nhớ và một hệ sinh thái đa dạng, tạo nên một framework mạnh mẽ và linh hoạt, đáp ứng hiệu quả và nhanh chóng đối với các yêu cầu xử lý dữ liệu lớn và phức tạp.

Xem thêm: NGINX là gì? | Cách Cài đặt, Cấu hình & Sử dụng NGINX

5. Lý do nên sử dụng Apache Spark?

Apache Spark, là một trong những framework hàng đầu cho xử lý dữ liệu lớn, được ưa chuộng vì nhiều lý do quan trọng, mang lại lợi ích đáng kể cho các tổ chức và nhà phân tích dữ liệu.

- Hiệu suất là một yếu tố quyết định khiến Apache Spark nổi bật. Sự kết hợp giữa kiến trúc phân tán và khả năng xử lý dữ liệu trong bộ nhớ giúp Spark thực hiện các nhiệm vụ tính toán nhanh chóng hơn nhiều so với các framework khác. Điều này làm giảm đáng kể thời gian xử lý dữ liệu, đồng thời tối ưu hóa việc sử dụng tài nguyên.

- Apache Spark hỗ trợ đa dạng các ngôn ngữ lập trình như Scala, Java, Python và R, mở rộng khả năng tích hợp cho những người phân tích dữ liệu và nhà phát triển. Sự đa ngôn ngữ này mang lại sự linh hoạt và thuận tiện cho việc triển khai ứng dụng.

- Khả năng xử lý đa dạng các loại công việc, từ xử lý batch, xử lý stream đến machine learning và xử lý đồ thị. Việc có một framework duy nhất cho nhiều mục đích giúp giảm độ phức tạp trong việc quản lý hệ thống và mã nguồn.

- Cộng đồng sử dụng Apache Spark ngày càng lớn mạnh, với sự đóng góp và hỗ trợ từ cả cộng đồng mở và các tổ chức hàng đầu. Điều này đảm bảo rằng Spark không chỉ là một công cụ hiệu quả, mà còn là một hệ sinh thái đa dạng và phát triển, luôn cập nhật với các xu hướng và yêu cầu mới trong lĩnh vực xử lý dữ liệu lớn.

6. Tính năng nổi bật của Apache Spark

Apache Spark đứng đầu trong danh sách các framework xử lý dữ liệu lớn nhờ vào những tính năng nổi bật và độ linh hoạt mà nó mang lại cho người sử dụng. Một trong những đặc điểm quan trọng nhất của Spark là:

- Khả năng xử lý dữ liệu nhanh chóng và hiệu quả: nhờ sự tích hợp kiến trúc phân tán và xử lý dữ liệu trong bộ nhớ.

- Tính tương thích đa ngôn ngữ của Apache Spark là một lợi thế khác, hỗ trợ Scala, Java, Python và R. Điều này tạo điều kiện thuận lợi cho người phân tích dữ liệu và nhà phát triển, giúp họ sử dụng ngôn ngữ mà họ thoải mái và chuyên sâu nhất.

- Khả năng đa nhiệm: có thể xử lý nhiều loại công việc khác nhau trong một framework. Từ xử lý dữ liệu theo batch, xử lý stream, đến machine learning và xử lý đồ thị, Spark đều thực hiện dễ dàng.

- Khả năng truy vấn dữ liệu nhanh chóng bằng SQL truyền thống, cung cấp tính linh hoạt cao cho việc truy cập và xử lý dữ liệu có cấu trúc.

- Cộng đồng người dùng lớn và sự phát triển liên tục của Apache Spark là một điểm mạnh nổi bật khác. Cộng đồng rộng lớn này không chỉ giúp giải quyết vấn đề mà còn giữ cho Spark luôn là một công cụ hiện đại và linh hoạt, đáp ứng mọi nhu cầu xử lý big data.

7. Tính ứng dụng của Apache Spark

- Tài chính: Apache Spark đã trở thành một công cụ quan trọng trong lĩnh vực dịch vụ tài chính, đặc biệt là trong ngành ngân hàng và đầu tư, nơi mà big data đóng một vai trò quan trọng trong việc ra quyết định kinh doanh.

- Chăm sóc sức khỏe: Apache Spark đang chứng minh vai trò quan trọng trong lĩnh vực chăm sóc sức khỏe, giúp cung cấp dịch vụ chăm sóc bệnh nhân hiệu quả và toàn diện.

- Sản xuất: Ứng dụng chính của Spark trong lĩnh vực này là loại bỏ thời gian ngừng hoạt động của thiết bị kết nối internet thông qua việc đề xuất thời điểm thực hiện bảo trì phòng ngừa. Bằng cách thu thập và phân tích dữ liệu về hiệu suất, sự cố và chu kỳ hoạt động của thiết bị, Spark giúp dự đoán các vấn đề tiềm ẩn và đề xuất thời điểm phù hợp để thực hiện các biện pháp bảo trì.

- Bán lẻ: Trong ngành bán lẻ, việc giữ chân và thu hút khách hàng ngày càng trở thành một thách thức đối với các doanh nghiệp. Apache Spark đã nổi lên như một công cụ mạnh mẽ, hỗ trợ các doanh nghiệp bán lẻ tối ưu hóa trải nghiệm khách hàng thông qua việc cá nhân hóa dịch vụ và ưu đãi.

8. Ưu và nhược điểm của Apache Spark

8.1. Ưu điểm

- Dễ sử dụng: Một trong những điểm mạnh quan trọng của Apache Spark là sự dễ tiếp cận. Framework này được thiết kế với mục tiêu giảm độ phức tạp và cung cấp một giao diện người dùng thân thiện. Người dùng chỉ cần có kiến thức cơ bản về database và lập trình Python hoặc Scala, mà không yêu cầu sự hiểu biết sâu rộng về hệ thống hay lập trình phức tạp. Điều này làm cho Apache Spark trở thành một công cụ hữu ích cho mọi người từ các nhà phân tích dữ liệu đến các nhà phát triển ứng dụng.

- Tốc độ nhanh: Khả năng và tốc độ phân tích thời gian thực của Apache Spark là một trong những đặc điểm ấn tượng, làm cho nó trở thành một lựa chọn hàng đầu cho xử lý dữ liệu thời gian thực và các ứng dụng yêu cầu sự tin cậy và hiệu suất cao.

- Được hỗ trợ bởi các thư viện cấp cao: khả năng tích hợp và sử dụng các thư viện cấp cao như truyền dữ liệu trực tuyến (Spark Streaming), truy vấn SQL (Spark SQL), học máy (MLlib) và xử lý đồ thị (GraphX). Điều này không chỉ giúp nhà phát triển tiết kiệm thời gian và công sức mà còn đảm bảo tính mở rộng và tính tương thích giữa các phần mềm và thư viện.

- Tương thích cao – Hỗ trợ nhiều ngôn ngữ lập trình: Khả năng tương thích cao và hỗ trợ nhiều ngôn ngữ lập trình là một trong những đặc điểm nổi bật của Apache Spark, làm cho nó trở thành một framework linh hoạt và dễ tích hợp trong nhiều hệ thống và môi trường khác nhau.

8.2. Nhược điểm

- Tài nguyên tiêu tốn lớn: Do việc duy trì các dữ liệu trong bộ nhớ (in-memory) để tối ưu hóa hiệu suất, Spark yêu cầu một lượng tài nguyên bộ nhớ đáng kể, đặc biệt là khi xử lý các tập dữ liệu lớn. Điều này có thể gây khó khăn trong việc quản lý và triển khai trên các hệ thống có tài nguyên hạn chế.

- Tồn tại độ trễ: Độ trễ này phụ thuộc vào độ dài của các mini-batches, gây khó khăn cho các ứng dụng yêu cầu phản ứng ngay lập tức và có độ chính xác cao trong xử lý dữ liệu.

- Sự phức tạp trong quản lý và xử lý dữ liệu không cấu trúc: Trong khi Spark tập trung chủ yếu vào dữ liệu có cấu trúc, việc xử lý dữ liệu không cấu trúc như văn bản hoặc JSON có thể đòi hỏi sự tốn kém và đôi khi không hiệu quả.

- Đòi hỏi kiến thức chuyên sâu và kỹ năng quản trị cao. Việc tối ưu hóa cấu hình, theo dõi hiệu suất, và xử lý lỗi có thể là nhiệm vụ phức tạp, đặc biệt là trong các môi trường lớn.

9. Một số doanh nghiệp lớn sử dụng Apache Spark

- Công ty Yelp đã thành công trong việc áp dụng Apache Spark để xử lý lượng lớn dữ liệu và tạo mô hình dự đoán, đặc biệt là để đánh giá tương tác của người dùng với quảng cáo. Bằng cách sử dụng Apache Spark trên nền tảng Amazon EMR, Yelp không chỉ thuận tiện trong việc quản lý và xử lý dữ liệu mà còn đạt được những kết quả quan trọng.

- Doanh nghiệp Zillow là một trong những trang web bất động sản trực tuyến hàng đầu, đã tích hợp hiệu quả Apache Spark vào quy trình làm việc của mình. Sử dụng các thuật toán máy học từ Apache Spark trên Amazon EMR, Zillow có khả năng xử lý các tập dữ liệu lớn trong thời gian thực, đặc biệt là để tính toán Zestimates – công cụ ước tính định giá nhà.

- CrowdStrike là một công ty hàng đầu trong lĩnh vực bảo mật, đã sử dụng Amazon EMR với Spark để nâng cao khả năng bảo vệ điểm cuối. Đối mặt với hàng trăm terabyte dữ liệu sự kiện, CrowdStrike khéo léo sử dụng Apache Spark để xử lý và chuyển đổi dữ liệu thành mô tả hành vi cấp cao trên máy chủ.

- Hearst Corporation một tập đoàn đa ngành với truyền thông chiếm một phần lớn, đã chọn Apache Spark Streaming trên Amazon EMR để nâng cao khả năng theo dõi và phân tích nội dung trên web. Đội ngũ biên tập của công ty sử dụng công nghệ này để theo dõi một cách hiệu quả bài viết nào đang thu hút khách hàng và chủ đề nào đang thịnh hành trong thời gian thực.

- Intent Media đã hiệu quả sử dụng Apache Spark và MLlib để đào tạo và triển khai các mô hình máy học trên quy mô lớn. Thành công này đã mang lại lợi ích lớn cho các doanh nghiệp trong ngành du lịch, giúp họ tối ưu hóa doanh thu từ trang web và ứng dụng của mình.

Tổng kết

Qua bài viết của VinaHost có thể thấy rằng Apache Spark không chỉ là một công cụ xử lý dữ liệu, mà là nguồn động lực cho sự sáng tạo và đổi mới trong lĩnh vực big data. Khả năng tính toán phân tán, tương thích với nhiều ngôn ngữ lập trình, và khả năng tối ưu hóa hiệu suất là những đặc điểm nổi bật khiến Spark trở thành trợ thủ đắc lực cho các nhà phân tích dữ liệu và nhà phát triển.

Với sự tiện lợi và linh hoạt này, Apache Spark không chỉ là một công nghệ mà còn là nguồn cảm hứng không ngừng, đưa chúng ta đến những khám phá mới và mở ra những khả năng không ngờ trong thế của dữ liệu và tính toán phân tán.

Bạn có thể xem thêm các bài viết khác của VinaHost TẠI ĐÂY hoặc liên hệ với chúng tôi nếu cần tư vấn về dịch vụ:

- Email: support@vinahost.vn

- Hotline: 1900 6046

- Livechat: https://livechat.vinahost.vn/chat.php

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文