DeepSeek hiện nay đang nổi lên và trở thành cơn sốt toàn cầu cho các “tín đồ” trong lĩnh vực trí tuệ nhân tạo. Được thành lập ở Hàng Châu, Trung Quốc vào tháng 5/2023, chuyên phát triển các mô hình ngôn ngữ lớn mã nguồn mở với chi phí đào tạo và triển khai rất thấp. Nền tảng DeepSeek AI Chat, cho phép người dùng trò chuyện, xử lý file, tạo mã và nội dung trực tiếp trên web hoặc di động mà không cần kiến thức chuyên sâu về AI.

Vậy tại sao Deepseek lại khiến người ta phải nhắc đến nhiều như vậy? Cùng VinaHost tìm kiếm câu trả lời trong bài viết này nhé!

1. DeepSeek là gì?

DeepSeek là nền tảng AI mã nguồn mở, cung cấp các mô hình ngôn ngữ lớn với chi phí triển khai thấp. Được phát triển bởi DeepSeek-AI, nền tảng này ứng dụng kiến trúc Mixture-of-Experts kết hợp Multi-head Latent Attention, cho khả năng xử lý ngữ cảnh tối ưu và suy luận logic vượt trội. Bằng giao diện web thân thiện và API tương thích OpenAI, DeepSeek mang đến giải pháp AI linh hoạt, hiệu quả cho doanh nghiệp và cá nhân.

Một nghiên cứu thú vị của “Martin Fowler” trong bài “Nghiên cứu Hiệu quả về chi phí và bộ nhớ của Deepseek” có chỉ ra như sau:

Trong quá trình huấn luyện mô hình AI, Deepseek chứng tỏ mình là một giải pháp siêu tối ưu chi phí và hiệu quả bộ nhớ với tổng chi phí chỉ 5.576 triệu đô la cho phiên bản DeepSeek-V3, trong khi OpenAI báo cáo chi phí lên đến 100 triệu đô la cho GPT-4 vào năm 2023.

2. Deepseek hoạt động tối ưu như thế nào?

Trên thực tế, Deepseek ra đời và hoạt động trong lĩnh vực nghiên cứu Large Language Model từ năm 2023 và chỉ khi họ cho ra mắt DeepSeek-R1 vào đầu năm 2025, cái tên này mới bắt đầu được nhiều người chú ý đến.

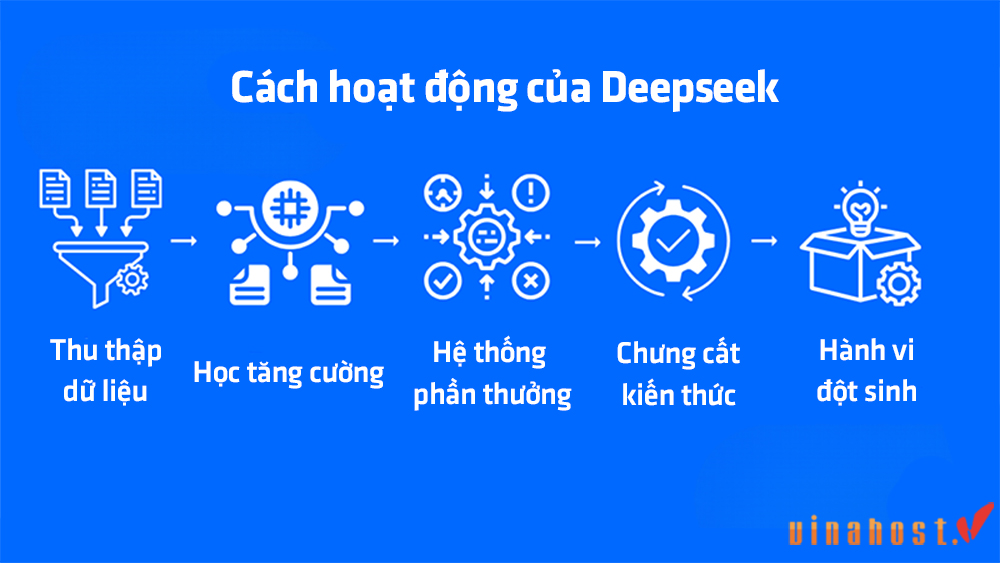

DeepSeek đã chọn cách huấn luyện mô hình R1 khác hẳn so với OpenAI, giúp tiết kiệm thời gian, dùng ít phần cứng chuyên dụng và giảm chi phí. Mục tiêu của họ là tiến gần hơn đến trí tuệ nhân tạo tổng quát (AGI), và những cải tiến trong khả năng lập luận của R1 là bước tiến rõ rệt. Các điểm chính trong quá trình phát triển R1:

- Học tăng cường (Reinforcement learning): Thay vì chỉ dùng cơ chế học có giám sát, DeepSeek áp dụng khả năng học tăng cường quy mô lớn, tập trung vào việc giúp máy “suy nghĩ” và tự tìm ra cách giải quyết các bài toán khó.

- Thiết kế hệ thống phần thưởng (Reward engineering): Họ tạo ra một bộ quy tắc để đánh giá và thưởng cho mô hình khi làm đúng, thay vì để một mạng lưới thần kinh tự học. Cách này đơn giản, hiệu quả và thường cho kết quả tốt hơn.

- Chưng cất kiến thức (Distillation): Thay vì giữ mọi sức mạnh trong một mô hình khổng lồ, nhóm nghiên cứu chuyển giao và nén kiến thức vào mô hình nhỏ gọn chỉ 1,5 tỷ tham số nhưng vẫn giữ được khả năng xử lý mạnh mẽ.

- Hành vi đột sinh (Emergent behavior): Nhờ học tăng cường, mô hình tự phát triển những cách suy luận phức tạp mà không cần lập trình trước. Nói cách khác, R1 tự học những chiến lược cao cấp một cách tự nhiên.

3. Đặc điểm của Deepseek

3.1 Mô hình AI mã nguồn mở

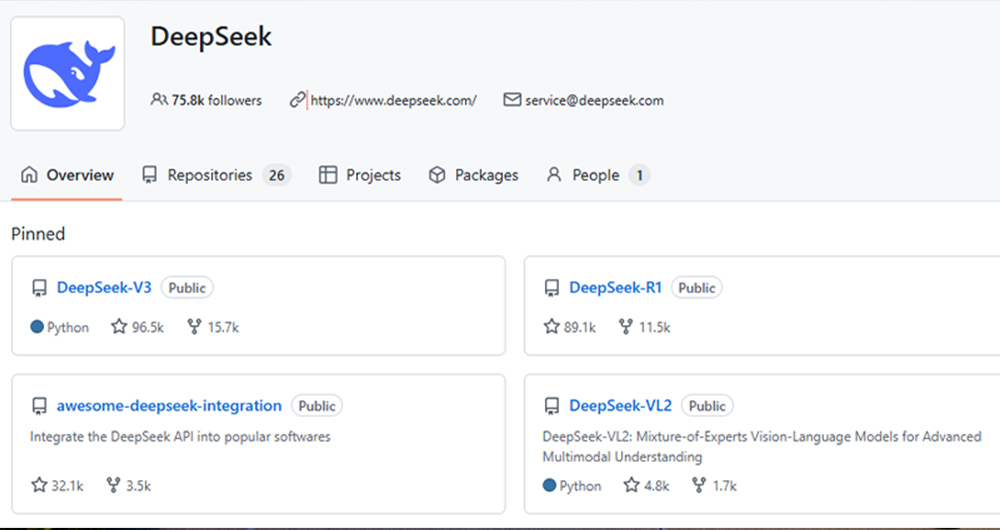

DeepSeek phát hành đầy đủ code và trọng số (weights) cho các mô hình chủ lực như DeepSeek-V3 và DeepSeek-R1 trên GitHub, cho phép mọi tổ chức, cá nhân tự do tải về, chạy thử và tùy biến. Toàn bộ dự án tuân thủ giấy phép MIT, khác với các mô hình độc quyền của Mỹ, giúp loại bỏ rào cản bản quyền và giảm chi phí cấp phép.

3.2 Đa dạng về mô hình và tính năng

Một số mô hình nổi bật như sau:

- DeepSeek-V3: Mô hình Mixture-of-Experts (MoE) với tổng 671 tỷ tham số nhưng mỗi token chỉ kích hoạt 37 tỷ tham số, tối ưu chi phí suy luận.

- DeepSeek-R1-Zero & R1-Distill: Phiên bản không tinh chỉnh (“Zero”) và các mô hình cô đọng từ 1,5 tỷ đến 70 tỷ tham số, thích hợp cho triển khai trên thiết bị biên hoặc hạ tầng vừa phải.

- DeepSeek-R1: Mô hình suy luận tiên phong, cạnh tranh với OpenAI o1 về toán, lập luận và code.

- Janus-Pro-7B: Mô hình đa phương thức tập trung xử lý hình ảnh, đánh dấu bước đầu DeepSeek mở rộng ra beyond text.

3.3 Tối ưu hiệu suất và chi phí

DeepSeek ứng dụng MoE + Multi-head Latent Attention (MLA) để giảm 90% bộ nhớ KV cache so với attention truyền thống, duy trì hiệu năng cao với chi phí GPU thấp hơn. Quá trình này huấn luyện R1 sử dụng reinforcement learning quy mô lớn và distilled knowledge để đạt chất lượng tương đương với o1 nhưng chỉ bằng 1/20 chi phí.

3.4 Ứng dụng đa phương thức

DeepSeek đã ra mắt Janus-Pro-7B, mô hình tập trung xử lý hình ảnh, mở đường cho các ứng dụng đọc, tạo và phân tích ảnh. Trong lộ trình phát triển kế tiếp, công ty đã công bố kế hoạch cho mô hình V4 hỗ trợ đồng thời văn bản, hình ảnh và âm thanh (chưa phát hành chính thức).

3.5 Khả năng mở rộng và linh hoạt

- API OpenAI-compatible: DeepSeek cho phép chuyển đổi nhanh các ứng dụng dùng ChatGPT sang nền tảng của họ chỉ bằng cách đổi endpoint.

- Azure AI Foundry & HuggingFace: Mô hình R1 có sẵn trong thư viện Azure cho doanh nghiệp và hơn 700 mô hình phái sinh trên HuggingFace, đáp ứng từ yêu cầu quy mô lớn đến cài đặt cục bộ.

- Triển khai nội bộ: Toàn bộ code được cung cấp, hỗ trợ chạy offline hoặc trong môi trường private cloud, đảm bảo an toàn dữ liệu và tuân thủ GDPR, CCPA…

3.6 Cộng đồng và tài nguyên phát triển

- GitHub: Hàng chục repo chính thức (DeepSeek-V3, R1, SDK) và hàng trăm dự án phụ trợ từ cộng đồng.

- HuggingFace: Trên 700 mô hình dựa trên V3 và R1, > 5 triệu lượt tải về, minh chứng sức mạnh cộng tác mã nguồn mở.

- Diễn đàn & Blog: WEF, IEEE Spectrum, các nhóm trên Reddit, Medium… thường xuyên thảo luận, phân tích benchmark và chia sẻ hướng dẫn triển khai.

4. Các mô hình phổ biến nhất của Deep seek hiện nay

Dưới đây là những mô hình nổi bật:

DeepSeek R1

DeepSeek-R1 được phát hành chính thức ngày 20 tháng 1 năm 2025, là mô hình đầu tiên của DeepSeek tập trung hoàn toàn vào khả năng lập luận (reasoning).

Phiên bản R1-Zero được huấn luyện chỉ với Reinforcement Learning quy mô lớn, không qua bước Supervised Fine-Tuning, giúp mô hình có khả năng tự khám phá chuỗi suy luận (chain-of-thought).

Sau đó, DeepSeek bổ sung giai đoạn Fine-Tuning có giám sát để ra đời DeepSeek-R1, khắc phục nhược điểm về tính ổn định và khả năng sinh ngôn ngữ trôi chảy. Trên benchmark MMLU, R1 đạt 90.8 %, chỉ kém GPT-4o (91.8 %) nhưng vượt GPT-4o-0513 (87.2 %) và Claude-3.5-Sonnet (88.3 %) .

DeepSeek V3

DeepSeek-V3, phát hành tháng 12 2024, sử dụng Mixture-of-Experts (MoE) với 671 tỷ tham số, trong đó mỗi token chỉ kích hoạt 37 tỷ tham số, và áp dụng cơ chế Multi-head Latent Attention (MLA) để tiết kiệm 90% dung lượng KV cache so với attention truyền thống.

Trên nhiều benchmark, V3 vượt Llama 3.1 và Qwen 2.5, bên cạnh việc đạt hiệu năng ngang ngửa GPT-4o và Claude 3.5 Sonnet với chi phí huấn luyện chỉ $5.58 triệu bằng GPU Nvidia H800 trong 55 ngày.

DeepSeek Coder V2

DeepSeek-Coder-V2 là mô hình Mixture-of-Experts mở, chuyên cho tác vụ sinh code, đạt hiệu năng sánh ngang GPT-4 Turbo trong các bài đánh giá mã nguồn. Trên các bộ đánh giá như HumanEval, MBPP, LiveCodeBench, Defects4J, SWE-Bench và Aider, DeepSeek-Coder-V2-Instruct (236B total, 21B active) ghi điểm cao hơn so với GPT-4 Turbo-1106, Claude-3-Opus, Gemini 1.5 Pro và Llama3-Instruct.

DeepSeek VL

DeepSeek-VL là mô hình Vision-Language (VL) mã nguồn mở, hướng tới hiểu và sinh ngôn ngữ dựa trên hình ảnh trong các kịch bản thực tế. Mô hình hỗ trợ nhiều tác vụ như Visual QA, OCR, phân tích bảng/biểu đồ và visual grounding, tạo nền tảng cho các chatbot đa phương thức.

Thể hiện năng lực tương đương hoặc vượt các mô hình dense và MoE mở nguồn (ví dụ: OpenFlamingo-3B, Video-LLaMA-7B) với ít tham số kích hoạt hơn.

DeepSeek V2

DeepSeek-V2, ra mắt tháng 5/2024, là MoE model với 236 tỷ tham số tổng và 21 tỷ tham số kích hoạt mỗi token. So với phiên bản 67 B trước, V2 tiết kiệm 42.5 % chi phí đào tạo, giảm 93.3 % dung lượng KV cache và tăng tốc độ sinh lên 5.76 lần. DeepSeek-V2 đã kích hoạt cuộc chiến giảm giá giữa các nhà cung cấp AI tại Trung Quốc nhờ mức giá dịch vụ thấp hơn nhưng vẫn giữ hiệu năng cao.

4. So sánh Deepseek với OpenAI

DeepSeek và OpenAI đại diện cho hai triết lý phát triển AI đối lập:

- DeepSeek là startup Trung Quốc cung cấp các mô hình ngôn ngữ lớn mã nguồn mở theo giấy phép MIT, tập trung tối ưu chi phí và cộng đồng

- OpenAI là công ty Mỹ phát triển các mô hình GPT độc quyền, đầu tư khổng lồ vào nghiên cứu và cơ sở hạ tầng.

Về hiệu năng suy luận, hai bên cho kết quả tương đương

- DeepSeek R1 nhỉnh hơn ở các bài toán toán học và kỹ thuật phần mềm

- OpenAI o1 & GPT-4 vượt trội trong tác vụ kiến thức chung và lập trình cạnh tranh.

Điểm khác biệt lớn nhất là chi phí & tài nguyên: DeepSeek R1 được huấn luyện với chỉ ~6 triệu USD và GPU H800 trong 55 ngày, so với hàng trăm triệu USD và dàn GPU “khủng” của OpenAI.

Bạn có thể xem cách so sách trực quan với bảng phân biết chi tiết giữa DeepSeek và OpenAI dưới đây:

| Tiêu chí | DeepSeek | OpenAI |

| Giấy phép | Mã nguồn mở theo MIT License, cho phép thương mại, sửa đổi và phân phối lại không giới hạn | Độc quyền, người dùng chỉ truy cập qua API thương mại của OpenAI hoặc dịch vụ đối tác (Azure OpenAI) |

| Truy cập & Phân phối | Code và trọng số public trên GitHub (deepseek-ai) và Hugging Face | Chỉ qua API: đăng ký trên openai.com hoặc sử dụng Azure OpenAI Service; không công khai mã nguồn |

| Mô hình chính | R1 (reasoning), V3 (MoE + MLA), Coder V2 (code), VL (vision-language), V2 (MoE) | GPT-3.5, o1, GPT-4, GPT-4 Turbo (175B), o4-mini; đa modal (text, image) |

| Kiến trúc | Mixture-of-Experts kết hợp Multi-head Latent Attention, tiết kiệm ~90% dung lượng KV cache so với attention truyền thống | Dense Transformer (chi tiết nội bộ); GPT-4 có ~1 trillion tham số, GPT-4 Turbo 175 B |

| Số tham số |

|

|

| Chi phí huấn luyện | Khoảng 6 triệu USD trên ~2,000 GPU Nvidia H800 trong 55 ngày | Ước tính >100 triệu USD, sử dụng hàng nghìn GPU A100/H100 trong nhiều tháng |

| Hiệu năng (benchmark) | R1 đạt hiệu năng tương đương OpenAI o1 trên toán, code và reasoning | GPT-4 vượt GPT-3.5 |

| Tích hợp nền tảng | Tencent WeChat, Baidu Qianfan; có mặt trên Azure AI Foundry | Azure OpenAI Service, GitHub Copilot, Microsoft 365 Copilot; tích hợp sâu trong hệ sinh thái Microsoft |

| Giá cả dịch vụ | Miễn phí community edition; thương mại hóa qua Azure Foundry với chi phí thấp hơn đối thủ | GPT-3.5: $0.002/1k token; GPT-4: $0.03/1k token (chat) |

| Cộng đồng & Hệ sinh thái | >700 mô hình phụ trợ, 5 triệu+ lượt tải về trên Hugging Face; GitHub deepseek-ai rất sôi động | API phổ biến, nhiều startup và công ty lớn xây dựng ứng dụng trên OpenAI; đối tác chiến lược như Microsoft, SoftBank |

| Bảo mật & tuân thủ | Đã cập nhật chính sách bảo mật sau sự cố tại Hàn Quốc (PIPC). | Quy trình kiểm duyệt nội dung, tuân thủ GDPR, ISO 27001; có đội “red team” đánh giá rủi ro |

4.1. Triết lý phát triển và cấp phép

- DeepSeek (Mã nguồn mở, MIT): Tất cả code và trọng số của các mô hình như R1, V3, Coder V2, VL, V2 được công khai trên GitHub, cho phép tự do sử dụng, sửa đổi và phân phối lại

- OpenAI (Độc quyền): Các mô hình GPT-3.5, o1, GPT-4 và mới nhất là o4-mini không công khai mã nguồn; người dùng chỉ tiếp cận qua API thương mại hoặc dịch vụ đối tác như Azure OpenAI Service

4.2. Hiệu năng và benchmark

- Hiệu năng suy luận (Reasoning): DeepSeek R1 và OpenAI o1 đạt kết quả gần tương đương trên đa số benchmark LLM, với R1 vượt trội hơn về toán học (AIME 2024, MATH-500) và kỹ thuật phần mềm (SWE-Bench), trong khi o1-1217 dẫn đầu ở competitive programming (Codeforces) và kiến thức chung (MMLU).

- Độ chính xác tổng thể: Các đánh giá từ PromptLayer chỉ ra R1 và o1 đều đạt ~80% accuracy trên tập câu hỏi đa dạng, với R1 ưu thế hơn ở toán học và o1 tốt hơn ở bài tập tổng quát.

- Tài nguyên tính toán: DeepSeek R1 sử dụng kiến trúc Mixture-of-Experts (MoE) kết hợp Multi-head Latent Attention, giảm 90% dung lượng KV cache và chỉ kích hoạt 37 tỷ trong 671 tỷ tham số mỗi token, giúp inference nhanh và rẻ.

4.3. Chi phí & tài nguyên huấn luyện

- DeepSeek R1: Được huấn luyện với chi phí khoảng 6 triệu USD trên cụm GPU Nvidia H800 trong 55 ngày

- OpenAI GPT-4 / o1: Theo ước tính, OpenAI đã đầu tư hàng trăm triệu USD và hàng nghìn GPU A100/H100 trong nhiều tháng để đào tạo GPT-4 và o1.

4.4. Ứng dụng & tích hợp

- DeepSeek: Đã tích hợp vào nền tảng Tencent WeChat và Baidu Qianfan, hỗ trợ lập luận doanh nghiệp và chatbot văn bản.

- OpenAI: Được triển khai rộng rãi qua Azure OpenAI Service, có mặt trong GitHub Copilot, Microsoft 365 Copilot và đang chạy trên siêu máy tính Venado của Los Alamos cho nghiên cứu quốc phòng.

4.5. Hệ sinh thái & đối tác

- DeepSeek: Cộng đồng GitHub sôi động, mã nguồn và hơn 700 model phụ trợ trên Hugging Face; startup đang mở rộng đội ngũ sản phẩm và thiết kế tại Bắc Kinh và Hàng Châu

- OpenAI: Hợp tác chiến lược với Microsoft, SoftBank (dự án Stargate 100 tỷ USD), Snowflake, Box, Snowflake Cortex AI, v.v., tạo hệ sinh thái doanh nghiệp rộng lớn trên Azure.

4.6. Vấn đề bản quyền & bảo mật

- DeepSeek vs OpenAI: Gần đây OpenAI đã điều tra cáo buộc DeepSeek dùng kỹ thuật distillation để học mô hình o1, gây tranh cãi về quyền sở hữu trí tuệ trong AI

- An toàn & kiểm soát: OpenAI và Microsoft đầu tư mạnh vào kiểm duyệt nội dung và bảo mật dữ liệu cho Azure OpenAI, trong khi DeepSeek mới chỉ hoàn thiện chính sách bảo mật sau sự cố tại Hàn Quốc.

5. Hướng dẫn đăng ký và cách sử dụng Deepseek chi tiết

Có nhiều cách đăng ký và sử dụng Deepseek, tuy theo nhu cầu sử dụng và người dùng chọn lựa phương thức phù hợp. Đơn giản nhất là truy cập bản online thông qua trang web hoặc app trên điện thoại – phương thức này phù hợp cho người dùng không chuyên về code.

Nâng cao hơn, người dùng có kỹ năng lập trình sử dụng chế độ DeepSeek-Coder hoặc tích hợp API DeepSeek vào ứng dụng (qua OpenAI-compatible API) để tăng tính bảo mật và nâng cao hiệu suất sử dụng mô hình.

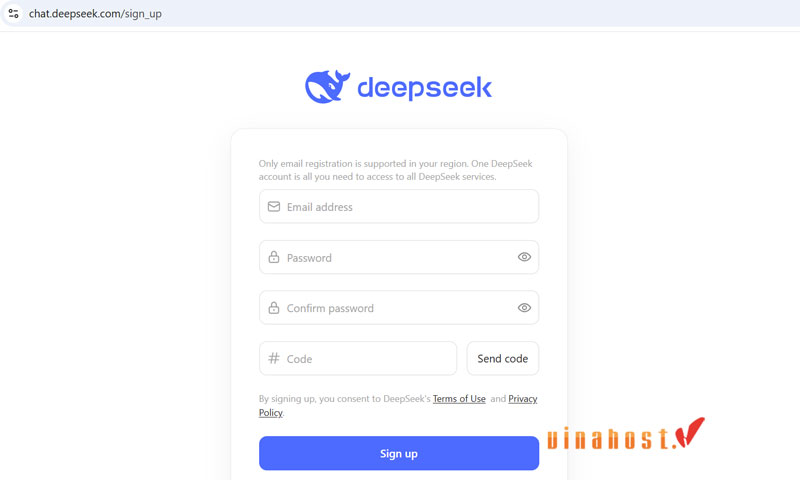

5.1 Đăng ký và đăng nhập Deepseek phiên bản web

Đăng ký tài khoản DeepSeek

- Truy cập trang đăng ký web chat: https://chat.deepseek.com/sign_up

- Nhập địa chỉ email, mật khẩu, sau đó nhấn Send Code để nhận mã xác thực.

- Ngoài web chat, bạn cũng có thể đăng ký qua nền tảng API tại https://platform.deepseek.com/sign_up với giao diện tương tự

Đăng nhập và giao diện cơ bản

- Sau khi xác thực, truy cập liên kết để đăng nhập

- Đăng nhập bằng email và mật khẩu đã tạo ở bước trước

Sử dụng giao diện chat web

- Chat với AI: Giao diện cho phép bạn đặt câu hỏi, tạo nội dung, lập trình hoặc phân tích văn bản.

- Tính năng mở rộng: Hỗ trợ tải lên file, trích xuất văn bản và chế độ Deep-Think để AI suy luận sâu hơn.

5.2 Cấu hình DeepSeek-Coder

Truy cập mã nguồn DeepSeek trên GitHub

Link chính thức:

Cài đặt môi trường

Yêu cầu hệ thống:

- Hệ điều hành: Linux / Windows (WSL) / macOS

- GPU (khuyến nghị): NVIDIA (CUDA 11.7+)

- Python: 3.8+

- PyTorch: 2.0+

Cài đặt thư viện:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117 # Nếu có GPU NVIDIApip install transformers accelerate sentencepieceTải & chạy mô hình DeepSeek LLM

- Cách 1: Sử dụng

transformerstừ Hugging Face

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "deepseek-ai/deepseek-llm-7b" # Hoặc "deepseek-ai/deepseek-llm-67b" cho phiên bản lớn

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto")

input_text = "Xin chào, DeepSeek là gì?"

inputs = tokenizer(input_text, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_length=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))- Cách 2: Chạy trên Google Colab (miễn phí)

- Mở Google Colab

- Chọn GPU (Runtime → Change runtime type → T4/A100)

- Chạy lệnh:

!pip install transformers accelerate

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("deepseek-ai/deepseek-llm-7b", device_map="auto")

tokenizer = AutoTokenizer.from_pretrained("deepseek-ai/deepseek-llm-7b")

response = model.generate(tokenizer.encode("Giải thích AI là gì?", return_tensors="pt").to("cuda"), max_length=100)

print(tokenizer.decode(response[0]))Sử dụng DeepSeek Coder (lập trình)

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "deepseek-ai/deepseek-coder-6.7b-instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto", trust_remote_code=True)

prompt = "Viết hàm Python tính giai thừa"

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_length=200)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))Quantization (Chạy trên CPU/GPU yếu)

Nếu máy bạn không đủ RAM/GPU, có thể dùng quantized model (4-bit/8-bit):

from transformers import BitsAndBytesConfig

quant_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_use_double_quant=True,

)

model = AutoModelForCausalLM.from_pretrained(

"deepseek-ai/deepseek-llm-7b",

quantization_config=quant_config,

device_map="auto"

)Demo với Gradio (Giao diện Web)

Cài đặt Gradio để tạo UI chat:

pip install gradioimport gradio as gr

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("deepseek-ai/deepseek-llm-7b", device_map="auto")

tokenizer = AutoTokenizer.from_pretrained("deepseek-ai/deepseek-llm-7b")

def chat(message):

inputs = tokenizer(message, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_length=200)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

gr.Interface(fn=chat, inputs="text", outputs="text").launch()5.3 Deploy thông qua API Deepseek

Ngoài cách sử dụng DeepSeek trực tiếp trên web hoặc tải mã nguồn về để tự triển khai, còn một cách khác tiện lợi hơn là gọi thông qua API. Hiện nay có nhiều nền tảng hỗ trợ việc này, nhưng với kinh nghiệm thực tế của mình, VinaHost sẽ hướng dẫn bạn cách tích hợp DeepSeek bằng nền tảng Alibaba Cloud — nhanh chóng, đơn giản và dễ quản lý.

Cách triển khai DeepSeek trên Alibaba Cloud

- Truy cập PAI Console và chọn workspace bạn muốn sử dụng.

- Vào mục Model Gallery, tìm mô hình DeepSeek bạn cần (ví dụ: DeepSeek-R1 hoặc DeepSeek-V3).

- Nhấn “Deploy” để triển khai mô hình — bạn có thể dùng cấu hình mặc định hoặc tùy chỉnh nếu cần.

- Chờ hoàn tất triển khai, sau đó vào mục “Deployment Jobs” để theo dõi và lấy thông tin endpoint/API.

- Gọi mô hình qua API hoặc dùng WebUI để thử nghiệm trực tiếp.

Nếu bạn muốn xem hướng dẫn chi tiết từng bước kèm hình ảnh minh họa, hãy truy cập bài viết chính thức: Tại đây!

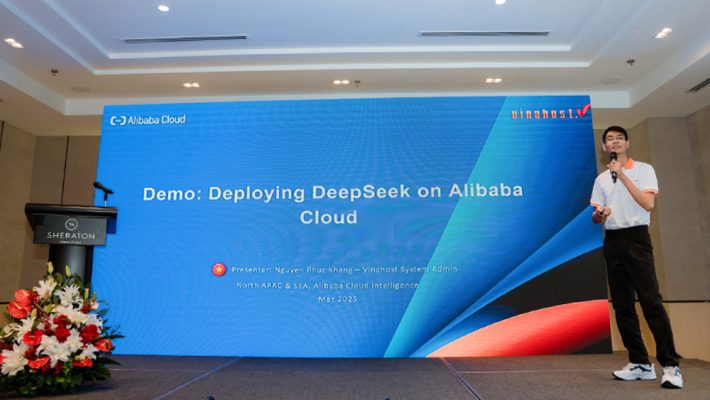

Trên thực tế, mô hình này đã được các chuyên gia áp dụng, và trình bày cách triển khai tại những sân chơi công nghệ hàng đầu.

Tiêu biểu, tại sự kiện “Alibaba Cloud Vietnam AI Day – Unlock Business Potentials in the AI Era”, đại diện VinaHost, anh Nguyễn Phúc Khang (System Admin) đã trực tiếp chia sẻ về cách triển khai DeepSeek trên nền tảng Alibaba Cloud.

Đây là một minh chứng rõ ràng cho việc DeepSeek hoàn toàn có thể tích hợp hiệu quả vào hệ thống doanh nghiệp, giúp khai phá tiềm năng ứng dụng AI trong vận hành, chăm sóc khách hàng, phân tích dữ liệu và hơn thế nữa.

Nếu bạn muốn khám phá các công cụ AI tiên tiến và dễ dàng triển khai DeepSeek chỉ bằng một cú nhấp chuột, hãy tìm hiểu thêm về nền tảng Alibaba Cloud tại đây: Dịch vụ AI của Alibaba Cloud

6. Câu hỏi thường gặp?

Ai là người sáng lập Deepseek?

Liang Wenfeng (梁文锋) là người sáng lập DeepSeek vào tháng 5 2023, dưới sự bảo trợ của quỹ High-Flyer Quantitative Investment Management mà ông đồng lập từ năm 2015. Ông sinh năm 1985 tại tỉnh Quảng Đông, tốt nghiệp ngành Điện tử tại Đại học Chiết Giang và từng dẫn dắt các nghiên cứu ứng dụng AI vào giao dịch tự động trước khi quyết định phát triển mô hình ngôn ngữ lớn.

Deepseek ra đời có tác động gì đến nền kinh tế?

- Rung chuyển thị trường tài chính: Ngày 27/1/2025, thông tin về mô hình AI chi phí thấp của DeepSeek đã khiến cổ phiếu Nvidia sụt gần 17%, thổi bay $593 tỷ vốn hóa trong một phiên giao dịch. Ngày hôm sau, đợt bán tháo lan rộng, xóa sổ hơn $1 nghìn tỷ giá trị thị trường công nghệ toàn cầu.

- Thay đổi chiến lược đầu tư AI: Các nhà phân tích Breakingviews nhận định sự kiện này thúc đẩy các quỹ đầu tư và doanh nghiệp tái cấu trúc kế hoạch chi ngân sách cho hạ tầng AI, dồn nguồn lực sang các mô hình tối ưu chi phí hơn.

- Thu hẹp khoảng cách công nghệ: Theo CEO Lee Kai-Fu của 01.AI, DeepSeek đã rút ngắn khoảng cách về năng lực AI giữa Trung Quốc và Mỹ xuống còn ba tháng, nhờ tối ưu thuật toán và tận dụng chip nội địa.

- Thúc đẩy ngành chip nội địa: Sự thành công của DeepSeek giúp các hãng như Huawei có cơ hội giành thị phần khi cung cấp chip AI giá thành thấp, tăng cường cạnh tranh với các sản phẩm của Nvidia.

Sử dụng Deepseek có an toàn không?

- Vấn đề chuyển dữ liệu không xin phép: Tháng 1/2025, Ủy ban Bảo vệ Thông tin Cá nhân Hàn Quốc (PIPC) phát hiện DeepSeek gửi dữ liệu người dùng và nội dung prompt ra nước ngoài mà không hỏi ý kiến, dẫn đến lệnh đình chỉ tải xuống trên App Store và Google Play tại Hàn Quốc.

- Cập nhật chính sách & khôi phục: DeepSeek sau đó đã điều chỉnh chính sách bảo mật, cho phép người dùng từ chối chuyển dữ liệu cá nhân, và được phép tải lại ứng dụng vào cuối tháng 4/2025.

- Hạn chế từ chính phủ: Nhiều cơ quan chính phủ Hàn Quốc, Australia, Đài Loan… đã cấm sử dụng DeepSeek trên thiết bị công vụ do lo ngại an ninh và rò rỉ dữ liệu.

- Rủi ro lộ lỗ hổng kỹ thuật: Một cuộc kiểm tra từ Wiz Research tiết lộ cấu hình sai máy chủ lưu trữ đám mây, khiến hơn một triệu bản ghi nhạy cảm bị phơi bày, dù sau đó DeepSeek đã khắc phục trong vòng một giờ.

- Khuyến nghị: Mặc dù DeepSeek tuyên bố tuân thủ các quy định quốc tế như GDPR và PIPA, người dùng nên đọc kỹ chính sách quyền riêng tư và cân nhắc hạn chế chia sẻ thông tin nhạy cảm khi sử dụng.

Xem thêm chủ đề AI:

DeepSeek không chỉ là một nền tảng AI mã nguồn mở với kiến trúc Mixture-of-Experts và Multi-head Latent Attention ưu việt, mà còn mang đến giải pháp xử lý ngữ cảnh tối ưu, suy luận logic sâu sắc và chi phí triển khai thấp cho mọi đối tượng người dùng.

Với giao diện web thân thiện, ứng dụng di động tiện lợi và API tương thích chuẩn OpenAI, DeepSeek dễ dàng tích hợp vào hệ thống hiện có, thúc đẩy sáng tạo nội dung, tự động hóa công việc và nâng cao hiệu suất doanh nghiệp.

Từ chatbot thông minh đến trợ lý lập trình, DeepSeek đang mở ra kỷ nguyên AI minh bạch, linh hoạt và hướng tới cộng đồng, hứa hẹn tiếp tục phát triển mạnh mẽ và lan tỏa giá trị trong tương lai gần. Xem thêm nhiều thông tin liên quan tại đây hoặc cần tư vấn thì hãy liên hệ VinaHost

- Email: support@vinahost.vn

- Hotline: 1900 6046

- Livechat: https://livechat.vinahost.vn/chat.php

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文