Nvidia Tesla là dòng sản phẩm GPU cao cấp của Nvidia, được thiết kế đặc biệt để phục vụ các tác vụ tính toán hiệu suất cao, bao gồm học máy, AI, khoa học dữ liệu và các ứng dụng HPC (High-Performance Computing). Với khả năng xử lý song song mạnh mẽ và tích hợp công nghệ tiên tiến, Nvidia Tesla đã trở thành một công cụ quan trọng trong việc thúc đẩy các nghiên cứu và ứng dụng công nghệ cao trong nhiều lĩnh vực. Cùng VinaHost tìm hiểu chi tiết hơn qua bài viết này nhé.

1. Tổng quan kiến thức về Nvidia Tesla

1.1. Nvidia là gì?

Nvidia là một công ty công nghệ đa quốc gia, nổi tiếng với các sản phẩm phần cứng và phần mềm chuyên về đồ họa, tính toán và trí tuệ nhân tạo. Công ty được thành lập vào năm 1993 và có trụ sở tại Santa Clara, California, Mỹ. Nvidia chủ yếu được biết đến với các dòng card đồ họa (GPU) GeForce, được sử dụng trong máy tính cá nhân, game consoles, và các thiết bị điện tử tiêu dùng. Ngoài ra, Nvidia cũng phát triển các sản phẩm cho các ngành công nghiệp khác như xe tự lái và trí tuệ nhân tạo (AI).

Các dòng sản phẩm nổi bật của Nvidia bao gồm:

- GeForce: Dành cho gaming và giải trí.

- Quadro: Dành cho công việc đồ họa chuyên nghiệp và thiết kế 3D.

- Tesla: Dành cho tính toán hiệu suất cao và các ứng dụng khoa học, AI.

- Tegra: Dành cho các thiết bị di động và hệ thống nhúng.

Xem thêm: Nvidia là gì? | Tổng hợp các dòng sản phẩm của Nvidia

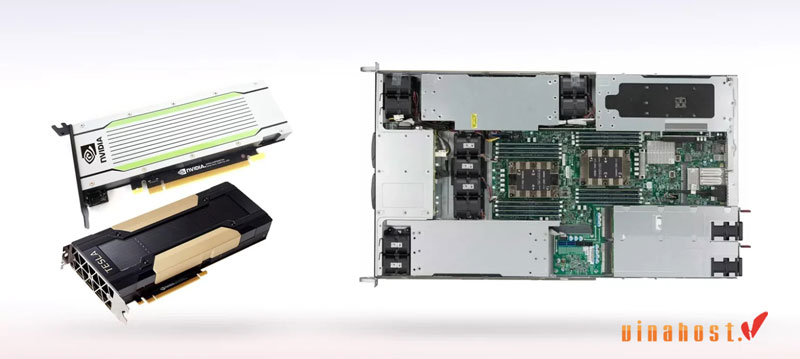

1.2. Nvidia Tesla là gì?

Nvidia Tesla là một dòng sản phẩm GPU chuyên dụng được thiết kế dành cho các ứng dụng tính toán hiệu suất cao (HPC), khoa học, nghiên cứu, và các ứng dụng AI (trí tuệ nhân tạo). Dòng sản phẩm này không chỉ phục vụ cho việc xử lý đồ họa mà còn có khả năng thực hiện các phép toán phức tạp, giúp tăng tốc các ứng dụng cần tính toán nhanh và chính xác.

Đặc điểm nổi bật của Nvidia Tesla

- Tăng tốc tính toán: Tesla sử dụng khả năng tính toán song song của GPU để xử lý khối lượng dữ liệu lớn và các phép toán phức tạp một cách nhanh chóng, vượt trội so với CPU truyền thống.

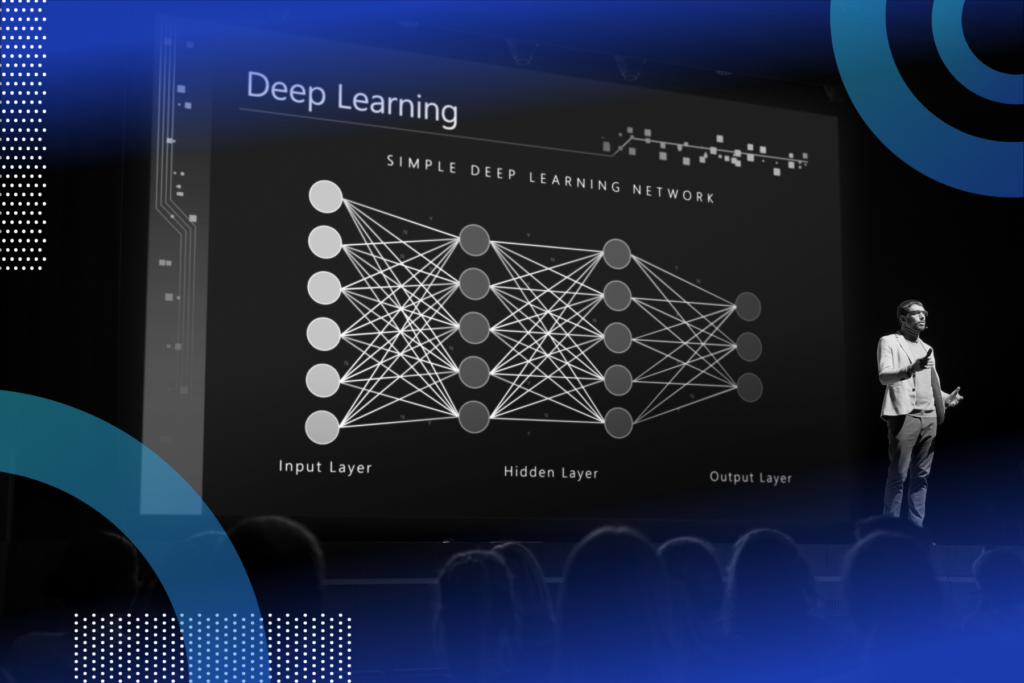

- Ứng dụng trong AI và Machine Learning: Tesla hỗ trợ mạnh mẽ các thuật toán AI, học sâu (deep learning), và các ứng dụng phân tích dữ liệu lớn. Các sản phẩm Tesla được sử dụng trong các hệ thống máy chủ và trung tâm dữ liệu để triển khai các mô hình học máy (machine learning) và học sâu.

- Hỗ trợ CUDA: Tesla GPU hỗ trợ CUDA, giúp lập trình viên tận dụng tối đa khả năng tính toán song song của GPU. CUDA cho phép thực hiện các phép toán phức tạp nhanh hơn rất nhiều so với việc sử dụng CPU đơn giản.

- Tiết kiệm năng lượng: Tesla được thiết kế để tối ưu hóa hiệu suất tính toán mà không tiêu tốn quá nhiều năng lượng, điều này rất quan trọng khi triển khai trong các trung tâm dữ liệu lớn.

- Khả năng mở rộng: Các GPU Tesla có thể được kết nối với nhau trong các cụm máy chủ (server cluster), tạo thành một hệ thống tính toán mạnh mẽ để giải quyết các bài toán khoa học phức tạp và các mô hình AI quy mô lớn.

Các ứng dụng chính của Nvidia Tesla bao gồm:

- Khoa học tính toán: Các nghiên cứu khoa học đụng đến mô phỏng, phân tích dữ liệu lớn, và tính toán đa chiều.

- Học máy và học sâu: Dùng trong các hệ thống học máy (machine learning) và các nghiên cứu AI, đặc biệt trong việc huấn luyện các mạng neuron sâu (deep neural networks).

- Dữ liệu lớn: Các ứng dụng cần xử lý dữ liệu quy mô lớn, chẳng hạn như phân tích dữ liệu từ các cảm biến hoặc hệ thống dữ liệu lớn trong doanh nghiệp.

Các dòng sản phẩm Nvidia Tesla hiện tại bao gồm Tesla V100, Tesla A100, và các sản phẩm mới nhất hỗ trợ các công nghệ tính toán tiên tiến. Hiện tại VPS GPU tại VinaHost cũng đang sử dụng Nvidia Tesla.

2. Đặc điểm của dòng Nvidia Tesla

2.1. Kiến trúc GPU

Kiến trúc GPU của Nvidia Tesla được thiết kế để tối ưu hóa khả năng tính toán hiệu suất cao (HPC) và hỗ trợ các ứng dụng yêu cầu xử lý song song. Mỗi dòng sản phẩm trong gia đình Tesla sử dụng các kiến trúc GPU khác nhau, mỗi thế hệ mang lại những cải tiến vượt bậc về hiệu suất và tính năng. Một số đặc điểm chính của kiến trúc GPU trong các dòng Nvidia Tesla bao gồm:

- Kiến trúc CUDA: CUDA (Compute Unified Device Architecture) là một nền tảng tính toán song song phát triển bởi Nvidia, cho phép lập trình viên tận dụng khả năng xử lý song song của GPU Tesla. Kiến trúc này cho phép xử lý hàng triệu phép toán đồng thời, điều mà các CPU truyền thống không thể làm được. CUDA làm cho Tesla trở thành công cụ lý tưởng cho các ứng dụng khoa học, nghiên cứu AI và học máy.

- Kiến trúc Turing và Ampere: Các dòng GPU Tesla mới như Tesla A100 sử dụng kiến trúc Ampere, một bước đột phá về hiệu suất so với các thế hệ trước. Kiến trúc Ampere mang lại hiệu năng tính toán lớn hơn và khả năng tiết kiệm năng lượng tốt hơn. Trước đó, Tesla V100 sử dụng kiến trúc Volta, với nhiều tính năng nâng cao như Tensor Cores, chuyên dụng cho các phép toán AI.

- Tensor Cores: Được phát triển để xử lý các phép toán ma trận, Tensor Cores là một phần quan trọng trong kiến trúc GPU Tesla, giúp tối ưu hóa các tác vụ học sâu (deep learning) và các thuật toán AI phức tạp. Tensor Cores có khả năng thực hiện các phép toán học ma trận nhanh hơn rất nhiều so với các nhân xử lý thông thường, đặc biệt hữu ích trong các mô hình học sâu như mạng neuron.

- SM (Streaming Multiprocessors): Mỗi GPU Tesla bao gồm nhiều đơn vị xử lý gọi là SM (Streaming Multiprocessors), là các đơn vị tính toán có thể xử lý nhiều luồng dữ liệu đồng thời. Mỗi SM có khả năng thực hiện các phép toán số học song song với độ chính xác cao, từ đó nâng cao khả năng xử lý dữ liệu quy mô lớn.

- NVLink: NVLink là một công nghệ kết nối siêu nhanh của Nvidia, cho phép các GPU Tesla kết nối với nhau trong một hệ thống máy chủ, mang lại khả năng chia sẻ dữ liệu giữa các GPU một cách hiệu quả. Điều này rất quan trọng đối với các ứng dụng cần sức mạnh tính toán vượt trội, chẳng hạn như huấn luyện mạng neuron sâu trên dữ liệu lớn.

- Hỗ trợ bộ nhớ HBM2: Các GPU Tesla thường trang bị bộ nhớ HBM2 (High Bandwidth Memory), giúp tăng băng thông bộ nhớ, đảm bảo tốc độ truy cập dữ liệu nhanh chóng và hiệu quả cho các ứng dụng yêu cầu xử lý dữ liệu lớn, chẳng hạn như phân tích dữ liệu khoa học và AI.

2.2. Hỗ trợ công nghệ tiên tiến

Nvidia Tesla được trang bị nhiều công nghệ tiên tiến để nâng cao hiệu suất và hỗ trợ các ứng dụng đỉnh cao trong các lĩnh vực như học máy, AI, khoa học tính toán và dữ liệu lớn. Dưới đây là một số công nghệ nổi bật:

- Tensor Cores cho AI và học sâu: Các GPU Tesla sử dụng Tensor Cores, giúp tối ưu hóa các phép toán ma trận, đặc biệt trong các ứng dụng AI và học máy. Tensor Cores cho phép gia tốc các phép toán tensor, cải thiện hiệu quả xử lý mô hình học sâu như mạng neuron sâu (DNN) và các mạng đối kháng (GANs). Công nghệ này đã giúp Tesla trở thành lựa chọn hàng đầu trong các trung tâm dữ liệu dành cho AI.

- DLSS (Deep Learning Super Sampling): DLSS là công nghệ tăng cường độ phân giải hình ảnh sử dụng AI, giúp tăng chất lượng đồ họa trong game và ứng dụng thực tế ảo mà không làm giảm hiệu suất tính toán. Mặc dù DLSS chủ yếu được ứng dụng trong các dòng card đồ họa gaming, nhưng công nghệ này có thể được áp dụng trong các ứng dụng AI, giúp tăng tốc quá trình xử lý đồ họa và hình ảnh.

- CUDA và OpenCL: Với CUDA, Tesla có thể thực hiện tính toán song song mạnh mẽ, giúp tăng tốc các ứng dụng tính toán khoa học và nghiên cứu. Bên cạnh CUDA, Tesla còn hỗ trợ OpenCL, một nền tảng tính toán song song mở, cho phép các nhà phát triển sử dụng GPU để tăng tốc các ứng dụng không phải của Nvidia.

- NVLink và Multi-GPU: Công nghệ NVLink giúp kết nối nhiều GPU Tesla trong một hệ thống máy chủ, cho phép các GPU làm việc cùng nhau một cách hiệu quả hơn. Việc sử dụng nhiều GPU trong một hệ thống giúp tăng cường khả năng tính toán khi xử lý các mô hình AI phức tạp hoặc các phép toán khoa học quy mô lớn.

- Dữ liệu chính xác với bốn độ chính xác: Tesla hỗ trợ nhiều độ chính xác số học, bao gồm FP32 (32-bit floating point), FP64 (64-bit floating point), INT8 (8-bit integer) và FP16 (16-bit floating point). Điều này giúp Tesla có thể xử lý linh hoạt các tác vụ yêu cầu độ chính xác khác nhau, từ các phép toán khoa học chính xác đến các phép toán học máy, học sâu, nơi có thể sử dụng độ chính xác thấp hơn để tăng tốc độ xử lý.

- Bộ nhớ HBM2 và băng thông cao: HBM2 (High Bandwidth Memory 2) giúp cải thiện băng thông bộ nhớ, tăng cường khả năng truyền tải dữ liệu giữa GPU và bộ nhớ. Điều này đặc biệt quan trọng trong các ứng dụng cần xử lý dữ liệu lớn và các phép toán tính toán phức tạp như học máy và phân tích dữ liệu khoa học.

Những công nghệ tiên tiến này làm cho Nvidia Tesla trở thành một công cụ mạnh mẽ trong các trung tâm dữ liệu và các ứng dụng tính toán hiệu suất cao, AI và học máy.

2.3. Tương thích nhiều nền tảng

Nvidia Tesla được thiết kế để tương thích với nhiều nền tảng phần cứng và phần mềm, giúp tối ưu hóa hiệu suất và hỗ trợ các ứng dụng tính toán hiệu suất cao, học máy (machine learning), và trí tuệ nhân tạo (AI). Dưới đây là những đặc điểm nổi bật về khả năng tương thích của dòng GPU Nvidia Tesla:

- Tương thích với nhiều hệ điều hành: Nvidia Tesla có thể chạy trên nhiều hệ điều hành khác nhau, bao gồm các phiên bản của Linux, Windows, và macOS (đối với môi trường phát triển). Các hệ điều hành này hỗ trợ các công cụ lập trình như CUDA, cuBLAS và các thư viện GPU khác, giúp các nhà phát triển dễ dàng tối ưu hóa ứng dụng của họ để tận dụng tối đa khả năng tính toán của Tesla.

- Khả năng tích hợp trong các trung tâm dữ liệu: Tesla được thiết kế để dễ dàng tích hợp vào các máy chủ và hệ thống tính toán mạnh mẽ trong các trung tâm dữ liệu. Các giải pháp phần cứng như máy chủ NVIDIA DGX, các hệ thống của các nhà cung cấp như Dell, HP, và IBM đều hỗ trợ GPU Tesla. Điều này giúp việc triển khai các ứng dụng AI, học sâu (deep learning) và các tác vụ tính toán khoa học trở nên dễ dàng và hiệu quả.

- Sự tương thích với các công cụ và phần mềm khoa học: Các ứng dụng trong lĩnh vực khoa học và kỹ thuật thường sử dụng các phần mềm như MATLAB, TensorFlow, PyTorch, và các công cụ tính toán khoa học khác. Nvidia Tesla hỗ trợ tốt các phần mềm này nhờ vào khả năng chạy các thuật toán song song trên GPU thông qua CUDA và các thư viện tăng tốc phần cứng.

- Khả năng hỗ trợ các hệ thống đa GPU: Nvidia Tesla hỗ trợ các hệ thống đa GPU thông qua công nghệ NVLink và các kết nối PCIe. Điều này cho phép các GPU hoạt động cùng nhau trong một hệ thống, mang lại hiệu suất tính toán vượt trội khi xử lý các mô hình AI phức tạp và các tác vụ tính toán khoa học yêu cầu tài nguyên tính toán lớn.

- Tương thích với các nền tảng phần cứng khác: Ngoài các máy chủ và trung tâm dữ liệu, Nvidia Tesla cũng có thể được tích hợp vào các hệ thống nhúng, ví dụ như các hệ thống tự động lái (autonomous vehicles) và các ứng dụng IoT (Internet of Things). Điều này cho phép Tesla được sử dụng trong một loạt các ngành công nghiệp, từ xe tự lái đến phân tích dữ liệu lớn.

2.4. CUDA và cuBLAS

- cuBLAS (CUDA Basic Linear Algebra Subprograms): cuBLAS là một thư viện được Nvidia phát triển để thực hiện các phép toán đại số tuyến tính cơ bản trên GPU, sử dụng nền tảng CUDA. cuBLAS hỗ trợ các phép toán ma trận và vector, giúp tăng tốc việc giải các bài toán đại số tuyến tính trong các ứng dụng khoa học, học máy, và học sâu.

- Các tính năng chính của cuBLAS:

- Tăng tốc các phép toán ma trận: cuBLAS cung cấp các hàm tối ưu để thực hiện các phép toán đại số tuyến tính như nhân ma trận, phép cộng, phép nhân vô hướng, giải hệ phương trình tuyến tính, và các phép toán khác.

- Được tối ưu hóa cho GPU: CuBLAS tận dụng khả năng tính toán song song của GPU để thực hiện các phép toán đại số tuyến tính nhanh chóng và hiệu quả. Việc sử dụng cuBLAS có thể giúp giảm đáng kể thời gian tính toán, đặc biệt trong các ứng dụng yêu cầu xử lý số lượng lớn dữ liệu.

- Tích hợp với các thư viện học máy và AI: CuBLAS được tích hợp với các thư viện học máy như TensorFlow, PyTorch và các phần mềm AI khác, giúp tăng tốc việc huấn luyện và triển khai các mô hình học sâu.

- Các tính năng chính của cuBLAS:

- Ứng dụng của CUDA và cuBLAS:

- Học máy và học sâu: CUDA và cuBLAS giúp tăng tốc các tác vụ huấn luyện mạng neuron sâu (DNN) và các mô hình học máy khác bằng cách thực hiện các phép toán ma trận song song trên GPU.

- Khoa học tính toán: CuBLAS hỗ trợ các nhà khoa học và kỹ sư thực hiện các phép toán đại số tuyến tính hiệu quả trong các mô phỏng khoa học, xử lý dữ liệu lớn và phân tích hệ thống phức tạp.

- Xử lý tín hiệu và hình ảnh: Các ứng dụng trong xử lý tín hiệu số và xử lý hình ảnh, như phân tích ảnh y tế, nhận dạng đối tượng, và các tác vụ xử lý video, có thể tận dụng CUDA và cuBLAS để tăng tốc quá trình xử lý.

Nvidia Tesla, với sự hỗ trợ của CUDA và cuBLAS, đã trở thành một công cụ mạnh mẽ trong các trung tâm dữ liệu, giúp xử lý các tác vụ tính toán phức tạp và các mô hình AI quy mô lớn một cách nhanh chóng và hiệu quả.

2.5. Tính toán song song

Tính toán song song là một trong những đặc điểm quan trọng nhất của dòng GPU Nvidia Tesla, giúp tăng hiệu suất tính toán đáng kể so với các phương pháp truyền thống. Dòng sản phẩm Tesla được thiết kế để tối ưu hóa khả năng xử lý song song, đặc biệt hữu ích trong các ứng dụng đòi hỏi lượng phép toán lớn và các tác vụ tính toán phức tạp. Dưới đây là các đặc điểm nổi bật liên quan đến tính toán song song của Nvidia Tesla:

- Khả năng xử lý hàng triệu luồng đồng thời: Các GPU Tesla có hàng nghìn nhân xử lý, mỗi nhân có khả năng thực hiện phép toán độc lập. Điều này giúp các GPU Tesla xử lý hàng triệu phép toán đồng thời, tương tự như việc xử lý các luồng dữ liệu song song. Khả năng này rất quan trọng trong các ứng dụng đòi hỏi tính toán quy mô lớn, chẳng hạn như phân tích dữ liệu khoa học, mô phỏng vật lý, và học sâu (deep learning).

- CUDA và các mô hình tính toán song song: Nền tảng CUDA của Nvidia được thiết kế để tận dụng tối đa khả năng tính toán song song của GPU. CUDA cho phép lập trình viên viết mã để thực hiện các phép toán song song trên các nhân GPU, giúp tăng tốc quá trình tính toán đáng kể. Các tác vụ như nhân ma trận, phân tích dữ liệu, và mô phỏng có thể được chia nhỏ và xử lý song song trên các nhân GPU.

- Mô hình tính toán “SIMT” (Single Instruction, Multiple Threads): Các GPU Tesla sử dụng mô hình tính toán SIMT, nơi mỗi nhân GPU thực hiện cùng một phép toán trên nhiều dữ liệu khác nhau (tức là mỗi nhân thực hiện cùng một lệnh trên nhiều luồng dữ liệu khác nhau). Điều này giúp tăng tốc hiệu suất xử lý các phép toán đại số tuyến tính, phân tích dữ liệu, và huấn luyện các mô hình học sâu, khi mỗi dữ liệu được xử lý đồng thời.

- Khả năng mở rộng với nhiều GPU: Dòng Nvidia Tesla hỗ trợ các hệ thống đa GPU, cho phép nhiều GPU làm việc cùng nhau để xử lý các tác vụ tính toán phức tạp. Các GPU Tesla có thể kết nối với nhau thông qua công nghệ NVLink và PCIe, giúp tăng cường khả năng tính toán song song và giảm thời gian xử lý các phép toán quy mô lớn, đặc biệt trong các ứng dụng AI và học máy.

- Tính toán song song cho các mô phỏng khoa học: Nvidia Tesla rất mạnh mẽ trong việc xử lý các mô phỏng khoa học yêu cầu tính toán song song. Chẳng hạn, trong các mô phỏng vật lý, hóa học, hoặc mô phỏng dòng chảy chất lỏng, các phép toán có thể được chia thành nhiều phần nhỏ và thực hiện đồng thời, giảm thời gian tính toán và tăng hiệu quả nghiên cứu.

- Tối ưu hóa cho các ứng dụng AI và học máy: Trong các mô hình học sâu, việc xử lý song song hàng triệu phép toán là cực kỳ quan trọng. Các GPU Tesla cung cấp khả năng xử lý song song mạnh mẽ cho các phép toán tensor, điều này giúp gia tốc huấn luyện các mô hình AI, đặc biệt là các mạng neuron sâu (deep neural networks). CUDA và các thư viện như cuDNN giúp tối ưu hóa việc sử dụng tài nguyên GPU để thực hiện các phép toán học máy hiệu quả.

2.6. Tính toán cao cấp

Tính toán cao cấp trên dòng Nvidia Tesla liên quan đến khả năng thực hiện các phép toán phức tạp và chuyên sâu, hỗ trợ các ứng dụng yêu cầu tính toán số học và xử lý dữ liệu quy mô lớn. Tesla được thiết kế để xử lý các tác vụ tính toán với độ phức tạp cao và yêu cầu độ chính xác cao. Các đặc điểm sau đây là các yếu tố quan trọng trong tính toán cao cấp của Tesla:

- Hỗ trợ các phép toán đại số tuyến tính: Tesla rất mạnh mẽ trong việc thực hiện các phép toán đại số tuyến tính (linear algebra) phức tạp, như nhân ma trận, phép cộng ma trận, và các phép toán ma trận nghịch đảo. Các thư viện như cuBLAS và cuSOLVER cung cấp các hàm tối ưu cho việc thực hiện các phép toán này trên GPU, giúp gia tốc các tác vụ tính toán trong các ứng dụng khoa học và học máy.

- Khả năng tính toán với độ chính xác cao: Các GPU Tesla hỗ trợ các phép toán với độ chính xác cao, bao gồm các phép toán số học đơn (FP32), số học kép (FP64), và số học bán chính xác (FP16). Điều này giúp Tesla có thể được sử dụng trong các ứng dụng cần độ chính xác cao, chẳng hạn như mô phỏng vật lý, khoa học dữ liệu, và phân tích tài chính. Ngoài ra, Tesla cũng hỗ trợ các phép toán chính xác cao như Tensor Cores (với FP16 và INT8), rất quan trọng trong các ứng dụng AI.

- Tensor Cores cho tính toán AI: Các Tensor Cores trên GPU Tesla mang lại khả năng tính toán cao cấp cho các tác vụ học sâu, đặc biệt là trong việc xử lý các phép toán tensor trong các mô hình học sâu phức tạp. Tensor Cores hỗ trợ các phép toán ma trận với độ chính xác thấp hơn (FP16 hoặc INT8), giúp tăng tốc việc huấn luyện và triển khai các mô hình AI mà không làm giảm đáng kể độ chính xác.

- Khả năng xử lý số học đối xứng và không đối xứng: Tesla cũng hỗ trợ các phép toán số học đối xứng và không đối xứng, phù hợp với các bài toán tối ưu hóa và phân tích dữ liệu phức tạp trong các ứng dụng học máy và khoa học tính toán.

- Tối ưu hóa cho các mô phỏng khoa học phức tạp: Các ứng dụng như mô phỏng vật lý, mô phỏng cơ học chất lỏng, hoặc các mô phỏng các hiện tượng tự nhiên đòi hỏi khả năng tính toán phức tạp và chính xác. Dòng Nvidia Tesla được tối ưu hóa để xử lý những tác vụ này, với khả năng chia nhỏ các phép toán phức tạp thành các phần nhỏ và xử lý chúng song song trên hàng nghìn nhân GPU.

- Khả năng mở rộng trong các ứng dụng siêu máy tính: Với khả năng tích hợp nhiều GPU và các công nghệ như NVLink, Tesla có thể được sử dụng trong các hệ thống siêu máy tính, nơi tính toán cao cấp là yếu tố quan trọng. Các hệ thống này có thể xử lý hàng nghìn phép toán đồng thời và hỗ trợ các tác vụ khoa học, nghiên cứu và mô phỏng quy mô lớn.

- Tính toán phân tán: Tesla cũng hỗ trợ các tính toán phân tán, giúp chia sẻ công việc tính toán giữa nhiều GPU hoặc các nút tính toán khác nhau trong mạng lưới. Điều này đặc biệt hữu ích trong các mô hình học máy phân tán, nơi một mô hình AI lớn có thể được huấn luyện trên nhiều máy tính hoặc GPU khác nhau.

Xem thêm: eGPU là gì? | Cấu tạo, Hoạt động & Phân loại của eGPU

3. Phân loại các dòng sản phẩm Nvidia Tesla

3.1. Nvidia Tesla K: Sử dụng kiến trúc Kepler

Dòng sản phẩm Nvidia Tesla K là một trong những dòng sản phẩm nổi bật của Nvidia trong lĩnh vực tính toán hiệu suất cao (HPC) và các ứng dụng học máy. Dòng Tesla K sử dụng kiến trúc Kepler, một kiến trúc GPU tiên tiến được Nvidia phát triển để cung cấp hiệu suất tính toán mạnh mẽ và khả năng tiết kiệm năng lượng. Dưới đây là những đặc điểm và phân loại chi tiết của dòng Nvidia Tesla K:

- Kiến trúc Kepler:

- Kiến trúc Kepler của Nvidia đánh dấu bước tiến quan trọng trong việc tối ưu hóa hiệu suất của GPU. Kepler sử dụng công nghệ 28nm (nano mét), cho phép GPU đạt hiệu suất cao trong khi vẫn tiết kiệm năng lượng hơn so với các phiên bản trước đó.

- Kepler mang lại hiệu quả vượt trội trong việc xử lý các phép toán song song nhờ khả năng chia nhỏ các tác vụ tính toán và xử lý chúng song song trên hàng nghìn lõi GPU.

- Kepler sử dụng SMX (Streaming Multiprocessor) thay vì SM (Streaming Multiprocessor) trên các thế hệ GPU trước đó, cho phép nâng cao hiệu suất tính toán, đặc biệt là trong các ứng dụng đòi hỏi sức mạnh tính toán lớn.

- Các dòng GPU trong Nvidia Tesla K:

- Tesla K10: Là phiên bản đầu tiên trong dòng Tesla K, Tesla K10 được thiết kế cho các ứng dụng HPC và các tác vụ tính toán quy mô lớn. Nó sử dụng 2,560 nhân CUDA và có bộ nhớ GDDR5 với dung lượng lên tới 5 GB, giúp xử lý các phép toán phức tạp một cách nhanh chóng.

- Tesla K20: Tesla K20 được nâng cấp với 2,496 nhân CUDA và sử dụng bộ nhớ GDDR5 với dung lượng 5 GB. K20 mang lại hiệu suất tính toán mạnh mẽ hơn so với K10 và được tối ưu hóa cho các ứng dụng như học sâu (deep learning), phân tích dữ liệu, và các mô phỏng khoa học.

- Tesla K40: Đây là phiên bản cao cấp hơn trong dòng Tesla K, sử dụng 2,880 nhân CUDA và bộ nhớ GDDR5 12 GB, mang lại hiệu suất tính toán vượt trội. Tesla K40 thích hợp cho các ứng dụng yêu cầu tài nguyên tính toán lớn, như phân tích dữ liệu lớn (big data), học máy và các mô phỏng vật lý phức tạp.

- Ưu điểm của kiến trúc Kepler:

- Tiết kiệm năng lượng: Một trong những điểm nổi bật của Kepler là khả năng tiết kiệm năng lượng mà vẫn duy trì hiệu suất tính toán cao. Điều này giúp giảm chi phí vận hành và tối ưu hóa hiệu quả năng lượng trong các trung tâm dữ liệu.

- Hiệu suất tính toán cao: Kepler mang lại khả năng tính toán vượt trội cho các tác vụ tính toán quy mô lớn, đặc biệt là trong các ứng dụng như học sâu, mô phỏng khoa học và các hệ thống HPC.

- Khả năng hỗ trợ tính toán song song mạnh mẽ: Với sự tối ưu hóa khả năng tính toán song song, Kepler rất phù hợp với các ứng dụng yêu cầu xử lý dữ liệu lớn và các phép toán phức tạp, như phân tích dữ liệu khoa học, dự báo thời tiết và nghiên cứu sinh học.

- Ứng dụng:

- Các ứng dụng tính toán khoa học: Tesla K rất mạnh mẽ trong các mô phỏng khoa học, chẳng hạn như mô phỏng khí động học, nghiên cứu vật lý, mô phỏng chất lỏng và các nghiên cứu y sinh học.

- Học sâu và AI: Dòng sản phẩm Tesla K được sử dụng rộng rãi trong các hệ thống học máy và AI, giúp giảm thời gian huấn luyện mô hình và cải thiện hiệu quả tính toán.

3.2. Nvidia Tesla M: Sử dụng kiến trúc Maxwell

Dòng Nvidia Tesla M sử dụng kiến trúc Maxwell, là một bước phát triển quan trọng trong công nghệ GPU của Nvidia. Maxwell mang lại hiệu suất tính toán cao và cải tiến đáng kể về hiệu suất năng lượng so với các dòng sản phẩm trước đó. Được tối ưu hóa cho các ứng dụng khoa học, học máy, và tính toán HPC, Tesla M là lựa chọn lý tưởng cho các hệ thống yêu cầu tính toán mạnh mẽ và tiết kiệm năng lượng. Dưới đây là những đặc điểm và phân loại chi tiết của dòng Nvidia Tesla M:

- Kiến trúc Maxwell:

- Maxwell sử dụng công nghệ 28nm và được tối ưu hóa để cải thiện hiệu suất và giảm lượng năng lượng tiêu thụ. Một trong những điểm nổi bật của Maxwell là khả năng thực hiện các phép toán với độ chính xác cao trong khi vẫn duy trì hiệu suất năng lượng vượt trội.

- Maxwell cải thiện hiệu suất xử lý song song bằng cách tối ưu hóa các SM (Streaming Multiprocessors) để thực hiện các phép toán nhanh chóng và hiệu quả hơn.

- Các dòng GPU trong Nvidia Tesla M:

- Tesla M40: Tesla M40 là một trong những sản phẩm cao cấp nhất trong dòng Tesla M, với 3,000 nhân CUDA và bộ nhớ GDDR5 lên đến 12 GB. Tesla M40 được tối ưu hóa cho các ứng dụng học sâu, phân tích dữ liệu lớn, và các mô phỏng khoa học quy mô lớn. Nó cung cấp hiệu suất tính toán mạnh mẽ và khả năng xử lý các mô hình AI phức tạp.

- Tesla M60: Đây là phiên bản dành cho các hệ thống ảo hóa và tính toán đám mây, với khả năng chia sẻ tài nguyên giữa nhiều người dùng. Tesla M60 cung cấp 4,096 nhân CUDA và bộ nhớ GDDR5 16 GB, giúp tăng cường hiệu suất trong các ứng dụng đa nhiệm và ảo hóa.

- Tesla M4: Tesla M4 là phiên bản tiết kiệm năng lượng của dòng Tesla M, với 1,024 nhân CUDA và bộ nhớ GDDR5 4 GB. Dòng sản phẩm này được tối ưu hóa cho các ứng dụng AI và phân tích dữ liệu, đặc biệt là trong các môi trường tính toán yêu cầu tiết kiệm năng lượng.

- Ưu điểm của kiến trúc Maxwell:

- Tiết kiệm năng lượng: Maxwell mang lại hiệu suất tính toán cao nhưng tiêu tốn ít năng lượng hơn so với các thế hệ GPU trước. Điều này rất quan trọng trong các ứng dụng đòi hỏi tính toán liên tục và lâu dài, như trong các trung tâm dữ liệu hoặc môi trường tính toán đám mây.

- Hiệu suất cao trong các ứng dụng AI: Tesla M được thiết kế để tối ưu hóa các phép toán AI và học sâu, giúp tăng tốc huấn luyện và triển khai các mô hình học sâu phức tạp.

- Khả năng tính toán song song mạnh mẽ: Giống như dòng Tesla K, Tesla M cũng hỗ trợ khả năng tính toán song song mạnh mẽ, giúp xử lý nhanh chóng các phép toán phức tạp và dữ liệu lớn trong các ứng dụng khoa học và học máy.

- Ứng dụng:

- Học máy và AI: Tesla M được sử dụng rộng rãi trong các hệ thống học sâu và AI, hỗ trợ các mô hình học sâu và các thuật toán học máy với khả năng xử lý nhanh chóng.

- Ứng dụng trong trung tâm dữ liệu và đám mây: Với khả năng tiết kiệm năng lượng và hiệu suất tính toán mạnh mẽ, Tesla M là lựa chọn lý tưởng cho các hệ thống tính toán đám mây và trung tâm dữ liệu.

3.3. Nvidia Tesla P: Sử dụng kiến trúc Pascal

Dòng Nvidia Tesla P sử dụng kiến trúc Pascal, một trong những kiến trúc GPU tiên tiến nhất của Nvidia. Với các cải tiến vượt bậc trong hiệu suất tính toán và tiết kiệm năng lượng, Tesla P đã trở thành sự lựa chọn lý tưởng cho các ứng dụng HPC (High Performance Computing) và học máy. Dưới đây là những đặc điểm nổi bật của dòng Tesla P:

- Kiến trúc Pascal:

- Kiến trúc Pascal được xây dựng trên công nghệ 16nm FinFET, giúp giảm mức tiêu thụ năng lượng và cải thiện hiệu suất tính toán.

- Pascal nâng cấp khả năng tính toán song song mạnh mẽ với các CUDA cores hiệu quả hơn, giúp tăng tốc đáng kể các phép toán trong các ứng dụng học máy, mô phỏng khoa học và AI.

- NVLink (công nghệ kết nối tốc độ cao của Nvidia) được tích hợp vào Tesla P, giúp kết nối các GPU nhanh chóng, hỗ trợ hiệu suất tính toán đồng thời trên nhiều GPU.

- Các dòng GPU trong Nvidia Tesla P:

- Tesla P100: Tesla P100 là một trong những dòng sản phẩm hàng đầu của Nvidia, với 3,584 nhân CUDA và bộ nhớ HBM2 16 GB, mang lại hiệu suất tính toán vượt trội. P100 được tối ưu hóa cho các ứng dụng HPC, học sâu, và phân tích dữ liệu lớn.

- Tesla P40: Với 3,840 nhân CUDA và bộ nhớ GDDR5 24 GB, P40 tập trung vào các ứng dụng AI và học máy, đặc biệt là trong huấn luyện và triển khai các mô hình học sâu.

- Tesla P4: Phiên bản tiết kiệm năng lượng của dòng P, Tesla P4 có 2,560 nhân CUDA và bộ nhớ GDDR5 8 GB. P4 được thiết kế cho các ứng dụng inference (suy luận) AI và AI thời gian thực.

- Ưu điểm của Pascal:

- Hiệu suất cao: Tesla P cung cấp hiệu suất tính toán vượt trội, đặc biệt trong các ứng dụng yêu cầu tài nguyên tính toán lớn như học sâu, phân tích dữ liệu và các mô phỏng khoa học.

- Tính năng NVLink: NVLink hỗ trợ kết nối giữa nhiều GPU, mang lại khả năng tính toán phân tán mạnh mẽ, giúp tối ưu hóa hiệu suất trong các hệ thống đa GPU.

- Tiết kiệm năng lượng: Nhờ công nghệ 16nm FinFET, Pascal mang lại hiệu suất tính toán mạnh mẽ mà không tiêu thụ quá nhiều năng lượng.

- Ứng dụng:

- Học sâu và AI: Tesla P được sử dụng trong các hệ thống học sâu và AI, giúp tăng tốc huấn luyện mô hình và triển khai các ứng dụng AI phức tạp.

- HPC và nghiên cứu khoa học: Tesla P rất phù hợp với các ứng dụng yêu cầu tính toán quy mô lớn, như mô phỏng khoa học, phân tích dữ liệu và nghiên cứu y sinh học.

3.4. Nvidia Tesla V: Sử dụng kiến trúc Volta

Dòng Nvidia Tesla V sử dụng kiến trúc Volta, mang đến những cải tiến mạnh mẽ về hiệu suất và khả năng tính toán AI so với các thế hệ trước. Volta sử dụng các Tensor Cores để tối ưu hóa các phép toán trong AI và học máy, giúp tăng cường đáng kể khả năng xử lý các tác vụ phức tạp.

- Kiến trúc Volta:

- Tensor Cores là điểm nổi bật của kiến trúc Volta, giúp tăng tốc các phép toán ma trận, đặc biệt là trong các tác vụ AI và học sâu.

- Volta sử dụng công nghệ 12nm FinFET, cho phép GPU đạt được hiệu suất tính toán cao mà vẫn giữ mức tiêu thụ năng lượng hợp lý.

- Tesla V tích hợp NVLink 2.0, giúp kết nối nhiều GPU với nhau, tăng cường hiệu suất cho các ứng dụng HPC và AI.

- Các dòng GPU trong Nvidia Tesla V:

- Tesla V100: Đây là sản phẩm cao cấp của dòng Tesla V, được trang bị 5,120 nhân CUDA và bộ nhớ HBM2 16 GB, mang lại hiệu suất tính toán cực kỳ mạnh mẽ. Tesla V100 được tối ưu hóa cho các ứng dụng AI, học sâu và HPC.

- Ưu điểm của Volta:

- Tensor Cores giúp tăng tốc đáng kể các phép toán học sâu và AI, mang lại hiệu suất tính toán nhanh hơn.

- NVLink 2.0 hỗ trợ các hệ thống đa GPU hiệu quả hơn, nâng cao hiệu suất tính toán trong các hệ thống yêu cầu tính toán phân tán.

- Hiệu suất tính toán cao trong các ứng dụng HPC và AI.

- Ứng dụng:

- AI và học sâu: Dòng Tesla V chủ yếu được sử dụng trong các ứng dụng AI, giúp tăng tốc huấn luyện và triển khai các mô hình học sâu phức tạp.

- Nghiên cứu khoa học: Tesla V được sử dụng rộng rãi trong các ứng dụng HPC và nghiên cứu khoa học yêu cầu tính toán mạnh mẽ.

3.5. Nvidia Tesla T: Sử dụng kiến trúc Turing

Dòng Nvidia Tesla T sử dụng kiến trúc Turing, mang lại sự đột phá trong việc tích hợp khả năng ray tracing và AI trong các GPU. Turing được thiết kế để tối ưu hóa hiệu suất tính toán AI và đồ họa, giúp cải thiện khả năng mô phỏng và phân tích trong các ứng dụng yêu cầu xử lý đồ họa cao.

- Kiến trúc Turing:

- Turing được tích hợp các RT Cores (Ray Tracing Cores) và Tensor Cores, giúp xử lý các tác vụ đồ họa và AI đồng thời.

- Kiến trúc này cung cấp khả năng xử lý đồ họa chân thực với tính năng ray tracing, đồng thời tối ưu hóa các phép toán học sâu trong AI.

- Các dòng GPU trong Nvidia Tesla T:

- Tesla T4: Tesla T4 được trang bị 2,560 nhân CUDA và bộ nhớ GDDR6 16 GB. Đây là dòng sản phẩm phổ biến cho các ứng dụng AI inference và các tác vụ tính toán đồ họa.

- Ưu điểm của Turing:

- Ray Tracing giúp cải thiện đồ họa và mô phỏng hình ảnh chân thực hơn.

- Tensor Cores tối ưu hóa các tác vụ AI và học sâu, mang lại hiệu suất tính toán mạnh mẽ.

- Ứng dụng:

- AI inference: Tesla T được tối ưu hóa cho các ứng dụng AI inference, giúp triển khai các mô hình học sâu trong thời gian thực.

- Đồ họa và mô phỏng: Tesla T cung cấp khả năng ray tracing mạnh mẽ cho các ứng dụng đồ họa và mô phỏng.

3.6. Nvidia Tesla A: Sử dụng kiến trúc Ampere

Dòng Nvidia Tesla A sử dụng kiến trúc Ampere, mang lại sự cải tiến vượt bậc trong hiệu suất, hiệu quả năng lượng và tính toán AI so với các thế hệ trước.

- Kiến trúc Ampere:

- Ampere sử dụng 7nm và Tensor Cores thế hệ thứ ba, giúp cải thiện đáng kể hiệu suất AI và học sâu.

- Kiến trúc này hỗ trợ NVIDIA A100, một trong những sản phẩm mạnh mẽ nhất trong dòng Tesla.

- Ưu điểm của Ampere:

- Tensor Cores thế hệ thứ ba cải thiện hiệu suất huấn luyện AI và học sâu.

- Hiệu suất năng lượng vượt trội so với các thế hệ trước.

- Ứng dụng:

- Học sâu: Tesla A được sử dụng cho huấn luyện các mô hình AI lớn và phức tạp.

- Ứng dụng HPC: Tesla A giúp xử lý các tác vụ HPC quy mô lớn.

3.7. Nvidia Tesla H: Sử dụng kiến trúc Hopper

Dòng Nvidia Tesla H sử dụng kiến trúc Hopper, được tối ưu hóa cho các ứng dụng yêu cầu hiệu suất tính toán cực kỳ cao và hỗ trợ các tác vụ AI quy mô lớn.

- Kiến trúc Hopper:

- Hopper sử dụng các công nghệ mới như Tensor Cores thế hệ mới và GPU interconnects để cung cấp khả năng tính toán mạnh mẽ và hiệu quả.

- Kiến trúc này được tối ưu hóa cho các tác vụ AI và HPC yêu cầu tốc độ xử lý cực nhanh.

- Ứng dụng:

- AI và học sâu: Tesla H hỗ trợ huấn luyện các mô hình học sâu với quy mô lớn.

- HPC: Dòng Tesla H được tối ưu hóa cho các ứng dụng HPC yêu cầu hiệu suất tính toán cực kỳ cao.

4. Tính ứng dụng của Nvidia Tesla

4.1. Machine Learning và AI

Nvidia Tesla đã trở thành một công cụ không thể thiếu trong các ứng dụng Machine Learning (ML) và Artificial Intelligence (AI) nhờ vào khả năng tính toán mạnh mẽ và tối ưu hóa các phép toán ma trận, điều này đặc biệt quan trọng đối với các mô hình học sâu (Deep Learning). Các dòng sản phẩm của Tesla, như Tesla V100, Tesla P100, và Tesla A100, được thiết kế với các Tensor Cores giúp tăng tốc mạnh mẽ quá trình huấn luyện các mô hình học máy phức tạp.

- Tensor Cores: Các Tensor Cores này giúp tối ưu hóa các phép toán ma trận, rất quan trọng trong các mô hình học sâu, giúp tăng tốc quá trình huấn luyện và suy luận (inference) AI. Điều này đặc biệt hữu ích trong các tác vụ như nhận dạng hình ảnh, xử lý ngôn ngữ tự nhiên, và phân tích dữ liệu lớn.

- Học sâu (Deep Learning): Nvidia Tesla giúp huấn luyện các mô hình học sâu, chẳng hạn như neural networks và convolutional neural networks (CNNs), bằng cách cung cấp sức mạnh tính toán đồng thời và xử lý nhanh các phép toán phức tạp.

- AI Inference: Ngoài việc huấn luyện, Tesla còn rất hiệu quả trong các tác vụ AI inference, nơi các mô hình học máy đã được huấn luyện sẽ sử dụng GPU Tesla để thực hiện dự đoán với hiệu suất và tốc độ cao.

- Ứng dụng trong AI và ML:

- Hệ thống tự động: Tesla được sử dụng trong các hệ thống tự động như xe tự lái, robot tự động và các hệ thống AI phức tạp.

- Xử lý ngôn ngữ tự nhiên (NLP): Các mô hình NLP có thể được huấn luyện và triển khai nhanh chóng bằng cách sử dụng các dòng Tesla, giúp tạo ra các hệ thống chatbot và trợ lý ảo hiệu quả.

- Chẩn đoán y tế: Tesla giúp huấn luyện các mô hình học máy trong y tế, từ phân tích hình ảnh y khoa đến phát hiện bệnh dựa trên dữ liệu lớn.

4.2. Big Data và khoa học dữ liệu

Nvidia Tesla là một lựa chọn lý tưởng cho các ứng dụng Big Data và Khoa học dữ liệu nhờ vào khả năng xử lý và phân tích lượng dữ liệu khổng lồ một cách nhanh chóng. Các GPU Tesla giúp giảm thời gian xử lý các phép toán phức tạp liên quan đến phân tích dữ liệu, học máy, và khai thác thông tin từ các bộ dữ liệu lớn.

- Khả năng tính toán song song: Các dòng GPU Tesla như Tesla V100 và Tesla A100 có khả năng thực hiện các phép toán song song, giúp xử lý và phân tích hàng terabyte hoặc petabyte dữ liệu nhanh chóng hơn rất nhiều so với các CPU truyền thống.

- Giảm độ trễ trong phân tích dữ liệu: Các tác vụ như phân tích chuỗi thời gian, phân tích dự báo, và khai thác dữ liệu có thể được thực hiện nhanh chóng và hiệu quả hơn với sự trợ giúp của Tesla.

- Các công cụ hỗ trợ:

- CUDA: Nvidia cung cấp CUDA (Compute Unified Device Architecture), một nền tảng tính toán song song giúp các nhà khoa học dữ liệu phát triển các ứng dụng tính toán song song hiệu quả hơn trên Tesla.

- cuDF và cuML: Các thư viện này của Nvidia giúp tăng tốc các tác vụ phân tích dữ liệu và học máy, giúp các nhà khoa học dữ liệu xử lý các bộ dữ liệu lớn hiệu quả.

- Ứng dụng trong Big Data:

- Phân tích dữ liệu tài chính: Tesla giúp xử lý và phân tích dữ liệu tài chính lớn trong thời gian thực, giúp các công ty tài chính đưa ra các quyết định chính xác và nhanh chóng.

- Xử lý dữ liệu khí hậu và mô phỏng môi trường: Các nhà nghiên cứu có thể sử dụng Tesla để phân tích và mô phỏng dữ liệu khí hậu, từ đó đưa ra các dự báo về biến đổi khí hậu.

4.3. Render đồ họa chuyên nghiệp

Nvidia Tesla được sử dụng rộng rãi trong các ứng dụng render đồ họa chuyên nghiệp, đặc biệt trong các ngành công nghiệp như phim ảnh, trò chơi điện tử, và thực tế ảo (VR). Sức mạnh tính toán của GPU Tesla giúp rút ngắn thời gian render các cảnh đồ họa phức tạp và chi tiết.

- Render đồ họa 3D và mô phỏng: Các dòng Tesla, đặc biệt là Tesla V100 và Tesla A100, có khả năng xử lý các phép toán phức tạp liên quan đến render đồ họa 3D và mô phỏng. Việc xử lý nhanh chóng các phép toán ray tracing, phong cảnh 3D, và mô phỏng ánh sáng giúp rút ngắn đáng kể thời gian sản xuất.

- Render trong phim và hoạt hình: Các công ty sản xuất phim và hoạt hình sử dụng Tesla để render các cảnh phim và hoạt hình chất lượng cao, giúp tiết kiệm thời gian và chi phí so với các phương pháp render truyền thống. NVIDIA Iray, một công cụ render nổi tiếng, được tối ưu hóa cho GPU Tesla để mang lại hiệu suất tối đa.

- Ứng dụng trong VR và AR: Nvidia Tesla hỗ trợ các tác vụ đồ họa và mô phỏng trong thực tế ảo (VR) và thực tế tăng cường (AR), cung cấp hình ảnh chân thực và trải nghiệm mượt mà trong các môi trường ảo.

- Ứng dụng trong Render:

- Sản xuất phim và video: Render cảnh phim với độ phân giải cao và chi tiết phức tạp.

- Thiết kế game: Tạo ra các môi trường 3D trong trò chơi điện tử với ánh sáng, bóng tối và chi tiết tinh vi.

- Mô phỏng kỹ thuật: Các ngành như kiến trúc, kỹ thuật cơ khí, và ô tô sử dụng Tesla để render các mô phỏng trong quá trình thiết kế.

4.4. Tính toán khoa học và vật lý

Tesla không chỉ được sử dụng trong các ứng dụng AI và Big Data mà còn rất mạnh mẽ trong các lĩnh vực tính toán khoa học và vật lý, nơi yêu cầu xử lý các phép toán phức tạp và mô phỏng với tốc độ và độ chính xác cao.

- Ứng dụng trong mô phỏng khoa học: Tesla được sử dụng trong các mô phỏng khoa học, chẳng hạn như mô phỏng động lực học chất lỏng (CFD), phân tích cấu trúc và phân tử học. Các dòng Tesla như Tesla V100 và Tesla P100 có khả năng xử lý các phép toán phức tạp trong các mô phỏng động lực học.

- Tính toán vật lý: Các ứng dụng trong vật lý lý thuyết và thực nghiệm có thể tận dụng sức mạnh của Tesla để xử lý các phép toán đa chiều và tính toán trên dữ liệu phức tạp. Ví dụ, các mô phỏng vật lý hạt, mô phỏng plasma trong vật lý thiên văn, và nghiên cứu vật liệu có thể được thực hiện nhanh chóng với sự trợ giúp của Tesla.

- Công cụ hỗ trợ: Các ứng dụng HPC sử dụng CUDA và OpenACC để tối ưu hóa các tác vụ tính toán khoa học, giúp các nhà nghiên cứu xử lý dữ liệu với tốc độ và hiệu quả cao hơn.

- Ứng dụng trong khoa học:

- Mô phỏng vật lý: Các mô phỏng hạt nhân, vũ trụ học, hoặc vật lý lý thuyết.

- Nghiên cứu y học: Tesla hỗ trợ nghiên cứu y học bằng cách thực hiện mô phỏng các quá trình sinh học và y học phức tạp.

- Mô phỏng động lực học chất lỏng (CFD): Sử dụng Tesla để mô phỏng và tối ưu hóa dòng chảy của chất lỏng trong các thiết kế kỹ thuật.

Xem thêm: Máy tính lượng tử là gì? | Tổng quan kiến thức về Quantum

5. Một số câu hỏi liên quan đến Nvidia tesla

5.1. So sánh giữa Nvidia Tesla P40 và Nvidia A100

Nvidia Tesla P40 và Nvidia A100 là hai dòng sản phẩm mạnh mẽ của Nvidia, được thiết kế cho các ứng dụng tính toán hiệu suất cao (HPC), học máy, AI, và mô phỏng khoa học. Tuy nhiên, giữa hai GPU này có sự khác biệt lớn về kiến trúc, hiệu suất và mục đích sử dụng.

1. Kiến trúc:

- Nvidia Tesla P40: Sử dụng kiến trúc Pascal (thế hệ thứ 2), với các CUDA cores và Tensor Cores được tối ưu hóa cho các tác vụ học máy và AI.

- Nvidia A100: Sử dụng kiến trúc Ampere, thế hệ thứ 3 của Nvidia, cải tiến đáng kể về hiệu suất và tính năng hỗ trợ các tác vụ AI và HPC.

2. Hiệu suất:

- Tesla P40:

- Có 24 GB GDDR5 memory.

- Được tối ưu hóa cho các tác vụ học máy và AI với khả năng xử lý 12 TFLOPS cho các phép toán FP16 (half-precision floating point).

- Dùng cho các ứng dụng như inference AI và render đồ họa phức tạp.

- Tesla A100:

- Có 40 GB hoặc 80 GB HBM2 memory, nhanh hơn và lớn hơn rất nhiều so với P40.

- Được tối ưu hóa cho cả AI training và inference, với khả năng xử lý lên đến 312 teraflops cho FP16 (high-performance deep learning).

- Được thiết kế cho các ứng dụng HPC, machine learning, và AI quy mô lớn, có khả năng cải thiện đáng kể tốc độ xử lý các mô hình học sâu phức tạp.

3. Tính năng hỗ trợ:

- Tesla P40:

- Tích hợp CUDA và Tensor Cores giúp tăng tốc các tác vụ học sâu.

- Tốt cho các tác vụ inference với mô hình học máy đã được huấn luyện.

- Tesla A100:

- Hỗ trợ Tensor Cores thế hệ thứ 3, giúp tối ưu hóa các phép toán AI và học sâu.

- Tích hợp công nghệ NVIDIA NVLink để kết nối nhiều GPU, hỗ trợ mô hình phân tán và hiệu suất cao hơn cho các tác vụ quy mô lớn.

4. Ứng dụng:

- Tesla P40: Phù hợp cho các ứng dụng AI inference, chẳng hạn như nhận dạng hình ảnh, xử lý ngôn ngữ tự nhiên, và các tác vụ AI không yêu cầu tốc độ huấn luyện mô hình quá cao.

- Tesla A100: Phù hợp cho các ứng dụng đòi hỏi hiệu suất cực kỳ cao trong AI training, deep learning, và HPC, bao gồm các mô phỏng vật lý, nghiên cứu khoa học, và các tác vụ học máy phức tạp.

5.2. So sánh giữa Nvidia Tesla P40 và Nvidia RTX 3090

Mặc dù cả Nvidia Tesla P40 và Nvidia RTX 3090 đều là các GPU mạnh mẽ của Nvidia, chúng phục vụ các mục đích khác nhau và có các điểm khác biệt rõ rệt về hiệu suất, cấu trúc và tính năng.

1. Kiến trúc:

- Tesla P40: Sử dụng kiến trúc Pascal (thế hệ thứ 2), với các CUDA cores và Tensor Cores được tối ưu hóa cho các tác vụ học máy và AI.

- RTX 3090: Sử dụng kiến trúc Ampere (thế hệ thứ 3), với sự hỗ trợ mạnh mẽ cho ray tracing, AI, và các ứng dụng đòi hỏi tính toán đồ họa cao.

2. Hiệu suất:

- Tesla P40:

- 12 TFLOPS cho FP16 (half-precision), với bộ nhớ 24 GB GDDR5.

- Hiệu suất được tối ưu hóa cho inference AI và render đồ họa phức tạp.

- RTX 3090:

- 35.6 TFLOPS cho FP32, và 70.4 TFLOPS cho FP16, với bộ nhớ 24 GB GDDR6X.

- Mặc dù hiệu suất đồ họa cao hơn rất nhiều so với P40, RTX 3090 được thiết kế chủ yếu cho các tác vụ gaming và render đồ họa chuyên nghiệp, nhưng vẫn hỗ trợ tốt các tác vụ machine learning và AI.

3. Tính năng hỗ trợ:

- Tesla P40:

- Tích hợp Tensor Cores giúp tăng tốc các tác vụ học sâu, và được tối ưu hóa cho AI inference.

- RTX 3090:

- Tensor Cores thế hệ thứ 3 và Ray Tracing Cores, giúp tăng tốc các tác vụ AI, render đồ họa, và các ứng dụng thực tế ảo (VR) với chất lượng hình ảnh cực kỳ cao.

- Hỗ trợ DLSS (Deep Learning Super Sampling), giúp cải thiện hiệu suất render trong các trò chơi và ứng dụng đồ họa.

4. Ứng dụng:

- Tesla P40: Phù hợp cho các tác vụ AI inference, chẳng hạn như phân tích hình ảnh và xử lý ngôn ngữ tự nhiên.

- RTX 3090: Thích hợp cho gaming, render 3D, AI, và deep learning. Mặc dù không tối ưu hóa cho inference AI như Tesla P40, nhưng với hiệu suất mạnh mẽ của mình, RTX 3090 có thể xử lý các tác vụ AI và học máy quy mô nhỏ và vừa rất hiệu quả.

Xem thông số dòng card: RTX A2000

6. Tổng kết

Tóm lại, Nvidia Tesla là một giải pháp GPU mạnh mẽ, được thiết kế để đáp ứng nhu cầu tính toán phức tạp trong các lĩnh vực như AI, học máy và khoa học dữ liệu. Với khả năng xử lý song song và tích hợp công nghệ tiên tiến, Tesla không chỉ giúp tăng tốc các ứng dụng đòi hỏi hiệu suất cao mà còn mở ra cơ hội mới cho các nghiên cứu khoa học và công nghệ. Đây là công cụ không thể thiếu cho những ai đang tìm kiếm sự tối ưu trong công việc và nghiên cứu.

Mời bạn truy cập vào blog của VinaHost TẠI ĐÂY để theo dõi thêm nhiều bài viết mới. Hoặc nếu bạn muốn được tư vấn thêm thì có thể liên hệ với chúng tôi qua:

- Email: support@vinahost.vn

- Hotline: 1900 6046

- Livechat: https://livechat.vinahost.vn/chat.php

Xem thêm một số bài viết khác:

CPU Xeon là gì? | Bảng so sánh intel Xeon và Core i

Chip AMD là gì? | Bảng So sánh chip CPU AMD & CPU Intel

Tiếng Việt

Tiếng Việt English

English 简体中文

简体中文